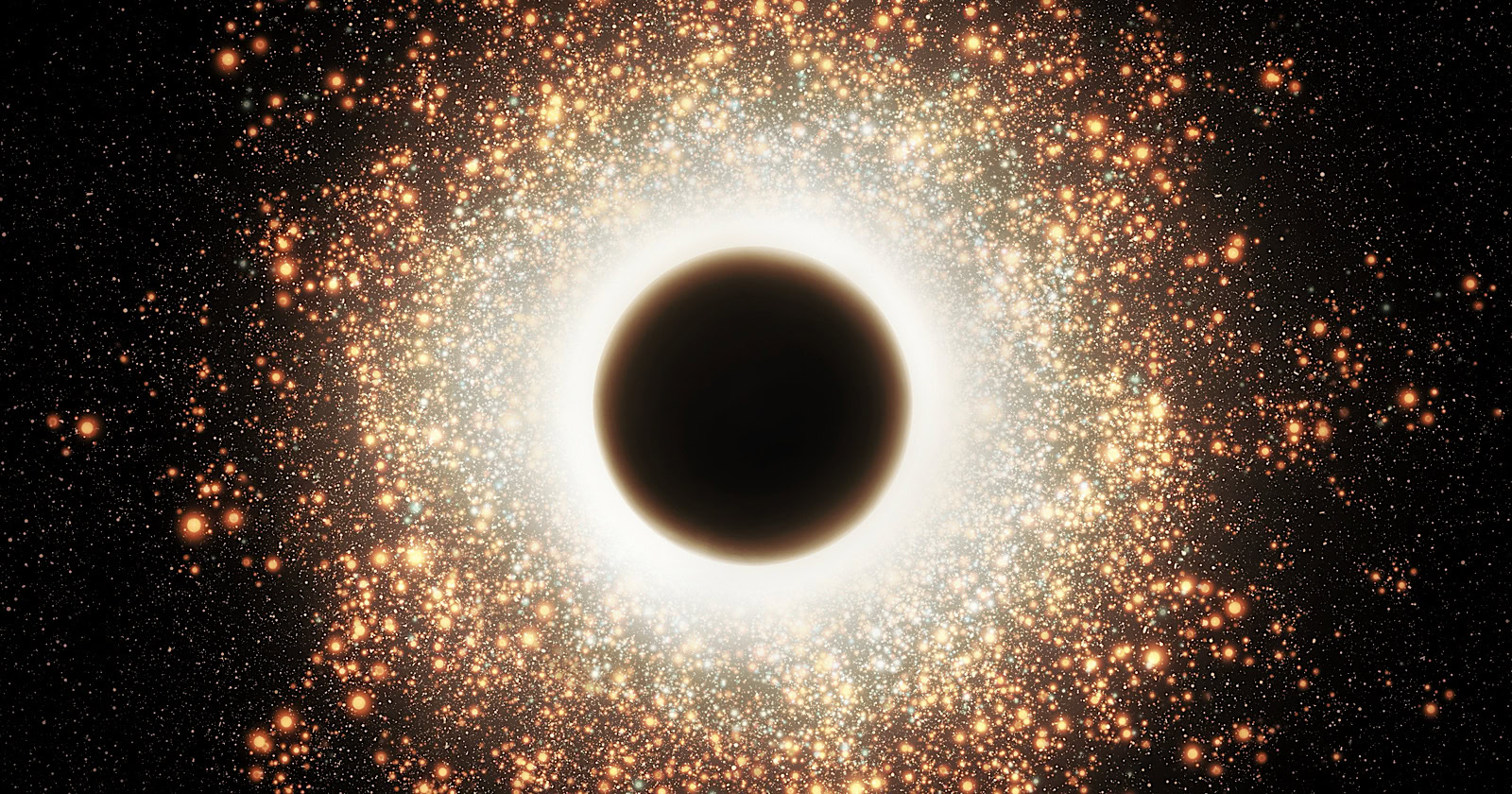

Как опытный веб-мастер с более чем двадцатилетним опытом работы в цифровой среде, я не могу не подчеркнуть важность понимания и адаптации к постоянно развивающимся алгоритмам Google. Последний выпуск подкаста «Search Off the Record» пролил некоторый свет на проблему SEO, из-за которой ваши веб-страницы могут потеряться в киберпространстве – в ужасных «черных дырах контента».

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)Недавно в подкасте Google «Search Off the Record» обсуждалась проблема поисковой оптимизации (SEO), из-за которой веб-страницы могут становиться невидимыми в результатах поисковых систем.

В последней статье член команды Google Search Аллан Скотт углубился в тему «черных дыр», возникающих в результате сборки страниц с ошибками, имеющих похожий внешний вид.

Иногда система Google может ошибочно группировать похожие страницы с ошибками, в результате чего обычные веб-страницы непреднамеренно включаются в эти кластеры.

Другими словами, если проблемы не будут устранены, эти веб-страницы могут не быть повторно посещены Google для индексации, что потенциально может привести к их удалению из результатов поиска даже после исправления ошибок.

В подкасте описывался процесс, лежащий в основе этого процесса, его влияние на активность веб-поиска, а также стратегии для менеджеров сайтов, позволяющие предотвратить упущение из виду их контента.

Как Google обрабатывает дублированный контент

Чтобы понять черные дыры контента, вы должны сначала узнать, как Google обрабатывает дублированный контент.

Скотт объясняет, что это происходит в два этапа:

- Кластеризация: Google группирует страницы с одинаковым или очень похожим содержанием.

- Канонизация: Google затем выбирает лучший URL из каждой группы.

Как страницы ошибок создают черные дыры

Проблема «черной дыры» возникает из-за кластеризации страниц ошибок, содержащих схожий контент, например, обычных сообщений «404 — страница не найдена». Страницы, на которых время от времени возникают ошибки или кратковременные простои, могут непреднамеренно попасть в эти группы ошибок.

Как эксперт по SEO, я гарантирую, что наша система дублирования эффективно предотвращает повторное сканирование связанных веб-страниц в кластере. Это помогает избежать попадания случайно кластеризованных страниц в то, что можно считать «мертвой зоной поисковой системы», даже после исправления первоначальных проблем. Следовательно, эти страницы могут быть исключены из индексов поисковых систем, что потенциально может привести к снижению органического поискового трафика.

Скотт объяснил:

«Элементы, которые наиболее заметны в группе, имеют более высокий шанс быть найденным. Меня беспокоит то, что на веб-сайтах возникают временные проблемы… Если они не загружаются, они могут нарушить отображение, заставив нас предположить, что сайт неисправен.

Как избежать черных дыр

Чтобы избежать проблем с черными дырами дублированного контента, Скотт поделился следующим советом:

- Используйте правильные коды состояния HTTP. Для страниц с ошибками используйте правильные коды состояния (например, 404, 403 и 503) вместо статуса 200 OK. Группировать можно только страницы, отмеченные как 200 OK.

- Создавайте уникальный контент для пользовательских страниц ошибок. Если у вас есть специальные страницы ошибок, которые используют статус 200 ОК (обычно в одностраничных приложениях), убедитесь, что эти страницы содержат определенное содержимое, чтобы предотвратить группировку. Например, укажите в тексте код и имя ошибки.

- Осторожно с тегами Noindex. Не используйте теги noindex на страницах с ошибками, если вы не хотите, чтобы они были навсегда удалены из результатов поиска. Этот тег явно указывает на то, что вы хотите удалить страницы, в большей степени, чем на использование кодов состояния ошибок.

Как специалист по цифровому маркетингу, я всегда стараюсь, чтобы мои обычные веб-страницы не путались со страницами с ошибками, следуя этим простым рекомендациям, гарантируя, что они останутся в индексе Google для удобства пользователей.

Регулярное наблюдение за сканированием и индексацией вашего веб-сайта поможет быстро обнаружить потенциальные проблемы с дублирующимся контентом.

В итоге

Когда страницы с ошибками воспринимаются как дублированный контент, это может привести к тому, что обычные страницы будут объединены с ошибками и исключены из результатов поиска Google, даже если ошибки были исправлены.

Чтобы предотвратить проблемы с дублированием контента, владельцам веб-сайтов следует:

- Используйте правильные коды состояния HTTP для страниц ошибок.

- Убедитесь, что настраиваемые страницы ошибок имеют уникальное содержимое.

- Следите за охватом сканирования и индексацией своего сайта.

Соблюдение лучших практик технического SEO имеет решающее значение для обеспечения надежного рейтинга в поисковых системах, и это неоднократно подчеркивали эксперты Google по поиску.

Полную дискуссию можно услышать в видео ниже:

Смотрите также

- Акции IRKT. Яковлев: прогноз акций.

- Анализ динамики цен на криптовалюту LSETH: прогнозы LSETH

- YouTube запускает платные курсы для большего количества каналов

- Google удаляет хлебные крошки из фрагментов результатов мобильного поиска

- Обзоры Google AI теперь предоставляют помощь в программировании

- Акции GCHE. Группа Черкизово: прогноз акций.

- Акции AGRO. РусАгро: прогноз акций.

- Акции AFKS. АФК Система: прогноз акций.

- Причина, по которой Google использует слово «Создатели»

- Google может заменить X (Twitter) последними сообщениями от

2024-12-05 20:08