- Не люблю хвастаться, но должен сказать, что я очень горжусь тем, что занял 4-е место на G50 SEO World Championships на прошлой неделе.

- Я выступаю на NESS, глобальном саммите по SEO для новостей и редакционного контента, 22 октября. Читатели Growth Memo получают скидку 20% по коду «kevin2025»

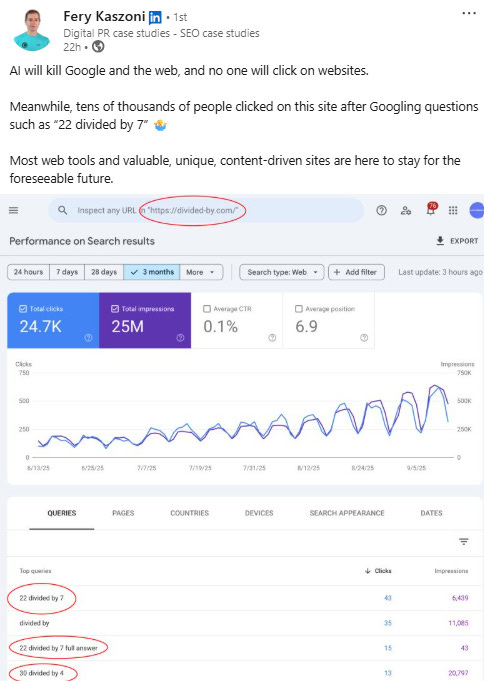

На протяжении долгого времени, ссылки с других веб-сайтов были ключевым фактором, определяющим, насколько заметен веб-сайт в результатах поиска.

Мы понимаем, что ссылки важны для обнаружения в результатах поиска на основе искусственного интеллекта. Однако, точное влияние этих ссылок на системы искусственного интеллекта, такие как Google’s AI Overviews, Gemini и ChatGPT, остается в значительной степени неясным.

Поиск на основе искусственного интеллекта меняет то, как веб-сайты находятся в сети, и компании теперь соревнуются за то, чтобы занять видное место в этих новых результатах, сгенерированных ИИ.

Как цифровой маркетолог, я постоянно задаюсь вопросом, важны ли обратные ссылки для позиций в поисковой выдаче, особенно сейчас, когда ИИ играет все более важную роль. Речь идет не только о том, важны ли они *вообще*, но и о том, *какие* обратные ссылки действительно помогают нам быть замеченными этими новыми поисковыми системами на базе ИИ.

До появления больших языковых моделей обратные ссылки были критически важны для ранжирования в поисковых системах. Этот анализ изучает, сохраняют ли они ту же силу в эпоху поисковых систем на основе искусственного интеллекта.

Я работал с Semrush, чтобы изучить 1000 веб-сайтов, анализируя, как часто они говорили об AI и сравнивая это с их данными о обратных ссылках.

Данные выявили четыре четких вывода:

- Авторитет, полученный за счет обратных ссылок, помогает, но это не все.

- Качество связи важнее количества.

- Самым удивительным образом, ссылки с атрибутом nofollow действительно имеют вес.

- Ссылки на изображения могут повлиять на авторитет.

Эти результаты проливают свет на то, как ИИ ранжирует веб-сайты, и они раскрывают стратегии, которые маркетологи могут использовать для повышения видимости своего сайта в результатах поиска.

Здесь мы расскажем о том, как проводили наши исследования, основных выводах из данных и, для наших платных участников, конкретных рекомендациях – полных сравнительных тестов производительности – чтобы помочь вам применить эти результаты.

Методология

Этот анализ рассматривает, как часто искусственный интеллект (ИИ) обсуждается на выборке из 1000 веб-сайтов. Данные поступают из AI SEO Toolkit от Semrush, который отслеживает поисковую видимость, связанную с ИИ, и веб-аналитику.

Вместе с командой Semrush я изучил количество упоминаний в:

- ChatGPT.

- ChatGPT с активированным поиском.

- Gemini.

- AI Обзоры от Google.

- Perplexity.

Мы не включили Claude.ai в этот анализ, потому что его пользователи обычно больше сосредоточены на создании контента, чем на поиске в интернете.

Мы проанализировали Долю Голоса и частоту упоминаний ИИ на ранее упомянутых платформах, рассматривая эти метрики наряду с количеством обратных ссылок, которые имел каждый сайт.

- Общее количество обратных ссылок.

- Уникальные домены-ссылки.

- Следуйте по ссылкам.

- Ссылки nofollow.

- Показатель авторитетности (метрика Semrush, далее именуемая Ascore).

- Текстовые ссылки.

- Ссылки на изображения.

Как понять этот анализ: корреляция данных Пирсона против Спирмена

Этот анализ исследовал взаимосвязь между переменными в данных, используя два метода: корреляцию Пирсона и корреляцию Спирмена.

Если вы знакомы с этими понятиями, перейдите к следующему разделу, где мы погрузимся в результаты.

Для всех остальных я разложу это по полочкам, чтобы у вас было лучшее понимание представленных ниже выводов.

Корреляции Пирсона и Спирмена — это оба способа измерения силы связи между двумя вещами. Оба приводят к числу между -1 и +1, где значения, близкие к -1 или +1, указывают на более сильную связь.

Корреляция наиболее сильна, когда коэффициент близок к +1 или -1, что указывает на четкую взаимосвязь. Коэффициент, близкий к 0, предполагает слабую или отсутствующую связь между переменными.

- Коэффициент корреляции Пирсона (Pearson’s r) измеряет силу и направление линейной связи между двумя переменными. Pearson рассматривает линейную корреляцию по данным, используя исходные значения. Этот способ измерения чувствителен к выбросам. Но, если связь имеет криволинейный характер или пороги, Pearson недооценивает ее.

- ρ (ро) Спирмена измеряет силу и направление монотонной связи, или то, движутся ли значения последовательно в одном или противоположном направлении, необязательно по прямой линии. Спирмен смотрит на ранговую корреляцию по данным. Он спрашивает, имеет ли тенденцию более высокий X сопровождаться более высоким Y; корреляция Спирмена спрашивает: «Когда что-то увеличивается, обычно ли увеличивается и другое?». Это корреляция, которая более устойчива к выбросам и учитывает нелинейные, монотонные закономерности.

Разрыв между коэффициентами корреляции Пирсона и Спирмена может означать, что приросты нелинейны.

По сути, определённый уровень должен быть достигнут, прежде чем X начнёт оказывать влияние на Y — это не происходит мгновенно.

Рассмотрение как коэффициентов корреляции Пирсона, так и Спирмена помогает определить, существует ли эффект порога – то есть, связь между вещами слабая до достижения определенного уровня, после которого она становится намного сильнее.

Вот быстрый пример того, что может показать анализ, включающий оба коэффициента:

Вложение небольшой суммы, например, 500 долларов, в рекламу, вероятно, не окажет существенного влияния на продажи. Однако, как только вы начнете тратить около 5000 долларов в месяц на рекламу, вы, вероятно, увидите стабильный рост продаж.

И это конец вашего урока статистики на сегодня.

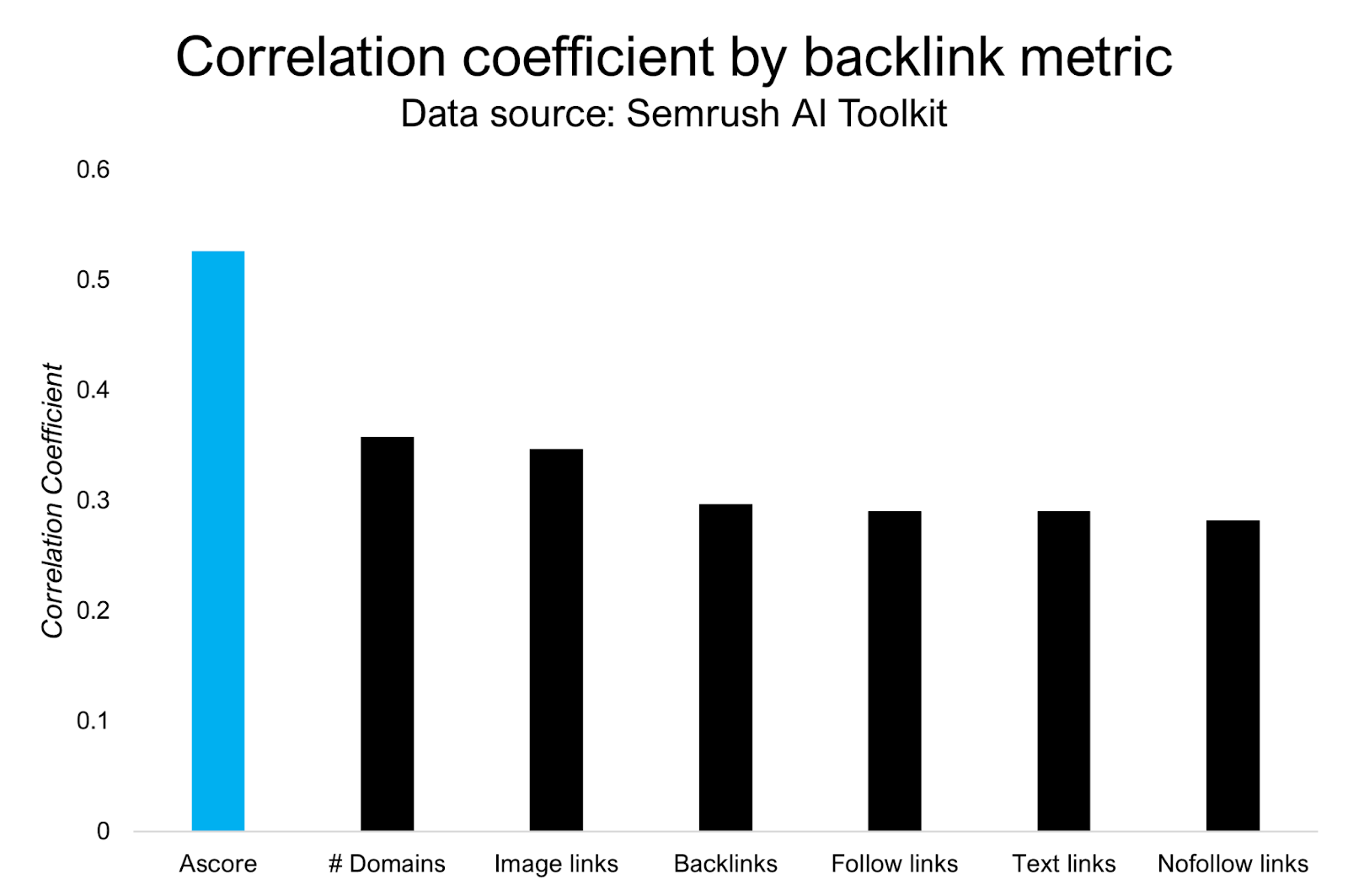

Вывод 1: Авторитет имеет значение для упоминаний ИИ, но это лишь часть головоломки.

Мы начали с изучения того, как количество ссылок, указывающих на веб-сайт, связано с его видимостью в поисковых результатах на основе искусственного интеллекта.

Вот что показали данные:

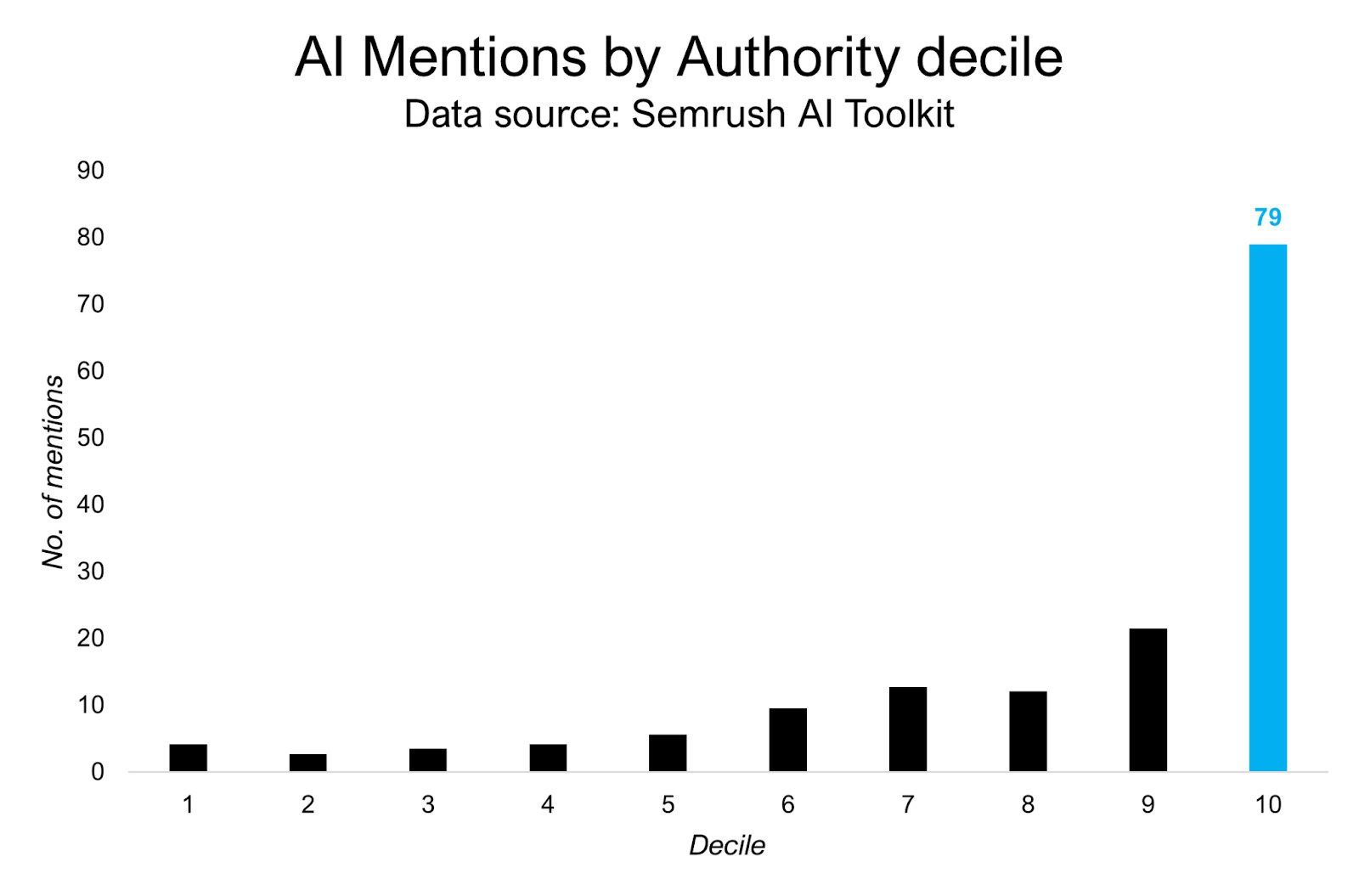

- Показатель авторитетности имеет умеренную связь с Долей голоса (SoV): Пирсон ~0.23, Спирмен ~0.36.

- Более высокая власть означает более высокую SoV, но выгоды распределяются неравномерно. Существует порог, который необходимо преодолеть.

- Авторитетность поддерживает видимость, однако она не объясняет большую часть различий. Это означает, что обратные ссылки оказывают влияние на видимость в AI, но есть и другие факторы, такие как ваш контент, восприятие бренда и т.д.

Также, количество уникальных доноров ссылок имеет большее значение, чем общее количество обратных ссылок.

В целом, ваш веб-сайт будет ранжироваться выше и получать больше видимости, если он получает ссылки с широкого спектра веб-сайтов, а не большое количество ссылок только с нескольких источников.

Вывод 2: Качество > Количество

Наш анализ показал наиболее значительную связь между Authority Score веб-сайта и частотой его упоминаний. Мы обнаружили корреляцию 0.65, используя метод Пирсона, и 0.57, используя метод Спирмена.

Вот как Semrush определяет показатель Authority Score:

Ascore – полезный индикатор качества обратных ссылок, хотя и не является идеальной мерой. Большие языковые модели оценивают качество по-разному, но наши данные показывают, что Ascore от Semrush – надежный способ его оценить.

В то время как большинство AI-моделей считают эту метрику важной для определения релевантной информации, ChatGPT Search и Perplexity склонны уделять ей меньше внимания, чем другие.

Удивительно, но обычный ChatGPT (без активированного поиска) весит Ascore больше всего среди всех моделей.

Как человек, который разрабатывает веб-сайты и отслеживает метрики на протяжении многих лет, я неоднократно замечал такую закономерность: авторитет действительно имеет значение, и это не устойчивый рост. Мы обнаружили, что медианное количество упоминаний — по сути, как часто о сайте говорят — значительно возрастает, когда вы попадаете в топ 10% сайтов, увеличиваясь примерно с 21.5 упоминаний до почти 79. Это не линейный рост; самые значительные улучшения происходят, когда вы действительно начинаете утверждаться как авторитет — в данном случае, как мы это измеряем, с помощью того, что мы называем Ascore. Незначительные улучшения не приносят большой пользы, важно достигать этих более высоких пороговых значений.

Дециль разделяет набор данных на десять равных групп. Представьте, что вы сортируете все свои точки данных от наименьшей до наибольшей — дециль представляет каждый 10% сегмент этих отсортированных данных.

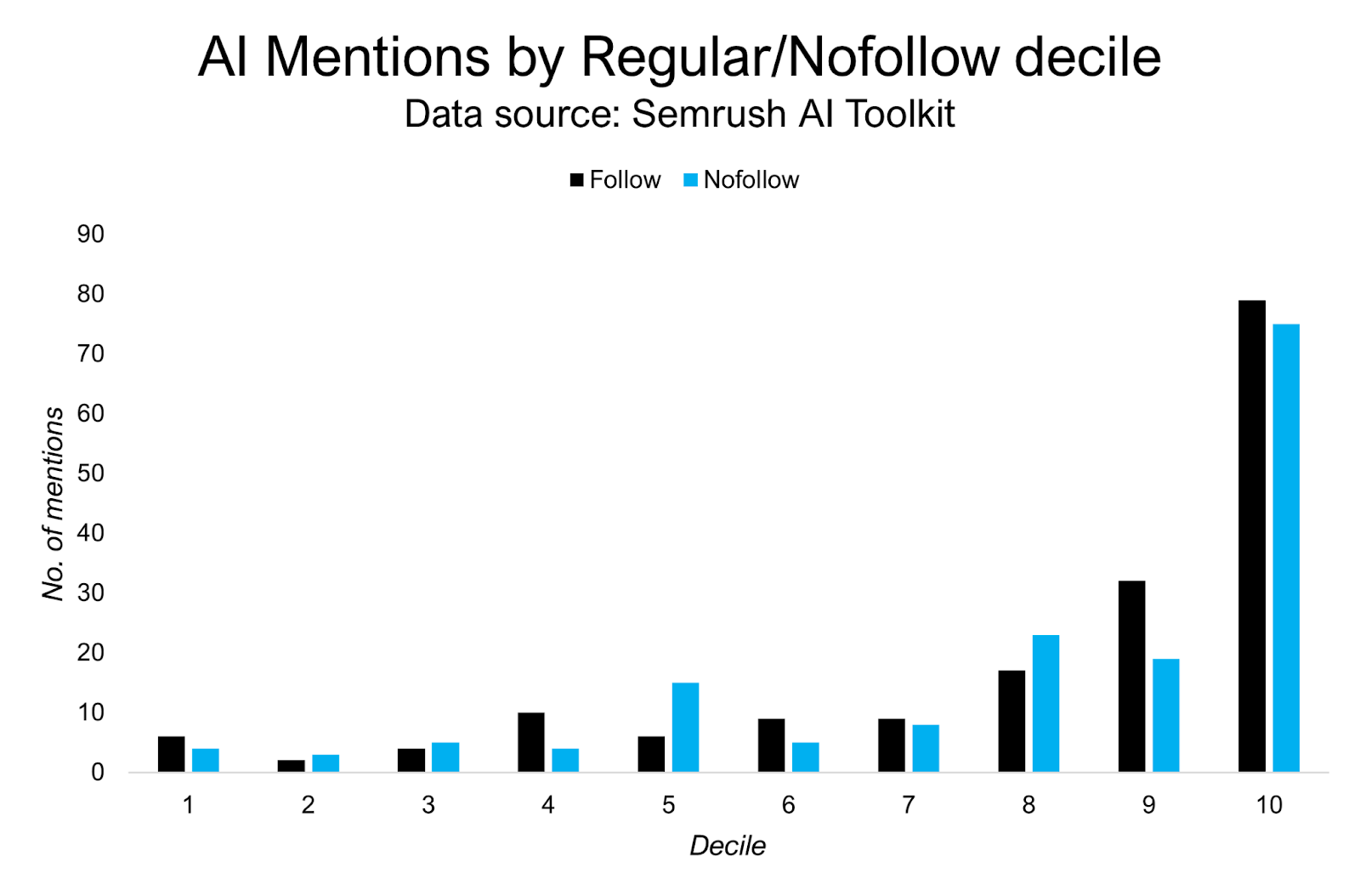

Вывод 3: Nofollow ссылки оказывают такое же влияние, как и обычные ссылки.

Главный вывод из этого исследования заключается в том, что использование тега ‘nofollow’ в ссылках, вероятно, не имеет существенного значения.

Важно понимать ценность ‘nofollow’ ссылок, поскольку их, как правило, проще получить, чем ссылки, передающие авторитет (‘follow’ ссылки).

Вот ключевое различие между большими языковыми моделями (LLMs) и поисковыми системами, такими как Google: Google уже учитывает ссылки, отмеченные как ‘nofollow’, но мы не знали *в какой степени* или *с какой целью* — для простого понимания веб-страниц или для влияния на поисковые рейтинги.

Значительные улучшения обычно становятся заметными только тогда, когда вы входите в топ-30% игроков. До этого вы не заметите большой разницы.

Перейдите по ссылкам → Упоминания:

- Пирсон 0.334, Спирмен 0.504

Ссылки nofollow → Упоминания:

- Пирсон 0.340, Спирмен 0.509

С другой стороны, AI Overviews от Google и Perplexity придавали наибольшее значение стандартным ссылкам и наименьшее — ссылкам, помеченным как ‘nofollow’.

И интересно, что Gemini и ChatGPT придают наибольший вес nofollow ссылкам (больше, чем обычным follow ссылкам).

Мне интересно, придает ли новая модель Gemini от Google большее значение ссылкам с атрибутом ‘nofollow’, чем предполагалось ранее. Аналогично, я подозреваю, что Bing, использующий ChatGPT, также может придавать этим ссылкам больший вес, возможно, после того, как увидел потенциальный сдвиг Google. Однако, это всего лишь идея на данный момент, и у меня нет никаких доказательств, подтверждающих это.

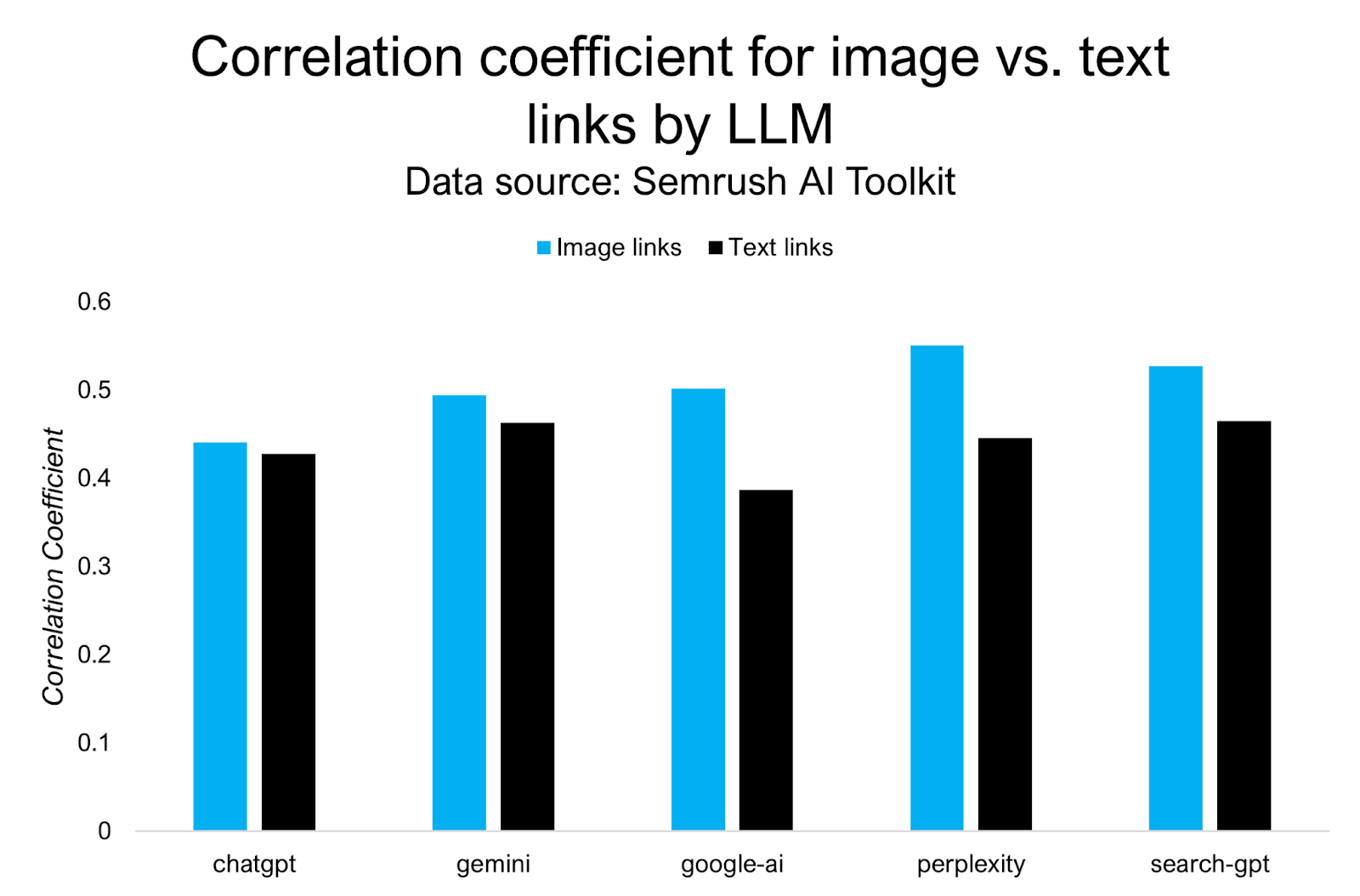

Вывод 4: Ссылки на изображения работают так же хорошо – а иногда и лучше.

Помимо текстовых обратных ссылок, мы также протестировали, имеют ли обратные ссылки на изображения тот же вес.

И в некоторых случаях они имели более тесную связь с упоминаниями, чем с текстовыми ссылками.

Но насколько сильный?

- Изображения против упоминаний: Пирсон 0.415, Спирмен 0.538

- Ссылки на текст против упоминаний: Пирсон 0.334, Спирмен 0.472

Ссылки на изображения действительно начинают приносить пользу, как только у вас уже есть определенный авторитет.

- Начиная с середины децильных слоев и выше, взаимосвязь становится положительной, затем усиливается и становится наиболее сильной в верхних децилях.

- В низких децилях Ascore (децили 1 и 2) связь между изображениями → упоминаниями слабая или отрицательная.

Если вы хотите, чтобы о вашем контенте говорили больше людей на Perplexity или Search-GPT, добавление изображений особенно эффективно.

- Изображения коррелируют с упоминаниями больше всего о недоумении и поиске-GPT (Spearman ≈ 0,55 и 0,53), а затем CHATGPT/Gemini (≈ 0,49-0,52), затем Google-AI (≈ 0,46).

Смотрите также

2025-10-01 16:42