По словам Мэтта Лэндерса, возглавляющего отдел отношений с разработчиками в Google Analytics, этот инструмент служит связующим звеном между системами обучения языковым моделям (LLM) и аналитическими данными.

Вместо работы с традиционными отчетами, вы можете просто задавать вопросы на обычном английском языке и получать мгновенные ответы.

Переход от традиционных отчетов

Сервер MCP предоставляет более удобный метод по сравнению с ручным перемещением по меню или созданием отчетов самостоятельно. Вместо этого вы просто задаете вопросы типа ‘Сколько пользователей у меня было вчера?’, и он немедленно предоставит требуемый ответ.

Во время демонстрации Ландерс использовал интерфейс командной строки Gemini (CLI) для сбора аналитической информации. Чтобы уточнить, CLI — это простой текстовый инструмент, который вы управляете в окне терминала.

Вместо этого, вместо того чтобы перемещаться по различным меню или интерфейсам, вы просто набираете вопросы или инструкции, и система отвечает с использованием повседневного языка, как будто это беседа с Gemeni на вашем компьютере или ноутбуке.

Как эксперт по SEO, могу сказать: Вчера, когда меня спросили о количестве пользователей, система точно предоставила общее число. Впечатляет то, что она смогла ответить на последующие вопросы, грамотно уточняя запросы в зависимости от контекста, без какой-либо дополнительной технической настройки с моей стороны.

Вы можете посмотреть полную демонстрацию в видео ниже:

https://www.youtube.com/watch?v=PT4wGPxWiRQ

Что Вы можете с этим сделать

Сервер использует административный API и API данных Google Аналитики, чтобы поддерживать широкий спектр возможностей.

В соответствии с проектной документацией вы можете:

- Получить информацию об аккаунте и имуществе

- Запускайте базовые и отчеты в реальном времени.

- Доступ к стандартным и пользовательским измерениям и метрикам

- Получите ссылки на связанные учетные записи Google Ads

- Получите подсказки по настройке диапазонов дат и фильтров

В качестве опытного вебмастера, для начала работы вам потребуется Python в качестве основного инструментария вместе с доступом к определенному проекту Google Cloud, где активированы определенные API. Кроме того, необходимы учетные данные приложения по умолчанию, предоставляющие права только на чтение данных из моего аккаунта Google Analytics.

Реальные случаи использования

Сервер особенно полезен в более сложных ситуациях.

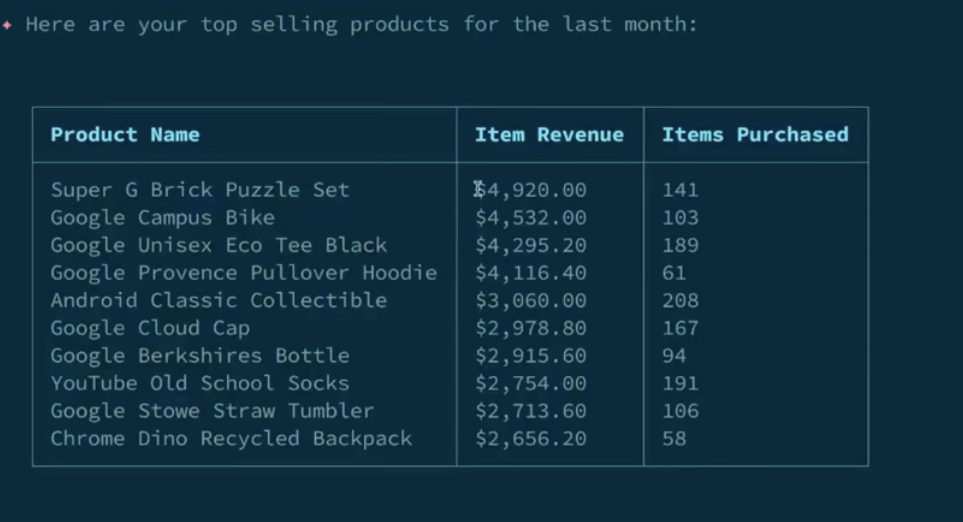

Как эксперт по SEO, я недавно участвовал в демонстрации, где запросил сводку эффективности наших лучших продуктов за последний месяц. К моему удовлетворению, система сначала представила эти данные, отсортированные по доходам от каждого товара. После дополнительного запроса она изменила порядок данных согласно количеству проданных единиц для каждого продукта.

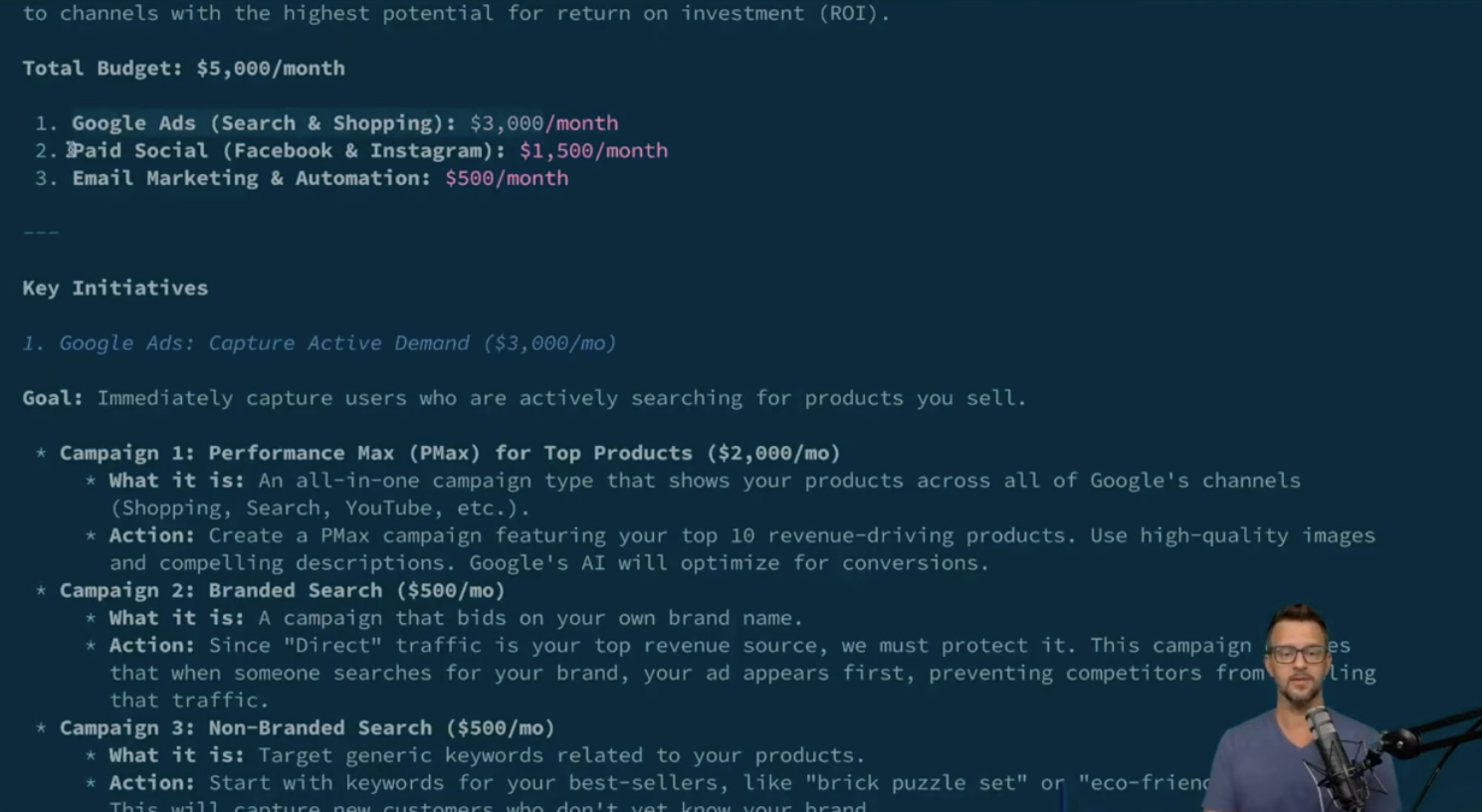

Позже он представил себе вымышленную ситуацию: управление ежемесячным маркетинговым фондом в размере 5000 долларов с целью увеличения выручки от продаж.

Система создала несколько отчетов, показывающих, что более четырехсот тысяч долларов выручки было сгенерировано посредством прямого и органического поиска. Впоследствии она предложила стратегию, включающую утвержденные бюджеты для Google Ads, рекламы в социальных сетях и email-маркетинга, все это подкреплено соответствующими показателями эффективности.

Как настроить это

Для настройки сервера можно использовать инструмент под названием pipx, который позволяет работать с приложениями Python в отдельных окружениях. После установки свяжите его с Gemini CLI, добавив сервер в ваш конфигурационный файл Gemini.

Шаги по настройке включают:

- Включение необходимых API Google в вашем проекте Cloud.

- Конфигурирование учетных данных приложения по умолчанию с доступом только для чтения к вашей учетной записи Google Analytics

- (Опционально) Настройка переменных окружения для более последовательного управления учетными данными в различных средах.

Сервер работает с любым совместимым клиентом MCPC, но Google подчёркивает полную поддержку Gemini CLI.

Как SEO эксперт, я хотел бы провести вас через процесс работы, используя примеры из предоставленной документации. Вы можете применять образцы запросов для таких задач как анализ статистики свойств, изучение поведения пользователей или оценка показателей трендовой производительности. Эти примеры станут вашими первыми шагами к освоению системы.

Заглядывая вперед

Google продолжает развивать проект, запрашивая мнение пользователей через платформы GitHub и Discord.

Как профессионал в области цифрового маркетинга, я недавно экспериментировал с сервером MCP и хочу сказать, что он предлагает захватывающее представление о потенциале будущего анализа естественного языка. Сейчас проект находится на экспериментальной стадии, но его практический подход действительно впечатляет.

Для маркетинговых команд этот инструмент может ускорить время реакции, устранив необходимость в дашбордах или кастомных отчетах. В то же время разработчики могут обнаружить способы оптимизации рабочих процессов путем создания автоматизированных инструментов или улучшения доступности аналитики для других.

Смотрите также

- Анализ динамики цен на криптовалюту PI: прогнозы PI

- Акции X5. Корпоративный Центр Икс 5: прогноз акций.

- 11 альтернатив копирования изображений для проверки плагиата

- Режим обучения OpenAI привносит управляемое обучение в ChatGPT

- Акции DATA. Группа Аренадата: прогноз акций.

- Google Tests Learn More Links After Ad Text

- Акции OZPH. Озон Фармацевтика: прогноз акций.

- 7 лучших конструкторов целевых страниц для 2026 года

- SEO-специалисты рекомендуют структурированные данные для поиска с помощью ИИ… Почему?

- Акции VKCO. ВК: прогноз акций.

2025-07-23 20:09