На протяжении многих лет я совершенствовал свои навыки с использованием инструментов SEO от Google. Несмотря на наличие множества платных альтернатив, бесплатный набор функций Google продолжает служить основой моего процесса оптимизации.

Использование этих инструментов предоставляет вам точную информацию о том, что Google считает значимым, предлагая уникальные и незаменимые инсайты, которые недоступны где-либо еще.

Я хотел бы поделиться с вами пятью инструментами Google, которыми я ежедневно пользуюсь для эффективных задач SEO. Вот краткий обзор каждого из них:

1. Консоль поиска Google (Google Search Console): Этот инструмент помогает мне отслеживать и поддерживать производительность моего сайта в результатах поиска, выявлять технические проблемы и понимать, как пользователи взаимодействуют с сайтом.

2. Аналитика Google (Google Analytics): С помощью этой мощной аналитической платформы я могу следить за трафиком веб-сайта, поведением пользователей и конверсиями, чтобы получать инсайты о том, что работает хорошо, а где необходимы улучшения.

3. Планировщик ключевых слов Google (Google Keyword Planner): Этот инструмент помогает мне исследовать ключевые слова, релевантные для моей аудитории, и находить новые возможности для создания контента и оптимизации.

4. Тенденции Google (Google Trends): Используя этот инструмент, я анализирую популярность поисковых запросов во времени и по разным регионам, что позволяет принимать информированные решения о стратегии контента.

5. Инсайты скорости страниц Google (PageSpeed Insights): Этот инструмент помогает оптимизировать скорость загрузки веб-сайта, предлагая рекомендации для улучшения производительности как на десктопе, так и на мобильных устройствах, что критически важно для положительного пользовательского опыта и ранжирования в поисковых системах.

B результате ежедневного использования этих пяти инструментов Google я способен улучшить свои усилия по SEO, принимать основанные на данных решения и достигать лучших результатов для управляемых мною веб-сайтов.

Световой маяк

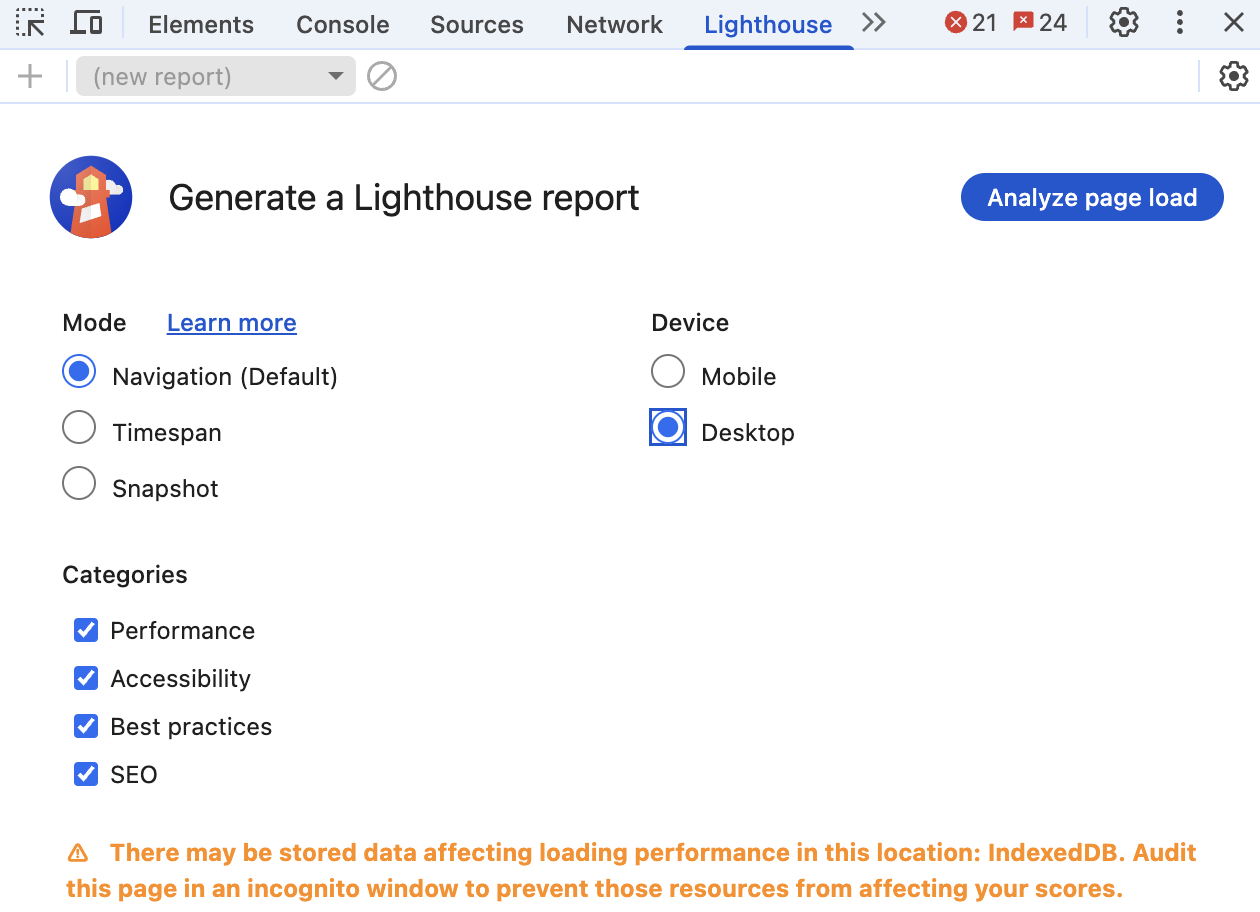

В первый раз я наткнулся на Lighthouse в инструментах разработки Chrome, словно обнаружил секретное руководство от Google.

Этот ресурс стал моим любимым выбором для быстрой оценки веб-сайтов, особенно когда клиенты обращаются ко мне с вопросом почему их эстетически приятные сайты не отображаются в результатах поиска.

Начало работы с Lighthouse

Доступ к маяку удивительно прост.

На любой веб-странице вы можете получить доступ к инструментам разработчика, нажав F12 на Windows или используя Command+Option+C на Mac. После открытия инструментов найдите вкладку Lighthouse среди них. Еще одним способом является правый клик по любому месту страницы, выбор пункта «Inspect», а затем нахождение вкладки Lighthouse в открывшемся интерфейсе.

Что отличает Lighthouse, так это его метод всесторонней оценки. Он анализирует пять важных аспектов: оптимизация скорости, соответствие рекомендациям для прогрессивных веб-приложений, внедрение лучших практик, обеспечение удобства пользователей и поисковая оптимизация.

Хотя это может не казаться напрямую связанным с поисковой оптимизацией (SEO), я обнаружил, что Google придаёт больший вес сайтам, которые эффективно функционируют для всех пользователей, поскольку это совпадает с их целями.

Подлинное понимание сообщества из реального мира

Сообщество разработчиков испытывает смешанные чувства по отношению к Lighthouse, и я понимаю почему.

По мнению списка (list), «Маяк (Lighthouse) является отличным решением, так как помогает найти быстрые улучшения в производительности и доступности.»

Как опытный вебмастер, я усвоил ценную урок от CreativeTechGuyGames: стремление к высоким позициям в поисковой выдаче не только включает оптимизацию для поисковых систем, но и требует поддержания равновесия между реальной производительностью сайта и тем, как эта производительность воспринимается.

Прямо скажу, я могу подтвердить это на собственном опыте, так как один клиент настаивал на достижении безупречного результата в 100% по всем категориям.

Мы потратили несколько недель на тонкую настройку нашей системы, но оказалось, что некоторые изменения негативно повлияли на пользовательский опыт. Вывод: относитесь к Lighthouse скорее как к полезному руководству, чем как к абсолютной истине.

Почему маяк важен для SEO

Основные аспекты SEO, такие как анализ метатегов, обеспечение мобильной доступности и устранение проблем с краулингем, могут показаться простыми, но имеют огромное значение.

Улучшение простых проблем, отмеченных Lighthouse, может значительно повысить рейтинг сайта в поисковой системе. Этот инструмент проверяет существенные аспекты такие как:1. Производительность и эффективность, гарантируя быструю и плавную загрузку вашего сайта для пользователей.2. Доступность, обеспечивая удобство использования контента для людей с различными способностями и ограничениями.3. Функции прогрессивных веб-приложений (если применимо), способствующие более плавному пользовательскому опыту на мобильных устройствах.4. Лучшие практики SEO, улучшая способы интерпретации и индексации вашего сайта поисковыми системами.5. Удобство для мобильных устройств, гарантируя легкость навигации по сайту на разных устройствах и размерах экранов.

- Правильная конфигурация вьюпорта для мобильных устройств.

- Наличие заголовка и описания в метаданных.

- Коды состояния HTTP.

- Описательный якорный текст.

- Реализация Hreflang.

- канонические теги

- Размер цели мобильного тапа.

Один из многих аспектов, вызывающих разочарование у разработчиков — непоследовательность оценок.

Согласно посту пользователя на Reddit, они просто повторно запустили аналитику без внесения каких-либо изменений, и оценка производительности варьировалась от 33% до 90%.

Я тоже сталкиваюсь с подобными ситуациями, поэтому регулярно провожу несколько тестов и обращаю внимание на закономерности вместо отдельных результатов.

Эффективное использование маяка

Мое главное предложение — воспользоваться областью «Быстрые победы», используя немедленные возможности. Для отслеживания прогресса сохраняйте результаты в формате JSON для дальнейшего использования и мониторинга успехов.

Всегда помните об этом мнении опытного разработчика: ‘Даже если достичь идеального балла 100 в области доступности, веб-сайт может оставаться неудобным для использования’. Эти оценки служат указателями, но не гарантируют качества.

2. PageSpeed Insights

Значение скорости загрузки страниц существенно возросло, когда ключевые показатели веб-производительности стали учитываться при ранжировании в поисковых системах.

Я регулярно проверяю его, особенно после обновления опыта страницы от Google, когда скорость сайта стала неоспоримым фактором ранжирования.

Понимание двойной природы ПСИ (PSI)

Как опытный вебмастер могу подтвердить, что PageSpeed Insights отличается уникальной комбинацией лабораторных данных, полученных из контролируемых тестовых сред, и полевых данных, отражающих реальные пользовательские опыты на основе отчета Chrome User Experience Report. Такой двойной подход предоставляет бесценные сведения для оптимизации производительности сайта как для поисковых систем, так и для реальных пользователей, делая это незаменимым инструментом в моем арсенале веб-разработки.

Этот двойной подход спас меня от оптимизационных лабиринтов больше раз, чем я могу посчитать.

Взамодействия реальных пользователей с вашим сайтом за последние 28 дней подобны ценным жемчужинам информации, предоставляющим понимание реального опыта использования сайта пользователями. В случаях, когда результаты лабораторных исследований казались неудовлетворительными, полевые данные часто показывали, что пользователи на самом деле наслаждались временем, проведённым на сайте.

Это обычно означает, что условия лабораторных тестов не совпадают с вашей реальной базой пользователей.

Взгляды сообщества на PSI

Сообщество Reddit имеет сильные мнения относительно PageSpeed Insights.

Оценка скорости, предоставляемая инструментами PageSpeed Insights, не соответствует фактической загрузке вашего сайта.

Хотя это может показаться прямолинейным, оно несет в себе элемент истины, поскольку оценка является по сути сжатой версией сложных измерений.

Практические стратегии оптимизации

Методом проб и ошибок я разработал систематический подход к оптимизации пси.

Стратегия Арзишера повторяет мою: «Я добавил плагин для кэширования вместе с минификацией HTML, CSS и JavaScript (WP Rocket)». Эти базовые улучшения часто приносят наибольшие выгоды.

Размер документа объектной модели (DOM) является ещё одним важным аспектом, который необходимо учитывать. Как обнаружил Фильдернутт (‘Fildernoot’), ‘я вставил код, увеличивший размер DOM примерно на 2000 элементов, и PageSpeed Insights это не понравилось.’ Теперь я стараюсь оценивать сложность DOM как часть своего регулярного рабочего процесса.

Важно сосредоточиться на оптимизации под мобильные устройства. Один из пользователей Reddit задал проницательный вопрос: «Каков ваш рейтинг для мобильных устройств? С десктопной версией всё понятно — хорошая тема оформления, хостинг LiteSpeed и плагин LSCache помогут справиться с ней.»

С моей точки зрения как опытного веб-мастера, я часто наблюдал разницу примерно в 20-30 баллов по производительности на мобильных устройствах по сравнению с десктопами. Важно признать, что большинство ваших пользователей, вероятно, обращаются к вашему сайту через мобильные устройства.

Уменьшающаяся отдача реальности

Вместо того, чтобы стремиться к «идеальному» базовому результату вещорок, целесообразно сосредоточиться на достижении «хорошего» статуса. Достижение улучшения с 50 до 80 часто является более целесообразным и значительным по сравнению с меньшим увеличением от 90 до 100.

Тест безопасного просмотра

Испытывая тест безопасного просмотра как необычную особенность в наборе инструментов для SEO может сначала показаться вам загадочным, но по личному опыту я могу утверждать о его незаменимой природе.

За одну ночь сайт клиента был скомпрометирован, отмечен браузерами как небезопасный и исчез из результатов поисковых систем. В результате их органический трафик упал до нуля за несколько часов.

Понимание роли безопасного поиска

Сервис безопасной навигации Google (Safe Browsing) защищает интернет-пользователей от потенциально опасных сайтов путем сканирования на наличие вредоносного программного обеспечения, мошеннических действий вроде фишинга и вводящего в заблуждение контента.

Согласно объяснению Lollygaqqindovakin, он быстро сканирует файлы, используя различные типы сигнатур и применяя методы машинного обучения.

Я регулярно посещаю инструмент прозрачности Google, размещенный на ежемесячной основе для всех сайтов моих клиентов. Этот инструмент указывает дату последнего сканирования Google каждого сайта и возможные текущие проблемы безопасности.

Использование интеграции Search Console позволит получать уведомления о возникновении проблем, однако я предпочитаю более превентивный подход.

Обеспокоенность и Опыт Сообщества

Сообщество Реддита выделило несколько важных моментов.

Как опытный веб-мастер, я заметил тревожную тенденцию, отмеченную NextDNS — ложные срабатывания. Проще говоря, это означает, что Google неправильно маркирует apple.com.aka dns.net как вредоносный сайт, но будьте уверены: такие случаи редки. Тем не менее, даже редкие ошибочные сигналы подчёркивают важность регулярного мониторинга для обеспечения бесперебойного функционирования нашей цифровой экосистемы.

Осознанные вопросы пользователей о конфиденциальности поднимают сомнения относительно сбора данных.

Согласно наблюдению Мера-бета, Google теперь будет отображать содержимое веб-страниц непосредственно, но для поисковой оптимизации (SEO) базовой безопасности безопасного поиска достаточно.

Почему профессионалы в области SEO должны обращать внимание

Когда система Безопасного Поиска отмечает ваш сайт как подозрительный, Google может:

- Удалите ваши страницы из результатов поиска.

- Отображать предупреждения пользователям при попытке посетить.

- Значительно сократите ваш показатель кликов.

- Влияние на сигналы доверия вашего сайта.

Я оказывал помощь множеству сайтов в решении проблем безопасности, что обычно занимает одну-две недели после устранения угрозы и подачи заявки на проверку.

Две недели без трафика и дохода могли бы стать серьёзной преградой на пути к успеху. Поэтому гораздо мудрее принимать предупреждающие меры вместо того, чтобы бороться с проблемой после её возникновения.

Лучшие практики безопасного просмотра

Мой список контрольных вопросов безопасности включает:

- Еженедельные автоматические сканирования с использованием API Безопасного Поиска на нескольких сайтах.

- Немедленное расследование любых предупреждений системы безопасности Google Поисковой консоли.

- Регулярные проверки сторонних скриптов и виджетов.

- Мониторинг областей пользовательского генерированного контента.

4. Google Тренды

Тенденции Google перешли от инструмента любопытства к стратегическому оружию в моем арсенале SEO.

В быстром цикле обновления продолжительностью 10 минут и с использованием продвинутого ИИ для определения трендов необходимо планировать контент и разрабатывать стратегию.

За пределами простого наблюдения за трендами

Многие профессионалы в области SEO упускают из виду, что Trends — это не только о том, чтобы видеть, что популярно. Я использую его для:

- Определите сезонные закономерности для планирования.

- Определяй снижающиеся темы, чтобы их избежать.

- Найти региональные вариации для локального SEO.

- Сравните эффективность бренда с конкурентами.

Соображения сообщества о трендах

Сообщество Reddit предоставляет сбалансированные взгляды на тренды Google.

Мальте Ландвер подчеркнул особое преимущество их ресурса: данные Google Trends предлагают уровень уникальности, который даже опытные специалисты по поисковой оптимизации (SEO), управляющие ежемесячным бюджетом в миллионы долларов, находят ценным при поиске ответов на конкретные запросы.

Если упростить, существуют определенные ограничения. Как объяснил Dangerroo:* ‘Тенденции измеряют популярность не на основе личных мнений, а скорее по частоте поиска’.

Это различие важно потому что уменьшение тренда не обязательно означает снижение общего количества запросов; речь идет только о снижении относительного интереса к поисковым запросам.

В специализированных областях чувства раздражения становятся сильнее. iBulliesDuummies выразили свое недовольство, заявив: «Google значительно ухудшил работу Google Trends, неспособный адекватно оценивать нишевые темы». Эта проблема кажется наиболее актуальной для бизнес-к бизнесу или технической терминологии с редкими поисковыми запросами.»

Стратегии Передовых Тенденций

Мои любимые тренды включают:

- Метод сравнения: Я всегда сравниваю термины между собой, а не рассматриваю их изолированно. Это позволяет лучше оценить относительные возможности, нежели абсолютные цифры.

- Категория фильтрации предотвращает путаницу между похожими терминами. Классическим примером является ‘ягуар’, где без фильтрации поиск автомобилей смешивается с поиском животных.

- Растущие тенденции в горнодобывающей промышленности: раздел «Росту» часто открывает возможности до того, как они становятся конкурентоспособными. Я успешно запускал контентные кампании, заметив эти тренды на ранней стадии.

- Географический арбитраж: Поиск тем, которые трендятся в одном регионе до их распространения, помогает подготовить контент заранее.

Обращаясь к дебатам об точности

Некоторые люди предпочитают использовать платные инструменты, такие как BuzzSumo или SEMrush вместо Google Trends для нахождения трендов и идей по контенту, поскольку считают эти платные решения более надежными.

Многие люди, включая Sneakysneakums, находят данные о трендах сбивающими с толку из-за их присущей относительности. Согласно Google News Initiative, это происходит потому, что на данные о трендах могут влиять различные факторы и они не всегда точно отражают абсолютную правду или реальность.

Нисходящая линия указывает на то, что относительная популярность поискового запроса снижается, но это не означает автоматически уменьшение общего числа поисковых запросов по этому запросу.

Я всегда комбинирую данные по трендам с оценками абсолютного объема от других инструментов.

Google Search Console

Ни один список инструментов SEO от Google не будет полным без Search Console.

Если вы рассматриваете другие инструменты как команду разведки, то Search Console выступает в роли вашей штаб-квартиры, предоставляя точные данные о том, как Google воспринимает и оценивает рейтинг вашего вебсайта.

Почему Google Search Console незаменима

В моей работе в качестве специалиста по цифровому маркетингу инструмент Google Search Console выделяется как бесценный ресурс, который предоставляет информацию, недоступную где-либо ещё. Как точно выразился Peepeepoopoobutler: ‘Google Search Console — это подлинное дело. Однако, в отличие от платформ для платной рекламы, он не предлагает предложений или рекомендаций.’

Вы совершенно правы! Хотя он не предлагает пошаговых рекомендаций для оптимизаций, предоставляемые им исходные данные бесценны.

Инструмент предлагает:

- Фактические поисковые запросы, которые привлекают трафик (а не только ключевые слова, которые вы считаете важными).

- Истинные показатели кликабельности по позиции.

- Решите проблемы с охватом индекса до того, как они снизят ваш трафик.

- Данные Core Web Vitals по всем страницам.

- Ручные действия и проблемы безопасности, которые могут значительно ухудшить позиции в рейтинге.

Проверяю Search Console ежедневно, и я не одинок.

Эффективный владелец сайта ВажныйСомнение6434 раскрыл: «Действительно, отслеживание в Google Search Console помогло моему сайту оказаться на первой странице».

Один только отчет о производительности помог мне выявить множество возможностей оптимизации.

Настройку на успех

Начинать работу с Google Поисковой консолью просто и приятно.

Согласно замечаниям Anotherbozo, нет необходимости проверять каждую страницу по отдельности; вместо этого продолжайте использовать первоначальный метод проверки.

Я предлагаю проверять уровень домена для полного доступа, поскольку это позволяет «верификацию права собственности по всему сайту или целому домену (включая вторичные уровни доменов).» Этот метод предоставляет данные, охватывающие все поддомены и протоколы.

Процедура валидации быстро завершается в течение нескольких минут, однако понимание, которое она дает, остается вечным. Удивительно наблюдать, как клиенты обнаруживают ранее неизвестные ценные ключевые слова, по которым они ранжировались, благодаря более тщательному анализу статистики их Google Search Console.

Скрытые возможности Поисковой консоли

Многие специалисты по SEO упускают продвинутые возможности, скрытые в Поисковой консоли.

Как опытный специалист по поисковой оптимизации (SEO), я искренне поддерживаю мощную стратегию, представленную Seosavvy: ‘Использование Google Search Console для исследования ключевых слов может быть невероятно эффективным’. Действительно, этот подход оказался бесценным в моём собственном SEO пути.

Анализ поисковых запросов, имеющих множество просмотров но меньше кликов, показывает области с пробелами в контенте и возможностями для оптимизации, которые ваши конкуренты упустили.

Организованные сводки данных значительно сократили время моей работы. Каспера Уинк обсудил использование схем и сказал: ‘Я уже разработал схему, включающую отзыв и совокупную оценку, и проверил её с помощью теста богатых результатов от Google’.

Используя консоль поиска Google, вы можете выяснить, эффективно ли Google распознает и понимает структурированные данные в реальном мире. Обычные инструменты тестирования не всегда могут гарантировать это.

Управление сайтами часто упускают из виду, но как верно отметил Yusteve: «Карты сайтов играют критическую роль; они помогают предоставить Google чёткие указания относительно структуры сайта».

Изучив отчет карты сайта, я заметил расхождения между представленными и проиндексированными веб-страницами, что привело к выявлению проблем с индексацией.

Проверка реальности: ограничения понимания

Вот где отзывы сообщества действительно ценны.

Как опытный вебмастер, я на собственном опыте понял, что Google Search Console (GSC) отображает только приблизительно половину реальной картины. Важно понимать это потому, что Google выборочно собирает и анонимизирует данные по соображениям конфиденциальности. То, что вы видите в GSC, является репрезентативной выборкой, а не каждым отдельным запросом.

Для некоторых пользователей интерфейс может показаться сложным в навигации, как свидетельствует заявление от UncleFeatuer6000: ‘Поисковая консоль Google для меня кажется немного запутанной’.

Это логично, так как инструмент значительно продвинулся вперёд и может потребоваться время, чтобы к нему привыкнуть. Я предлагаю начать с раздела производительности (Performance), а затем постепенно углубляться в другие области.

Пользователи разочарованы недавними изменениями, поскольку Шакти-басан заявил о том, что Google удалил данные из Google Аналитики из функции Поисковой консоли.

Отсутствие интеграции означает необходимость более ручной работы по соединению данных из различных инструментов, однако фундаментальные данные, предоставляемые Google Search Console, остаются невероятно ценными.

Усиление работы поисковой консоли

За годы ежедневного использования я разработал стратегии для максимальной ценности Google Search Console.

- Позиция 11-20 в золотом руднике: фильтр по ключевым словам, ранжированным на второй странице. Это ваши самые легкие победы, так как Google уже считает вас релевантными. Вам нужен лишь толчок для попадания на первую страницу.

- Оптимизация показателей кликабельности (CTR): сортируйте по показам, затем ищите низкий CTR. Эти запросы показывают спрос, но предполагают, что вашим заголовкам и описаниям требуется доработка.

- Запрос соответствий: Сравните, что вы думаете о своем рейтинге против того, что показывает Google Search Console. Разрывы часто указывают на возможности для контента или несоответствия намерениям пользователей.

- Анализ на уровне страницы: Не ограничивайтесь только общими показателями сайта. Производительность отдельных страниц часто указывает на технические проблемы или проблемы с контентом.

Интеграция Поисковой консоли с другими инструментами

Магия происходит, когда вы комбинируете данные из Search Console с другими инструментами:

- Используйте тренды, чтобы проверить, связано ли снижение трафика с падением позиций в поисковой выдаче или уменьшением поискового интереса.

- Перекрестно сверяйте рекомендации PageSpeed Insights с страницами, демонстрирующими проблемы основных веб-жизненно важных показателей в Поисковой консоли.

- Проверьте результаты исследования дружественности к мобильным устройствам с помощью Lighthouse по сравнению с отчетами о мобильной юзабилити.

- Отслеживайте статус безопасного просмотра непосредственно в разделе проблем безопасности.

Проще говоря, Мистер-бугимен спрашивал: «Разве вы не мониторите свои результаты без проверки Google Search Console?» Это вполне обоснованный вопрос.

Без доступа к Google Search Console вы по сути перемещаетесь без карты, полагаясь на приближения от внешних источников вместо данных непосредственно от самой Google.

Соединяя все вместе

Вот пять основных инструментов, которые служат надежной основой для успешной поисковой оптимизации (SEO). Они не только доступны бесплатно, но и официально рекомендованы Google, предоставляя понимание наиболее важных для него факторов.

Использование собственных инструментов Google поможет сосредоточиться на аспектах оптимизации сайта, которые действительно влияют на ранжирование в поисковых системах, так как эти инструменты настроены под алгоритмы и требования Google. Хотя специализированные платформы SEO могут предлагать больше функций, освоение этих Google-инструментов позволит поддерживать стратегию оптимизации в соответствии с тем, что важно для реального повышения рейтинга.

В обычной практике моего процесса я начинаю с исследования потенциальных возможностей в Search Console, проверяю концепции контента используя Trends, улучшаю техническую эффективность через Lighthouse и PageSpeed Insights, а также обеспечиваю безопасность при помощи проверок безопасного просмотра для сохранения установленных позиций поиска.

Имейте в виду, что эти инструменты отражают текущие направления внимания Google. Поскольку поисковые алгоритмы постоянно обновляются, будут обновляться и эти инструменты. Для того чтобы ваши стратегии SEO оставались в соответствии с развитием Google, критически важно быть информированным об их последних функциях и аналитике.

Успех в SEO зависит от эффективного сочетания этих пяти инструментов, понимания их границ и всегда учета того, что качество результатов сильно зависит от мастерства пользователя ими. После того как вы освоите эти пять инструментов, у вас появится прочная основа для ваших усилий по SEO.

Смотрите также

- Акции IRKT. Яковлев: прогноз акций.

- Акции AMEZ. Ашинский метзавод: прогноз акций.

- Поисковая выдача и обзоры, организованные с помощью искусственного интеллекта: как добиться заметности в новом ландшафте SEO

- Могут ли стартапы AEO / GEO превзойти устоявшиеся компании по производству инструментов SEO?

- Акции DSKY. Детский Мир: прогноз акций.

- Депозитция: Google использовал сигналы поиска и данные для обучения моделей искусственного интеллекта Gemini AI

- Google Ads Mixed Campaign Type Experiments Live For Some

- Акции LSNG. Ленэнерго: прогноз акций.

- Безумие мемкоинов! Кто король быков?

- Акции MRKC. Россети Центр: прогноз акций.

2025-07-28 04:11