Когда в 2021 году был запущен Performance Max, многие рекламодатели не знали, чего ожидать.

Рекламное решение обещало нам одну комплексную платную поисковую кампанию со всем ассортиментом продуктов от Google, однако предлагало лишь ограниченные опции для корректировки ее эффективности. Для маркетологов, привыкших к большему контролю над процессами, такая ограниченность была весьма неприятной.

После этого многое изменилось. За год Google активно проводил значительные изменения, многочисленные обновления были обусловлены вкладом рекламодателей.

Как опытный вебмастер, я заметил, что Google’s Performance Max (PMax) развивается, предлагая улучшенную прозрачность и дружественный пользователю функционал. Теперь мне легко управлять исключениями на уровне кампании, анализировать отчетность по каналам и собирать ценные инсайты на уровне активов — делая PMax более доступным и эффективным инструментом для моих нужд в цифровом маркетинге.

Это не значит, что кампания будет работать автоматически без вмешательства. Наоборот, сейчас у рекламодателей гораздо больше инструментов для управления эффективностью, выявления и решения проблем, а также реализации PMax с большей стратегической точностью по сравнению с прошлым.

Как работает максимальная производительность?

Максимальная эффективность — это формат кампании, который предоставляет рекламодателям возможность использовать все рекламные ресурсы Google через одну кампанию. Этот широкий инвентарь включает варианты размещения на различных платформах Google, таких как поисковые результаты, изображения, видео и прочее.

- Поиск (и партнеры по поиску).

- Экран.

- YouTube.

- Покупка.

- Откройте для себя.

- Карты (через локальные ресурсы, когда применимо).

- Gmail.

Вместо этого он использует технологии искусственного интеллекта и машинного обучения от Google для увеличения показателей конверсии, работая вместе с вашими текущими рекламными усилиями по поиску.

Вместо создания отдельных кампаний для каждого канала, вы подаете свои творческие материалы и определяете цель конверсии. Впоследствии умная система Google автоматически создает и размещает объявления среди пользователей, которых она предполагает наиболее вероятными для выполнения желаемого действия по конверсии.

Вместо ручного управления таргетингом по ключевым словам система автоматически обрабатывает его, учитывая такие факторы как намерения пользователей, действия, демографические данные и вашу конкретную аудиторию для решения, когда и где показывать ваши объявления. Проще говоря, платформа заботится о том, чтобы показывать ваши рекламные материалы в оптимальные моменты времени и на подходящих местах, основываясь на различных сигналах, таких как поведение пользователей, демография и определенная вами аудитория.

Изменение заключается в том, чтобы принять новую точку зрения: вместо того чтобы сосредотачиваться на контроле размещения и вариаций ключевых слов, ваша роль теперь состоит в предоставлении системе высококачественного контента, хорошо организованной информации и четких целей.

Бюджет и торги

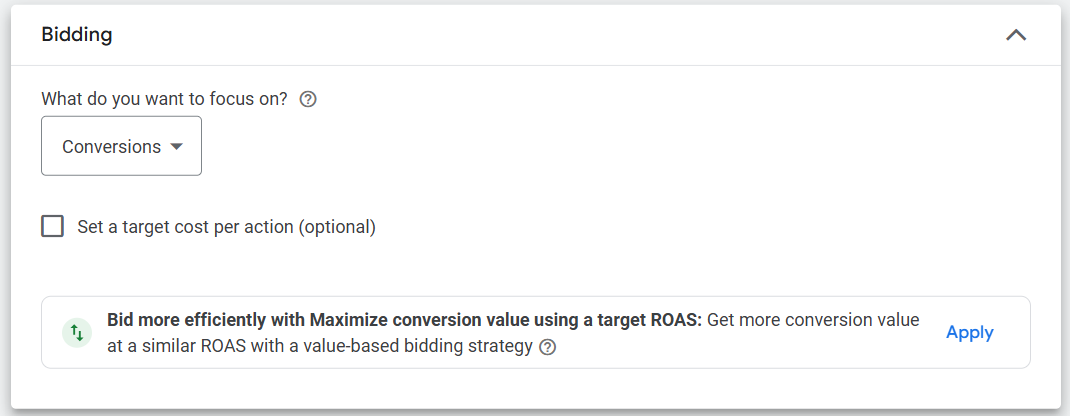

Performance Max поддерживает те же стратегии умного назначения ставок, что и в других кампаниях Google Рекламы.

- Максимизируйте конверсии.

- Оптимизируйте ценность конверсий.

Как опытный вебмастер, я хотел бы подчеркнуть, что при использовании стратегий ставок ‘Максимизация стоимости конверсии’ или ‘Максимизация количества конверсий’, вы можете задать опциональный целевой возврат на расходы на рекламу или целевую стоимость за приобретение соответственно. Это дает вам больше контроля над расходами на рекламу и помогает оптимизировать кампании для повышения эффективности.

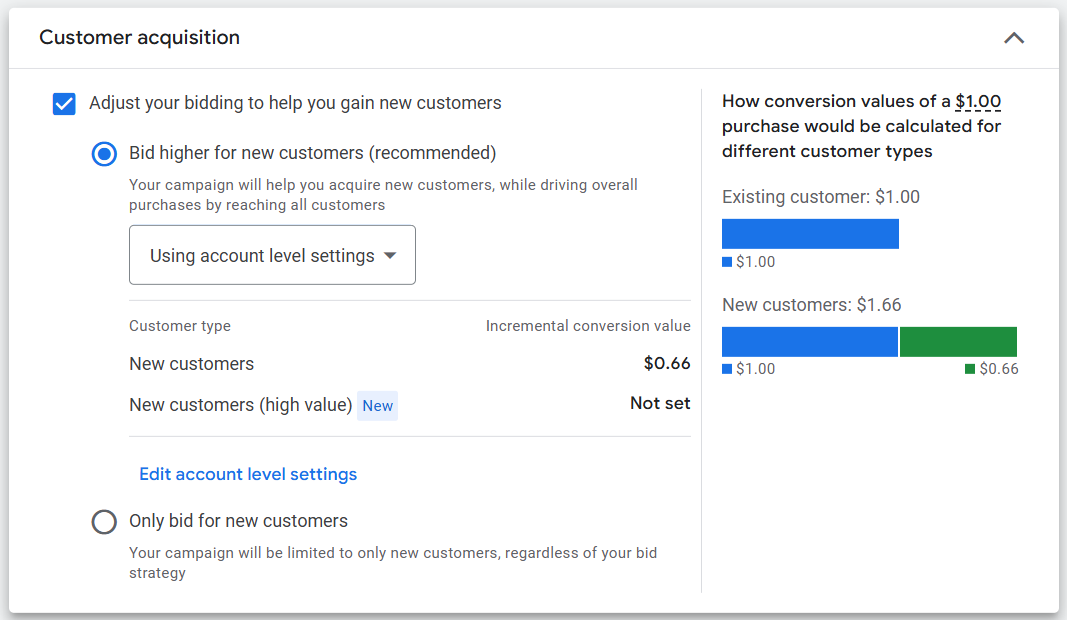

Далее у вас есть возможность устанавливать разные ставки за привлечение новых клиентов.

Изначально стратегия заключается в автоматическом повышении ставок для потенциальных новых клиентов. Соответственно, хотя кампания остается доступной для всех возможных покупателей, она предоставляет больше приоритета и инвестиций новым клиентам путем повышения их значимости.

Для использования нового метода привлечения клиентов требуются следующие входные данные:

- Тип стратегии назначения ставок должен быть «Максимизация ценности конверсии».

- Сегмент аудитории с не менее чем 1000 активными участниками для помощи в выявлении существующих клиентов.

Новая функция Google называется ‘Smart Bidder Exploration’, которая расширяет вашу таргетинг-стратегию за пределы традиционно успешных поисковых запросов для выявления потенциальных новых возможностей. Это не ограничено только для PMax, но хорошо сочетается со стратегией автоматизации этой платформы.

С финансовой точки зрения кампании PMax предлагают гибкость, однако поскольку они охватывают несколько каналов, ваши затраты могут ненамеренно распределяться на менее дорогие (не обязательно более эффективные) размещения, если не уделять должного внимания управлению и мониторингу.

Расположение, Язык и Расписание Рекламных Кампаний

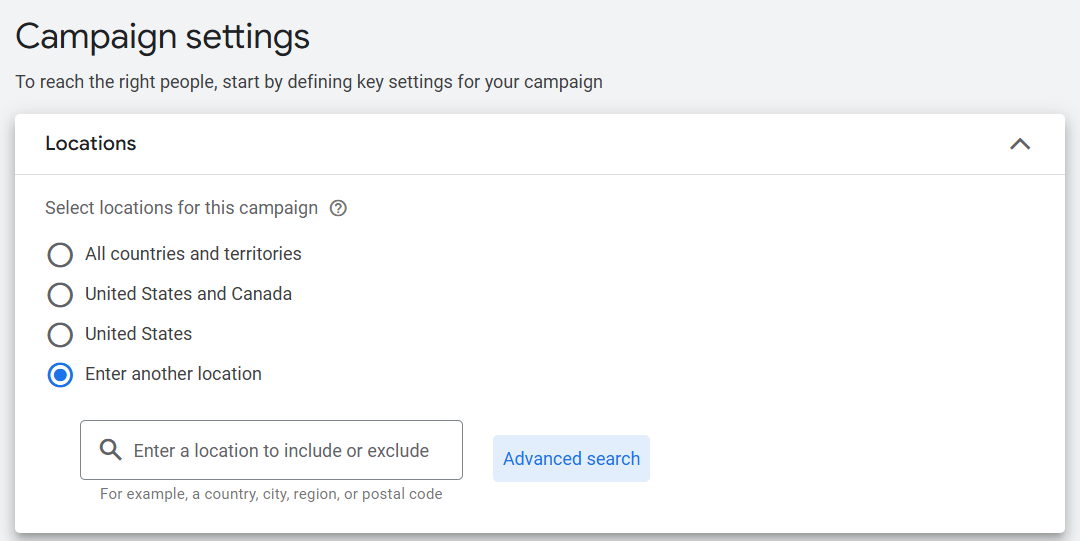

Следующим шагом в настройке новой кампании PMax будет ваше местоположение, язык и расписание показа объявлений.

Как специалист по цифровому маркетингу, я буду рад поделиться некоторыми советами по управлению несколькими локациями. Что касается Google Рекламы (Google Ads), вы можете легко обрабатывать большое количество отдельных местоположений с помощью редактора Google Ads. Если же вам удобнее работать онлайн, просто перейдите к опции «расширенный поиск», загрузите свои списки в интерфейсе одним разом.

После этого вы выберете целевые языки, расписание рекламы (если применимо) и даты запуска кампании.

Какими инструментами контроля на уровне кампании располагает Performance Max?

Изначально ранние версии Performance Max предоставляли рекламодателям минимальный контроль над кампаниями, но с тех пор это значительно изменилось.

По состоянию на 2025 год у вас теперь больше инструментов для формирования кампании высокого уровня, включая:

- Негативные ключевые слова на уровне кампании: Блокируйте нерелевантные запросы без использования списков на уровне аккаунта.

- Исключения брендов: предотвратите показ ваших объявлений при поиске по брендовым запросам, которые вам не нужны (полезно для розничных продавцов или посредников).

- Возрастные ограничения: Исключайте определенные возрастные группы от просмотра ваших объявлений.

- Целевая аудитория устройства: Исключите мобильный телефон, настольный компьютер или планшет если эффективность конверсии зависит от устройства (это исключающая функция вкл/выкл, а не рычаг корректировки ставок).

- URL содержит правила: управление тем, какие страницы продуктов участвуют в вашей кампании, используя структуру целевой страницы.

Использование этих средств контроля позволяет вносить коррективы, когда очевидно, что используемый подход не работает, хотя точность может быть ниже по сравнению с традиционными методами поиска.

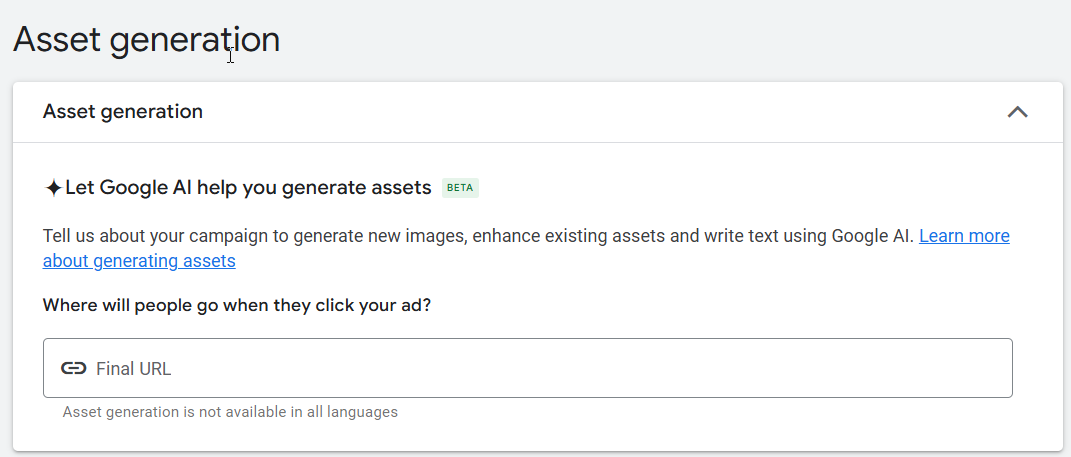

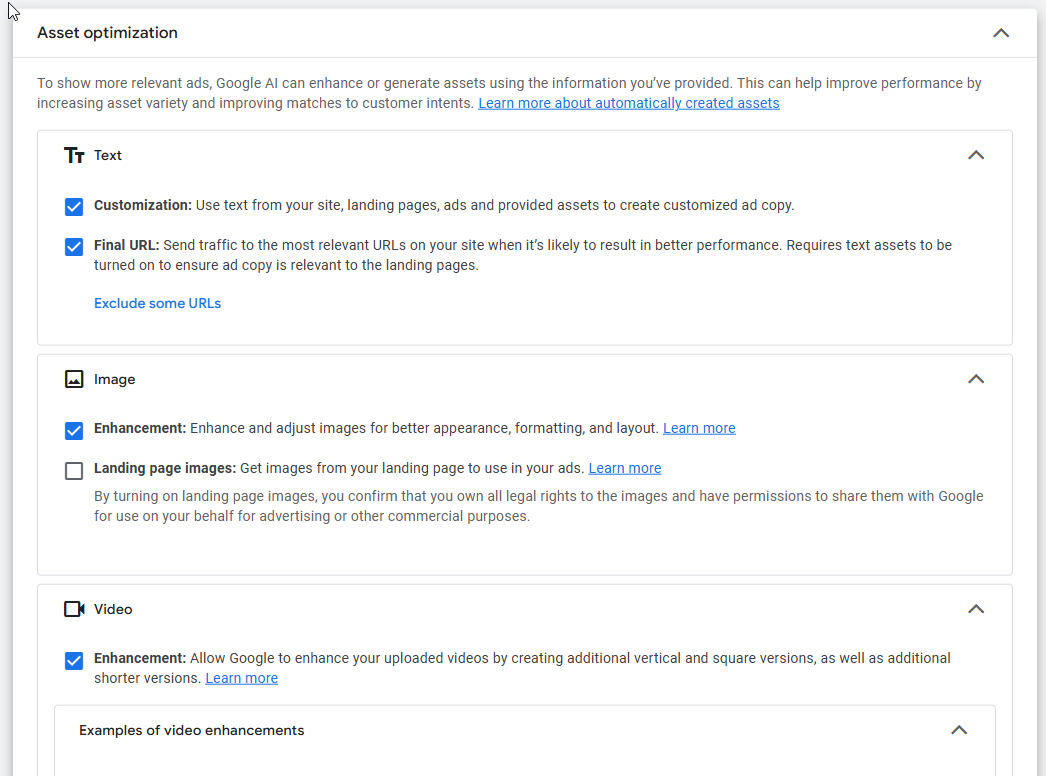

Автоматическое создание ассетов

Google может создать заголовки, описания и изображения для вас при необходимости, используя искусственный интеллект (ИИ), который анализирует ваш веб-сайт, предоставляет данные и учитывает прошлые показатели для генерации релевантных и подходящих ресурсов.

У вас есть выбор: активировать или игнорировать эту функцию. Если вы решите оставить ее активной, не забудьте регулярно проверять создаваемый контент на соответствие вашим ожиданиям. Хотя она часто работает хорошо, возможны случаи несоответствия предполагаемому сообщению или отклонения от постоянного тона вашего бренда.

В 2025 году компания Google представила новую линейку инструментов искусственного интеллекта для творчества, которая соответствует их бренду и позволяет пользователям вводить свои логотипы, шрифты и предпочтительные визуальные стили.

По моему опыту как опытного веб-мастера, я считаю полезным заранее установить четкие стандарты бренда для того, чтобы обеспечить создание вариаций изображений в соответствии с идентичностью моего бренда поисковиком Google. Таким образом, изображения, которые Google будет предоставлять пользователям, будут точно отражать суть моего бренда.

Группы активов (также известные как «объявления»)

Рассматривайте группы активов как продвинутую форму рекламных групп, часто именуемых группами PMax. Здесь происходит большая часть вашей конфигурации.

Каждая коллекция активов должна коррелировать с определенной темой, типом товаров или демографической категорией. Вот возможный сценарий: можно создать одну группу, фокусирующуюся на брендовых товарах, вторую — на небрендированных предметах, и третью — на промоакциях, связанных с сезонами.

Каждая группа содержит:

- Руководство по бренду: Вы можете контролировать внешний вид своего бренда путем ввода названия компании, логотипа(ов), собственных цветов и шрифта.

- Заголовки: Можно добавить до 15 заголовков, каждый из которых имеет ограничение в 30 символов.

- До пяти длинных заголовков можно добавить. У каждого из них ограничение в 90 символов.

- Описания: до пяти описаний, каждое длиной не более 90 символов.

- Изображения: можно добавить до 20 изображений. Рекомендуется сочетать ландшафтную, квадратную и портретную ориентации.

- Видео не требуется, но настоятельно рекомендуется. Если у вас нет видео, то в большинстве случаев Google автоматически создаст его в зависимости от полноты ваших ресурсов. Можно добавить до пяти видео.

- Сайтовые ссылки требуют как минимум двух, чтобы отображаться в объявлениях. Рекомендованное количество – не менее четырех.

- Призыв к действию (CTA): Это может быть автоматизировано, когда Google тестирует различные CTA или вы можете выбирать из разных вариантов.

- Аудитория Сигналы: Не забудьте добавить релевантные сигналы аудитории, такие как списки клиентов или сегменты по интересам рынка, чтобы помочь Google быстрее находить новых клиентов.

- Поиск тем: Добавить до 50 слов или фраз, которые люди используют при поиске вашего продукта или услуги.

- Финальный URL или ссылка на ленту новостей: Это место, куда будет направлен пользователь после нажатия на объявление.

У Google есть возможность использовать автоматическую оптимизацию ресурсов, включая следующие три категории:

- Настройка и расширение окончательного URL.

- Изображение: Улучшение и изображения целевой страницы.

- Видео: Улучшение.

Вы можете согласиться или отказаться, установив флажки напротив каждого из них.

Важно отметить, что сигналы аудитории следует рассматривать скорее как аудиторные «рекомендации».

Добавляя сигналы аудитории, ваши кампании могут быть нацелены на эти сигналы, но не исключительно.

Компания Google будет использовать данные о сходстве аудитории для поиска потенциальных покупателей с большей вероятностью приобретения ваших товаров или услуг, основываясь на их общих характеристиках.

На основе прошлых наблюдений рекомендуется вначале импортировать собственные списки клиентов для привлечения широкого круга потенциальных новых клиентов, которые могут заинтересоваться вашими предложениями.

Наконец, на этом уровне можно задать дополнительные типы активов (по желанию), включая:

- Акции/скидки.

- Цены.

- Звонки.

- структурированные фрагменты

- Лидирующие формы.

- Вызовы.

- Отобразить путь.

Какой вид отчетности предоставляет Performance Max?

Одной из главных критических замечаний по поводу Performance Max на ранних этапах было отсутствие видимости.

Говоря проще, рекламодатели не могли видеть, где показываются их объявления, какие ключевые слова приводят к кликам и какие дизайны объявлений являются эффективными. Это было похоже на управление кампанией в условиях полной таинственности.

К счастью, теперь это не так.

Хотя PMax пока не достигла уровня прозрачности традиционных рекламных кампаний, в течение последнего года Google представил значительные улучшения отчетности во многом благодаря предложениям рекламодателей. Вот некоторые ключевые аспекты для учета при оценке его эффективности сейчас.

Отчетность на уровне каналов

Это значительное обновление выделяется как одно из самых запоминающихся за последнее время. С новой функцией разбивки канала вы сможете наблюдать распределение вашей кампании по разным платформам.

- Поиск.

- YouTube.

- Дисплей.

- Gmail.

- Обнаружение.

- Карты.

Как профессионал в области цифрового маркетинга, для меня критично тщательно следить за распределением рекламного бюджета. Если я вижу, что большая часть конверсий происходит через каналы поисковых и медийных объявлений, но значительная доля расходов (40%) направляется на YouTube без ощутимых результатов, то это вызывает обеспокоенность – как если бы деньги были вылиты в пустую скважину.

Хотя вы не можете индивидуально настраивать ставки по каждому каналу, эта информация помогает вам принимать более обоснованные решения относительно креативных элементов, исключений или изменений в ваших группах активов.

Анализ поисковых запросов

Как специалист по цифровому маркетингу до проведения Google Marketing Live 2025, я использовал вкладку Insights в Google для лучшего понимания поисковых категорий, стоящих за производительностью моей рекламы. Этот функционал оказался ключевым в понимании типов запросов, которые поддерживают мои объявления.

В отличие от точных фраз, используемых в поисковых кампаниях, это более широкие темы, организованные по их релевантности. Они не являются точным соответствием, а скорее категорией или темой.

В этом году мы представляем улучшенную систему отчетности по поисковым запросам с большей детализацией, что позволяет рекламодателям внимательно изучить конкретные запросы пользователей, оказывающие влияние на их показатели. Пока это не является всеобъемлющим решением, но шаг к более практичным методам оптимизации.

Группа активов и эффективность на уровне отдельных активов

Теперь каждая группа активов включает показатели производительности такие как:

- Впечатления.

- Щелчки.

- Преобразования.

- Конверсионная стоимость.

- Показатель кликабельности (ПКТ).

Вы также можете проверить оценки на уровне активов (Низкий, Хороший, Отличный), чтобы определить успешные сочетания. Хотя эти количественные индикаторы могут показаться неясными, они помогут вам понять, какие заголовки или визуальные материалы требуют обновления.

Если инвестиционная группа продолжает показывать лучшие результаты по сравнению с другими, используйте ее как образец для подражания. Внимательно изучите стиль общения, креативный подход и определение целевой аудитории этой группы. После этого примените эти выводы к другим инвестиционным группам. Можно сказать: ‘Когда одна инвестиционная группа стабильно превосходит другие, рассматривайте её как шаблон. Изучите послание, тон и целевую аудиторию. Затем экспериментируйте с этими находками среди различных инвестиционных групп.’

Вклад сигнала аудитории

Хотя сигналы аудитории в PMax не используются как строгие механизмы фильтрации для таргетинга, теперь у вас есть возможность понять их эффективность в поддержке системы.

В качестве специалиста по цифровому маркетингу я использую вкладку ‘Insights’ для понимания того, какие конкретные группы пользователей — например, посетители вебсайта, потенциальные клиенты или сегменты, определённые пользователем — способствуют нашим показателям конверсии.

Если уровень взаимодействия с конкретным индикатором аудитории кажется минимальным, возможно стоит заменить его чем-то другим или создать новые группы аудиторий в соответствии с последними тенденциями поведения.

В чем разница между Performance Max и рекламными объявлениями поисковых систем (Search Ads)?

Перфоманс Макс, безусловно, является иной разновидностью типа кампаний.

Согласно Google, Pmax функционирует как дополнение к поисковым кампаниям с использованием ключевых слов, нацеленное на привлечение большего числа потенциальных клиентов. Важно отметить, что он не должен рассматриваться в качестве замены или альтернативы существующим кампаниям.

Существуют три ключевых различия между разными типами кампаний.

- Размещений.

- Намерение.

- Настройки таргетинга.

Ниже приведена сравнительная таблица, показывающая различия между этими тремя типами кампаний.

| Особенность, характеристика |

Максимальная эффективность |

поиск |

Генерация спроса |

| Каналы |

Весь инвентарь Google |

Поиск и Поиск Партнёров |

YouTube, Discover, почта G |

| Нацеливание |

Автоматизировано (сигналы аудитории и темы поиска опциональны) |

Ключевой слово на основе |

Двойники, кастомные сегменты, ремаркетинг |

| Творческий |

Ассет-базированный |

Текстовая реклама |

Реклама на основе изображений и видео |

| Отчетность о прозрачности |

Улучшение продолжается, но всё ещё автоматизировано |

Высокий |

Режим |

| Идеально для |

Электронная торговля, омниканальность |

Таргетинг, ориентированный на намерения |

Визуальное повествование и высокий спрос на привлечение внимания |

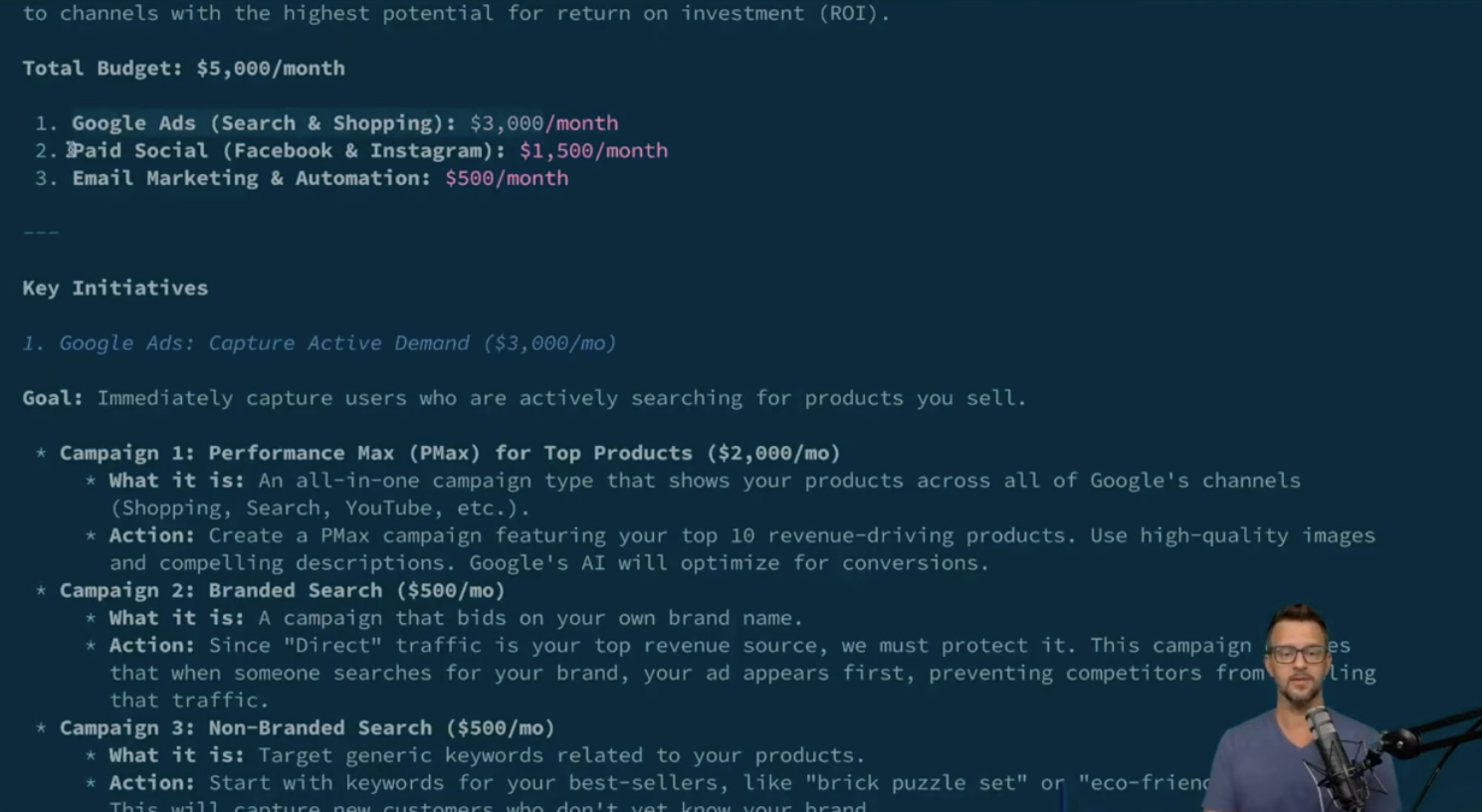

Обычно оптимально сочетать PMax с Поиском вместо полной замены последнего. Кроме того, если вы уже управляете видеокампаниями или кампаниями в формате Дисплей, то Demand Gen может оказаться более эффективным для достижения целей верхней части воронки.

Какие преимущества имеет Performance Max?

Performance Max упрощает администрирование кампаний и расширяет ваше влияние на всех платформах Google. Однако истинное преимущество заключается в переходе от базовой автоматизации к использованию Performance Max как стратегического инструмента для роста.

Вот что она может предложить при правильном использовании:

- Упрощенный доступ ко всем каналам Google: вместо создания и управления отдельными кампаниями для Поиска, Индикации (Display), YouTube и Открытия (Discovery) PMax объединяет эти усилия. Это позволяет вам достигать клиентов, где бы они ни находились – в сети, при поиске или просмотре видео.

- Эффективность в креативной поставке: Загруженные вами ресурсы (текст, изображения и видео) автоматически смешиваются и сочетаются для создания комбинаций, адаптированных под каждого пользователя и размещение. Это экономит время на тестирование креативов и облегчает запуск кампаний полного охвата без ручного управления десятками вариантов рекламы.

- Умная оптимизация через AI: PMax использует сигналы в реальном времени, такие как намерения поиска, поведение просмотра, устройство, местоположение и время суток, для определения момента и места показа рекламы. Это значительно превосходит ручное регулирование ставок или их корректировку. Для рекламодателей с надёжным отслеживанием конверсий Smart Bidding может существенно повысить эффективность со временем.

- Открытие новых возможностей конверсии: поскольку вы не ограничены списком ключевых слов или узкими параметрами таргетинга, Performance Max может помочь обнаружить новые аудитории и места размещения, которые иначе могли бы остаться незамеченными, особенно актуально для товаров с широкой привлекательностью или при расширении на новые рынки.

- Усовершенствованное управление кампаниями: PMax снижает операционную сложность. Вместо раздельной оптимизации множества кампаний, каналов и стратегий можно управлять бюджетами, креативами и отслеживанием конверсий в одном месте. Это облегчает согласование внутренних команд вокруг целей производительности.

Принимая это во внимание, преимущества становятся очевидными при тщательной и продуманной настройке кампании. Автоматизация не является быстрым решением, но она может значительно повысить эффективность при наличии подходящих данных.

Кому стоит использовать Performance Max?

Рекламщики, которые открыты экспериментам, имеют надежные показатели конверсии и стремятся расширить свое присутствие за пределами одной маркетинговой платформы, находят Performance Max наиболее эффективным.

Но это не универсальное решение для всех.

Вот объяснение того, кому может быть полезно это попробовать и кто должен проявить осторожность перед этим.

Если что-то из этого вам подходит, настоятельно рекомендуем добавить Performance Max в стратегию вашей кампании.

- Вы являетесь брендом электронной коммерции. PMax имеет глубокую интеграцию с Google Merchant Center, что делает его отличным решением для ритейлеров, стремящихся расширить рекламные кампании в категории ‘Shopping’, одновременно задействуя дополнительные платформы, такие как YouTube и Discover.

- У вас есть значимые цели конверсии и точное отслеживание.

Без четко определенных и отслеживаемых действий конверсии Pmax не будет знать, к чему оптимизировать стратегию. Будь то формы заявок, покупки или телефонные звонки, чистые данные критически важны.

- Вы хотите расширить охват без управления каждым размещением рекламы. Для небольших команд или тех, кто выполняет несколько обязанностей одновременно, PMax может помочь упростить управление кампаниями и при этом повысить эффективность.

- У вас есть высококачественные творческие активы в различных форматах. Чем больше вы предоставляете системе для работы (изображений, видео, рекламного текста), тем выше ваши шансы на привлечение пользователей во всех местах размещения. Искусственный интеллект Google выполняет большую часть тяжелой работы, но ваше участие определяет потолок.

- Вы исследуете новые аудитории, продукты или регионы. При запуске на новом рынке Pmax может быстро собрать данные путем расширения охвата по сравнению с поисковыми кампаниями в одиночку. Просто внимательно отслеживайте ранние сигналы.

С моей точки зрения как опытного вебмастера, сразу же погружаться в PMax может быть не самым мудрым решением для вас. Было бы разумнее разработать тщательно продуманную стратегию перед тем, как начать, чтобы обеспечить плавное плавание по этому динамично меняющемуся цифровому ландшафту.

- У вас есть узкоспециализированные или B2B потребности в таргетинге, требующие точности.

- Ваши конверсии малочисленны, проводятся в офлайн формате или трудно отследить.

- Вы хотите полный контроль над размещением объявлений, ставками и сообщениями в любое время.

По сути, PMax наиболее эффективен для рекламодателей, которые отдают предпочтение результатам и имеют четкие цели, подкрепленные достаточным количеством данных для автоматизированных процессов. Если это описывает вашу ситуацию, может быть полезным попробовать.

5 Лучших Практик Для Performance Max

Чтобы максимально раскрыть потенциал Performance Max, крайне важно не только создать кампанию, но и организовать ее для эффективного обучения, контролировать изменяемые параметры и внимательно следить за ключевыми показателями эффективности.

Вот пять способов подойти к этому:

Начните с сильных сигналов аудитории.

Предоставление правильных исходных данных для Google не только влияет, но и значительно сокращает период обучения, тем самым гарантируя более точное направление вашей кампании.

Вместо того чтобы классифицировать их исключительно по демографическим признакам, подумайте об организации вашей аудитории на группы с использованием таких критериев, как намерения или стадия жизненного цикла клиента. Это может охватывать кастомные сегменты, посетителей веб-сайтов и списки из систем CRM, среди прочих.

Инвестируйте в качественное творчество по всем форматам

Один из самых больших разрывов в производительности в PMax происходит от слабой или отсутствующей креативной составляющей.

Google ценит разнообразие типов контента для оптимальной работы: квадратные и пейзажные фотографии, вертикальные видео, несколько названий и описаний. Незаполнение важных форматов (например, видео) может привести к автоматически сгенерированному контенту, который может неточно отражать ваш бренд.

Старайтесь создавать как минимум три-пять сильных креативов каждого формата в каждой группе активов.

3. Опирайтесь на отчеты — даже если они не идеальны

В PMax система отчетности заметно улучшилась по сравнению с традиционными методами поиска. Важно регулярно оценивать результаты на уровне каналов, собирать инсайты от групп активов и анализировать тенденции поисковых запросов.

Если одна группа активов показывает более высокую эффективность по сравнению с другими, изучите используемые ими сообщения и визуальные материалы. Затем используйте полученные знания для улучшения производительности остальных групп.

Активно Используйте Исключения И Правила Преобразования

Вместо ожидания проблем установите меры безопасности такие как отрицательные ключевые слова, исключения по брендам и правила для URL с самого начала. Также решите заранее, что будет считаться ценным конверсией в вашем аккаунте.

Вместо этого, умный бидинг ориентирован на достижение значительных результатов, избегая поверхностных показателей и малоперспективных клиентов.

Выберите соответствующую цель и цели для стратегии размещения ставок

Важно иметь хотя бы какое-то представление о том, какой ценность представляет для вас клиент.

При установлении стратегии торгов опирайтесь на показатели прошлых результатов, такие как Целевая стоимость привлечения клиента (CPA) или Целевой возврат инвестиций в рекламу (ROAS), чтобы начать работу.

Установка слишком высоких или слишком низких целей может привести к значительной волатильности в эффективности кампании.

Как профессионал в области цифрового маркетинга, я часто замечаю, что наши брендированные поисковые кампании обычно обеспечивают значительно более высокий возврат на рекламу (ROAS) по сравнению с необрендованными кампаниями. Это происходит потому, что пользователи, которые ищут конкретное название бренда, чаще совершают конверсию, поскольку уже знают и признают наш бренд, делая эти кампании более выгодными.

Вместо того чтобы выстраивать цели конверсии на основе брендовых ключевых слов, подумайте об их установке по небрендовым ключевым словам. Этот подход может помочь расширить вашу целевую аудиторию, потенциально увеличивая число конверсий и улучшая общую производительность, поскольку ограничение себя только брендом может привести к меньшему охвату и меньшим конверсиям.

Настройте свою следующую кампанию с максимальной производительностью (Performance Max) для успеха.

Со временем Performance Max значительно развился от своего начального этапа. Он предлагает большую гибкость, улучшенную прозрачность и идеально подходит для рекламодателей, стремящихся расширить свой охват при сохранении контроля.

Как SEO эксперт я заметил последние улучшения, в особенности обновления отчётов и инновационные творческие инструменты. Это говорит о том, что Гугл действительно прислушивается к нашим мнениям как рекламодателей, показывая хотя бы некоторую реакцию на наши отзывы.

Достижение успеха с помощью PMax в значительной степени зависит от стратегии. Оптимальные результаты достигаются при использовании точных данных, надежных ресурсов и преданного человека, не боящегося углубляться в детали.

Если ты готов управлять машиной, здесь есть настоящий потенциал.

Смотрите также

2025-07-24 04:41