Совсем недавно я перешел от приоритетного использования ключевых слов к акценту на темах в SEO — объясняя, почему такой ментальный сдвиг становится все более важным для устойчивой видимости не только в поисковых запросах, но и в больших языковых моделях.

На этой неделе давайте сосредоточимся на стратегии. Понимание изменений критически важно, однако для их последовательного внедрения внутри команды требуется иной подход.

В этом выпуске Аманда и я разбираем:

- Как создать и использовать тематическую карту и матрицу (с шаблоном карты для премиум читателей).

- Почему глубокое понимание вашей аудитории критически важно для истинной тематической глубины.

- Руководство по внутренним и внешним ссылкам по темам (с рекомендациями инструментов).

- Для премиум-читателей: Практические советы по оценке эффективности SEO по темам.

Если вы нацелены на создание долгосрочного и органического онлайн-присутствия и репутации для вашего бренда (не просто ищете обходные пути для AI summaries), вот ваше руководство.

Как реализовать стратегию SEO на основе тематического подхода

На прошлой неделе мы обсудили, как нужно перейти от ключевых слов к темам (если вы еще этого не сделали).

А что, если вы не совсем уверены в том, как применить этот подход на практике среди вашей команды?

Поговорим о том, как это сделать.

Чтобы обеспечить долгосрочное и настоящее присутствие в интернете вместо временного через манипулятивные тактики SEO, ваш бренд должен продемонстрировать поисковым системам и системам управления юридическим маркетингом (Legal Marketing Management systems), что он является экспертом в областях, релевантных для услуг, предоставляемых вашей целевой аудитории.

Вы сделаете это путем:

- Создание карты родительских тем.

- Используя исследование аудитории и персоны как инструменты, создавать контент через.

- Расширяя с помощью подтем и создания контента «нулевого объема», так как контент на краю добавляет глубину.

- Оптимизация внутренних и внешних ссылок с использованием подхода, основанного на темах.

Постройте карту ваших родительских тем

Для начала вам необходимо построить карту темы.

Если вы ранее не создавали документ или таблицу на вашем Google Диске, содержащую ваши основные темы (основные тематические области) и подтемы (подтемы), сейчас появилась возможность сделать это.

Это первый шаг в создании подробной матрицы тем для поисковой оптимизации, основанной на персонажах.

Тема матрицы служит стратегическим руководством, объединяя основные темы, связанные подтемы и различные виды контента для глубокого рассмотрения конкретного вопроса, улучшая ваше присутствие в поисковых результатах.

Перевод данного текста на более простой и естественный русский язык: Этот процесс гарантирует соответствие контента запросам пользователей, адаптацию к конкретным группам аудитории и использование возможностей поисковых систем для повышения видимости. Он также устанавливает план по наращиванию экспертизы в релевантных темах и предотвращению конкуренции между несколькими страницами за одни и те же ключевые слова.

Если вы новичок в этом, то заметите, что это отличается от традиционных списков ключевых слов. Вот возможная структура: (Для новичков) Возможно, вы обнаружите отличие от стандартных списков ключевых слов. Структура может выглядеть примерно так: … (Для экспертов) Если ранее с этим не сталкивались, эта система будет отличаться от прежних списков ключевых слов и возможно иметь другую организацию.

После завершения плана темы вы выберете ключевые слова из вашей галактики ключевых слов, чтобы они соответствовали основной теме и каждой отдельной странице.

Вместо того чтобы зацикливаться на отдельных ключевых словах, вы будете организовывать контент вокруг тематической структуры, сосредоточившись на удовлетворении уникальных потребностей различных пользовательских персонажей или идеальных профилей клиентов (ICP) в вашем целевом рынке. Позднее мы оптимизируем его под релевантные поисковые запросы, что облегчит поиск и доступ к вам для тех, кого вы обслуживаете.

Для начала построения списка родительских тем вам нужно:

- Определите точные темы, которые должен владеть ваш бренд. С этого и нужно начинать. (И многие из вас уже имеют их под контролем.)

- Инвентаризируйте существующий контент: Какие темы вы уже охватываете? Какие темы на самом деле необходимо покрыть? Где есть пробелы? Которые из них конвертируют лучше всего?

- Убедитесь, что вы зарегистрировали все свои основные предложения (т.е. функции, услуги, основные продукты) как отдельные темы или подтемы.

Как определить ключевые темы родителей

Чтобы начать процесс, если бы это было вашим личным брендом или сайтом, начните с определения ключевых пяти-десяти основных тем, которые отражают основную сущность вашего продукта или области знаний.

Эти ‘контейнеры’ являются местом, где должен располагаться каждый другой фрагмент контента, исходя из его логической принадлежности, независимо от пользовательского профиля, стадии в воронке продаж или цели поиска.

Считайте их основополагающими столпами или ключевыми темами вашего бренда, если хотите. Эти темы служат базой для всей информации на ваших веб-страницах, в конечном итоге возвращаясь к ним.

Вот как их определить:

1. Начните с ваших предложений.

- Какие услуги вы предоставляете?

- Какие функции или продукты вы продаете?

- Какие проблемы вы решаете?

2. Группируйте предложения по темам.

- Какие из этих предложений могут быть объединены в более широкую тему?

- Какие высокоуровневые разговоры постоянно возвращаются к вашим пользователям?

3. Уточнение по релевантности.

- Вы стремитесь к темам достаточно широким, чтобы охватить множество подтем, но при этом конкретным, отражая ваш уникальный авторитет в области ваших экспертных знаний.

Давайте рассмотрим воображаемый бренд для потребителей напрямую (DTC), с дополнительными предложениями B2B: ЭкоДом. (Хотя ему нужно более подходящее название, мы продолжаем). 😄

Kind Habitat предлагает предметы интерьера и устойчивые ресурсы, которые безопасны для окружающей среды. Все это доступно через компактный интернет-магазин. Кроме того, они предоставляют решения по дизайну жилых и коммерческих помещений.

Наше внимание охватывает разнородную группу, которая включает домовладельцев, арендаторов, управляющих как жилой, так и коммерческой недвижимостью, а также архитекторов и строителей, уделяющих особое значение устойчивости и экологичности в своей работе.

Учитывая эту перспективу, все продукты электронной коммерции и услуги по дизайну можно разделить на пять ясных, пусть даже упрощенных, основных тем: 1. Дизайн пользовательского интерфейса и опыта; 2. Разработка и управление продуктами; 3. Стратегии маркетинга и продаж; 4. Электронные торговые платформы и интеграции; 5. Веб-аналитика и оптимизация.

- Устойчивый дизайн интерьера.

- Экологически чистые строительные материалы.

- Жизнь без отходов

- Экологичный шоппинг мебели.

- Модернизация зеленого дома.

Каждая создаваемая ими единица контента должна быть связана с одной или несколькими ключевыми темами, что помогает сформировать сильную и устойчивую экспертизу в их конкретной области.

1. Стратегии бюджетирования и экономии: Изучите эффективные способы управления финансами, составления бюджета и накопления денег для достижения ваших будущих целей.

2. Управление долгами: Узнайте, как быстро и эффективно погасить долги, минимизируя проценты по кредиту.

3. Пенсионное планирование: Откройте стратегии создания богатства и подготовки к комфортной пенсии.

4. Основы инвестирования: Начните инвестировать в акции, облигации и взаимные фонды, освойте основы управления портфелем.

5. Кредитное управление: Улучшите свой кредитный рейтинг, разберитесь с кредитными отчетами и принимайте обоснованные решения по кредитам и кредитным картам.

6. Инвестиции в недвижимость: Исследуйте возможности для инвестиций в недвижимость и научитесь делать разумные покупки недвижимости.

7. Налоговое планирование: Минимизируйте свою налоговую нагрузку через стратегическое планирование и воспользуйтесь налоговыми вычетами и льготами.

8. Страхование: Защитите себя, свою семью и свои активы с помощью подходящих страховых полисов.

9. Планирование наследства: Планируйте будущее и обеспечите распределение ваших активов согласно вашим желаниям после вашей смерти.

10. Личные финансы для женщин: Расширьте свои финансовые возможности благодаря советам, специально разработанным для женщин, включая инвестиции, бюджетирование и развитие карьеры.

Далее вы будете работать над расширением вашей карты тем, начиная с исследования аудитории.

Используйте Исследование Аудитории И Персонажи

Сейчас самое время воспользоваться персонами, в которые ваш бренд серьезно инвестировал средства. Вам следует определить: 1) кому вы предлагаете решения; и 2) как могут варьироваться их вопросы в зависимости от конкретной персоны, цели, целевой группы или категории отрасли.

Но как вы узнаете, что определили правильные людей (персоны) и их запросы?

Вы можете потратить десятки тысяч долларов, инвестируя в глубокое исследование покупательских персон.

Если вы новичок и еще не создали команду продаж или клиентов, поощряйте вашего основателя изучить электронную почту, сообщения в LinkedIn и аналогичные платформы для поиска ценной информации.

Согласно статье Аманды Нативидад «Трансформация исследований аудитории в идеи контента», которую я настоятельно рекомендую, она предлагает использовать исследования аудитории для разработки идей контента.

Отвечая на вопросы предоставляет возможность делиться ценным, информативным контентом, так как каждый вопрос раскрывает пробел в знаниях, который можно заполнить. Ссылка: ‘Сила вопросов: Проектирование для вовлечения в связанном мире’, автор Джон Мэда, 2014 год.

Другими словами, вам нужно интегрировать выявленные пробелы в знаниях с основной структурой вашей темы. Или можно сказать, включить обнаруженные пустоты в вашем понимании в более широкую структуру вашего предмета.

При оптимизации основной темы, не забывайте учитывать различные цели по всей теме и воронке продаж через рассмотрение множества углов, проблем и точек зрения. Этот подход часто называют ‘оптимизацией в стиле ранча’ (или Ranch-style SEO).

Инвестиции в этот метод приносят захватывающее дополнительное преимущество: вы получаете персонализированный контент, который глубоко изучает темы и предоставляет уникальные точки зрения, органически способствуя более широкому обсуждению предмета.

Ваши подписчики могут быть значительно расширены различными способами в зависимости от аудитории, которую вы обслуживаете, и проблем, с которыми она сталкивается, предоставляя множество возможностей для развития вашего контента.

Люди:

- Основная аудитория.

- Созданные персонажи.

- Несколько секторов (если применимо к вашему продукту или услуге)

Проблемы:

- Основная проблема/потребность, которую решает ваш бренд для каждой аудитории.

- Уникальные проблемы, с которыми сталкивается каждая персона, которую решает ваш бренд.

- Основные проблемы, уникальные для нескольких секторов (и в терминологии этих секторов).

Давайте пересмотрим наш гипотетический сценарий с участием компании Green Sanctuary, которая специализируется на экологически дружелюбном дизайне интерьера и имеет небольшой онлайн магазин.

Вот что бы выглядели их «люди и проблемы», которые они оптимизировали бы под свои основные темы:

Люди

- Целевые аудитории: домовладельцы, арендаторы, управляющие недвижимостью, строители, дизайнеры.

- Созданные персонажи:

Владелец дома:

Стэн, 45 лет, высокооплачиваемый работник, второй раз покупает дом в пригороде и хочет провести устойчивую реновацию.

Арендатор:

Николь, 31 год, средний доход, долгосрочно арендует контролируемую по цене квартиру в большом городе, привержена принципам устойчивого развития, изучает экологически чистый домашний декор и дизайн.

Управляющий недвижимостью:

Квинн, 25 лет, зарабатывает средне, начинающий менеджер недвижимости в маленькой местной фирме, которая ценит безотходное строительство и устойчивую реновацию.

Строитель:

Джей Пи, 57 лет, имеет высокую зарплату, владеет устойчивой строительной фирмой, ищет подход без отходов и низкого уровня токсинов для новых зданий и приоритезирует энергоэффективный дизайн в роскошных домах.

Дизайнер интерьера:

Сидней, 29 лет, зарабатывает средне, младший или средний сотрудник коммерческой компании по дизайну интерьеров, ищет продукты и планы устойчивого меблирования и дизайна. - Множественные сектора (если применимо к вашему продукту или услуге): жилая недвижимость, управляющие компании для многоквартирных домов, портфели недвижимости, коммерческая недвижимость, устойчивые строительные фирмы, частные владельцы жилья и арендаторы, заинтересованные в устойчивом дизайне.

Рассмотрите возможность расширения своего охвата, создав несколько персон аудитории (3–5) для каждой категории аудиторий.

После сбора всех необходимых данных об аудитории вы должны приступить к изучению проблем, с которыми сталкиваются каждая конкретная группа аудитории, тип личности и сегмент отрасли в рамках каждого релевантного темы для таргетирования.

После того как вы тщательно обсудили основные темы (и объяснили ключевые характеристики, продукты, услуги, вызовы, с которыми сталкивается ваша целевая аудитория, и вопросы, которые они часто задают), можно углубиться в контент, предлагающий новые точки зрения, актуальные мнения и исследующий текущие события внутри вашей индустрии или о ваших продуктах/услугах.

Это… много контента.

Используя визуальное представление тематической карты от Аманды, вот как это может выглядеть… только для одной родительской темы.

Ты мог просто продолжать идти. В-е-к.

Без необходимости, если вы создаете свой бренд как авторитетный источник путем предоставления подробного и информативного контента, то сможете многого достичь с помощью компактной, но тщательно разработанной коллекции веб-страниц.

Вот что я бы рекомендовал, если у вас есть команда или фрилансеры:

- Назначьте конкретных членов команды или фрилансеров для освещения основных тем. В сущности, у вас должны быть обученные писательские SMEs (Subject Matter Expert) по каждой основной теме, которую вы хотите охватить в рамках своей стратегии. Таким образом, контент может быть произведен более точно и быстрее.

- Распределите работу по персонажам. Если у вас есть несколько типов аудитории, как в случае с Kind Habitat, назначьте производство для вашей команды на основе различных персон/аудиторий, чтобы ваши создатели контента могли углубленно изучить потребности и способы общения каждой персоны.

- Используйте ИИ для расширения охвата тем при адаптации к типу личности. Инструмент вроде AirOps поможет вам разработать рабочие процессы на основе конкретных тем и определенных персон; таким образом вы создаете варианты основных работ, ориентированные на специфические потребности, болевые точки и проблемы каждого сектора промышленности, персоны и т.д.

- При обновлении устаревшего контента для борьбы с его деградацией, обновляйте по темам, а не только одну страницу, которая потеряла в качестве. Старайтесь поддерживать контроль над деградацией контента, обновляя подразделы/группы страниц целиком, когда это возможно. Назначьте одного продюсера или индивидуального участника для работы над кластером связанных страниц.

Расширяйте с помощью подтем, так как нестандартный контент добавляет глубины

После определения аудитории и ее проблем, связанных с основными темами вашего контента, важно расширить его, включив в себя субтемы, особенно те, которые менее распространены, но напрямую касаются профилей ваших идеальных клиентов. Эти темы могут не входить в традиционный список ключевых слов, однако можно связать определенные ключевые слова и намерения поиска с этими страницами для косвенного повышения их видимости в результатах органических поисковых запросов.

Однако, не всегда будет четкое число ‘поиска’ для такого типа контента.

Иногда этот контент будет запутанным. Иногда это будет странно.

Важно глубоко понимать основную целевую группу, определяя их насущные проблемы и вопросы, которые вы можете эффективно решать, включая менее распространенные или находящиеся на периферии.

Однако именно «нишевый контент» придает вашей платформе полезность, доверие и уникальность, что делает ее трудной для имитации другими.

Как эксперт по SEO, я бы хотел поделиться другой точкой зрения: вместо сосредоточения исключительно на оптимизации под топ-10 запросов по конкретной теме, рассмотрите возможность предсказания и ответа на следующие 100 вопросов. Такой превентивный подход может значительно улучшить вашу органическую видимость в поисковых системах и выделить вас среди конкурентов.

Они вникают в боковые двери, оговорки, подводные камни, исключения, причуды отраслевого языка и дебаты.

Чтобы усилить впечатление от вашего бренда, важно не только формировать группы (кластеры) по темам, но и создавать значимый контекст в рамках этих тем, которые совпадают с интересами вашей целевой аудитории.

Вот где искать информацию при расширении за счет содержательных подтем:

- Звонки по продажам с потенциальными клиентами, вопросы поддержки клиентов и настоящие интервью с клиентами: здесь настоящая золотая жила, и она есть у каждой марки (да-да, даже вашей). Используйте это в своих интересах. Я рекомендую такие инструменты, как Gong/Chorus + Humata AI.

- Контекст для разработки вашей темы окружения: Вы не просто создаёте аккуратный кластер с «лучшими X инструментами», «топ-инструментами для Y» и «X против Y». Задайте себе вопросы: какие заблуждения необходимо устранить? Какие продвинутые советы обсуждают только эксперты в своей области? Используйте внутренние экспертов по теме (SMEs), или инвестируйте в наем SMEs на почасовой основе, связываясь с ними через такие платформы как JustAnswer.

- Таблица содержания Википедии и примечания: Хотя это может сначала показаться странным руководством, если вы действительно считаете, что охватили основные темы для всех ваших ICPS со всех сторон и их общих болевых точек, этот подход поможет вам разветвиться на связанные подтемы. Предостережение: конечно, не вкладывайте усилия в покрытие подтем, которые не важны для ваших ICPS … или аспектов, которые они уже полностью понимают. (Это исследование очень трудоемкое. Если у вас есть предлагаемое решение проблемы, отправьте мне его.)

- Вопросы People Also Ask в поисковой выдаче (SERP): учитывайте их существование по причине актуальности. Используйте обычные инструменты SEO, такие как SEMrush и Ahrefs, для анализа этих вопросов в рамках вашей темы.

Оптимизировать ссылки по темам

Другими словами, при структурировании внутренних ссылок будет ли более выгодно классифицировать их по темам вместо того, чтобы сосредоточиваться только на структуре навигации или временных отрезках публикаций в блоге?

Гм, да — определенно. И если вы еще этого не делали, самое время начать сейчас.

Включение внутренних ссылок на конкретные темы может быть весьма эффективным, но часто игнорируемым методом укрепления релевантности и экспертности в этих областях.

Большинство контент-команд по умолчанию используют одну из двух стратегий внутренних ссылок.

- Навигация на основе ссылок: всё, что появляется в вашем меню или футере.

- Дата-зависимая привязка: связывание с «недавними публикациями», независимо от релевантности темы.

Проблема заключается в том, что эти методы отдают приоритет удобству системы управления контентом над потребностями читателя или поисковых систем.

Внутренняя стратегия линковки, основанная на первой теме:

- Связывает все релевантные страницы под одной темой или целью персонажа.

- Связи между подразделами объединяют ссылки, увеличивая глубину обхода и обнаруживая дополнительную ценность.

- Повышает значимость заброшенных или неэффективных активов с помощью контекстуально релевантных ссылок.

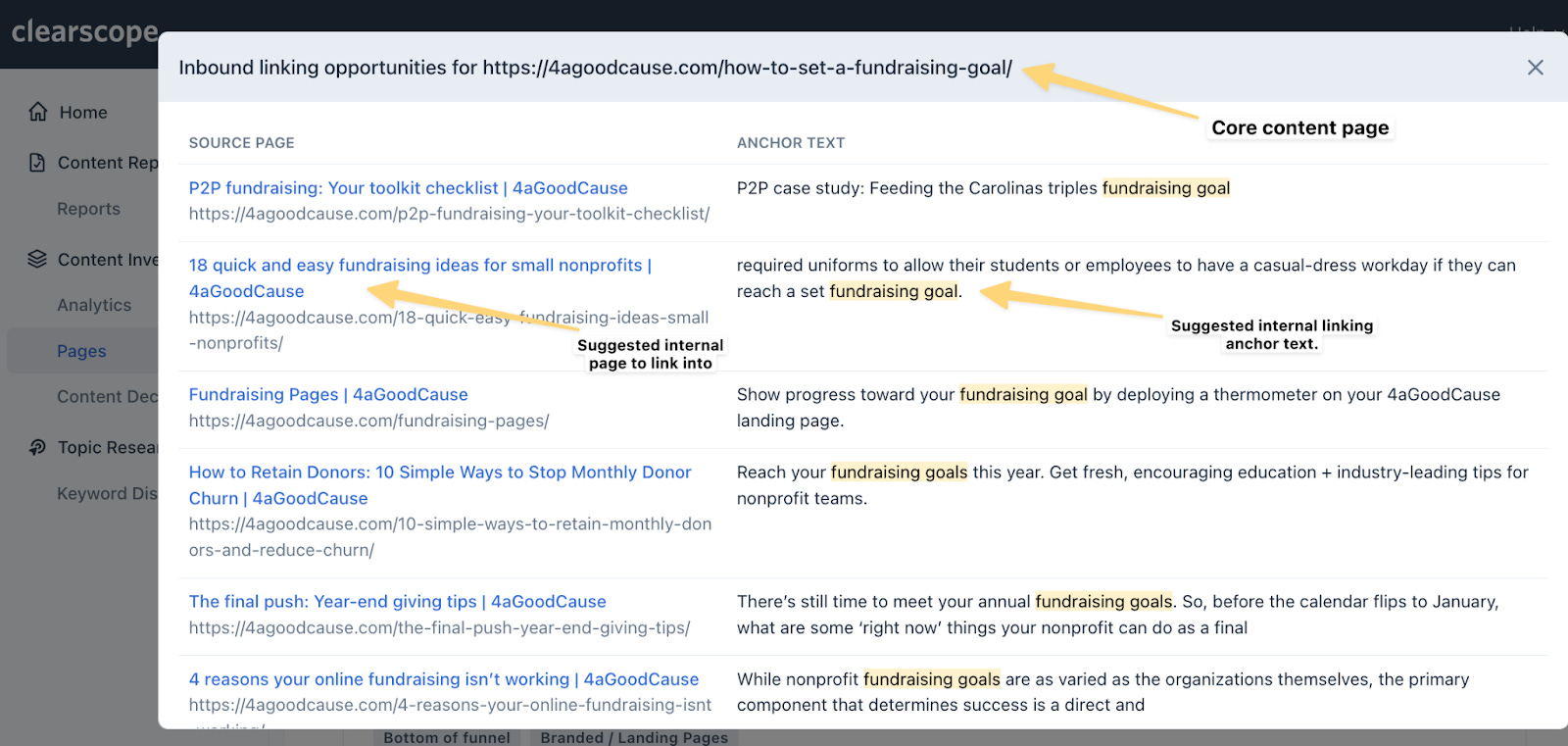

Проанализируйте эту работу с помощью инструмента поисковой оптимизации, такого как Clearscope, Surfer или Ahrefs. Ссылки на руководства по функциям каждого инструмента предоставляются для вашего удобства.

Эти инструменты помогают выявлять потенциальные внутренние ссылки на страницах, за которыми следит инструмент, и предлагают конкретные рекомендации относительно релевантного анкорного текста для точного размещения URL-адресов.

Вместо того чтобы полагаться только на создателей контента и SEO экспертов для определения соответствия предлагаемой страницы кластеру тем для создания ссылок, рассмотрите использование инструментов вроде Clearskopoe. Эти инструменты могут помочь организовать ваш контент в релевантные категории или кластеры, что облегчит вашей команде задачу обеспечения согласованности и точности при создании ссылок.

Но вам также стоит применять стратегию обратных ссылок на основе тем.

Вместо того чтобы просто стремиться получить обратные ссылки, более выгодно сконцентрироваться на приобретении ссылок от авторитетных источников в вашей нише или тех, которые релевантны для вашей целевой аудитории.

Чтобы проиллюстрировать это, такому сайту как Kind Habitat необязательно иметь множество некачественных ссылок со всего мира для того чтобы завоевать авторитет в области устойчивого дизайна интерьеров.

Этот бренд должен инвестировать в обратные ссылки, которые включают:

- Авторитетные сайты по схожей тематике, такие как ThisOldHouse.com, MarthaStewart.com, Houzz.com и HomeAdvisor.com.

- Местные и региональные издания в областях обслуживания этого бренда.

- Производители экологически чистых строительных материалов и продукции с низким уровнем токсинов.

- Профессиональные ассоциации дизайнеров интерьеров, строителей и управляющих недвижимостью, которые ценят устойчивое развитие и экологичность.

Используйте колесо влияния местного авторитета

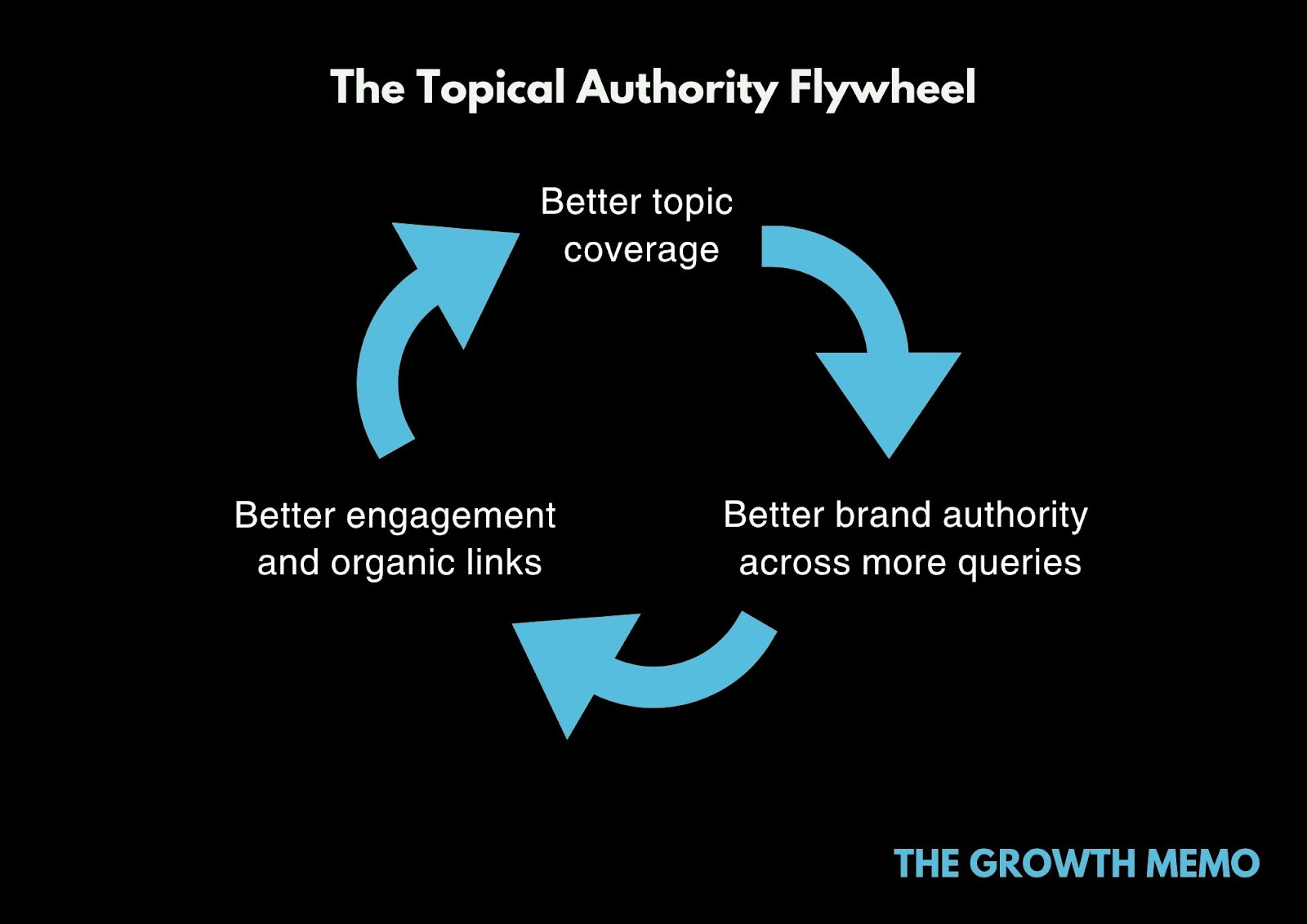

Приняв метод, фокусирующийся на ключевых темах сначала, вы обнаружите преимущества при более глубоком изучении этих тем для различных целевых групп и уровней пользовательских намерений. Такой подход поможет вам сформировать цикл тематической авторитетности — самоусиливающийся процесс, в ходе которого ваш опыт растет параллельно с увеличением видимости и доверия.

Вот как это работает:

Лучшее покрытие → Лучшая вовлеченность и органические ссылки → Лучшее видимость по большему числу запросов.

Путем тщательного освещения темы на вашем сайте вы не только увеличиваете ее полезность для зрителей, но и делаете ее более доступной для поисковых систем и моделей обучения языкам (LLM).

Вы создаете тип брендовой среды, которую поисковые системы, такие как Google, обычно выделяют благодаря своим продвинутым алгоритмам искусственного интеллекта, которые постоянно совершенствуются.

И да, это измеримо.

Отслеживайте свою эффективность по теме, а не только по странице или ключевому слову.

Эффективно организуя и структурируя ваш контент, вы можете собрать связанные веб-страницы вместе и отслеживать общую производительность темы.

- Посмотрите, как обновленные или расширенные тематические кластеры улучшаются в среднем рейтинге, кликабельности и конверсиях со временем.

- Ищи ранние признаки роста в течение первых 10-30 дней после обновления или публикации полного набора материалов по определенной теме.

- Следите за скоростью соединения. Мощные тематические кластеры приносят плоды.

Реализовать подход, основанный на темах, это не только о трафике.

Достижение устойчивого положения в поисковых и языковых моделях требует сосредоточения усилий на узкой области, а не расширения деятельности широко. Многие бренды сегодня испытывают недостаток в этом.

Смотрите также

- Акции IRKT. Яковлев: прогноз акций.

- LinkedIn запускает бесплатные сертификационные курсы по искусственному интеллекту

- Анализ динамики цен на криптовалюту HBAR: прогнозы HBAR

- Поисковая выдача и обзоры, организованные с помощью искусственного интеллекта: как добиться заметности в новом ландшафте SEO

- Могут ли стартапы AEO / GEO превзойти устоявшиеся компании по производству инструментов SEO?

- Акции DSKY. Детский Мир: прогноз акций.

- Депозитция: Google использовал сигналы поиска и данные для обучения моделей искусственного интеллекта Gemini AI

- Google Ads Mixed Campaign Type Experiments Live For Some

- Акции LSNG. Ленэнерго: прогноз акций.

- Безумие мемкоинов! Кто король быков?

2025-07-22 16:41