В последнее время, характеризующееся появлением сводок от искусственного интеллекта и постоянными изменениями в Google, редакторы новостей столкнулись с трудным периодом. Хорошей новостью стало то, что теперь Google Discover доступен на настольных компьютерах.

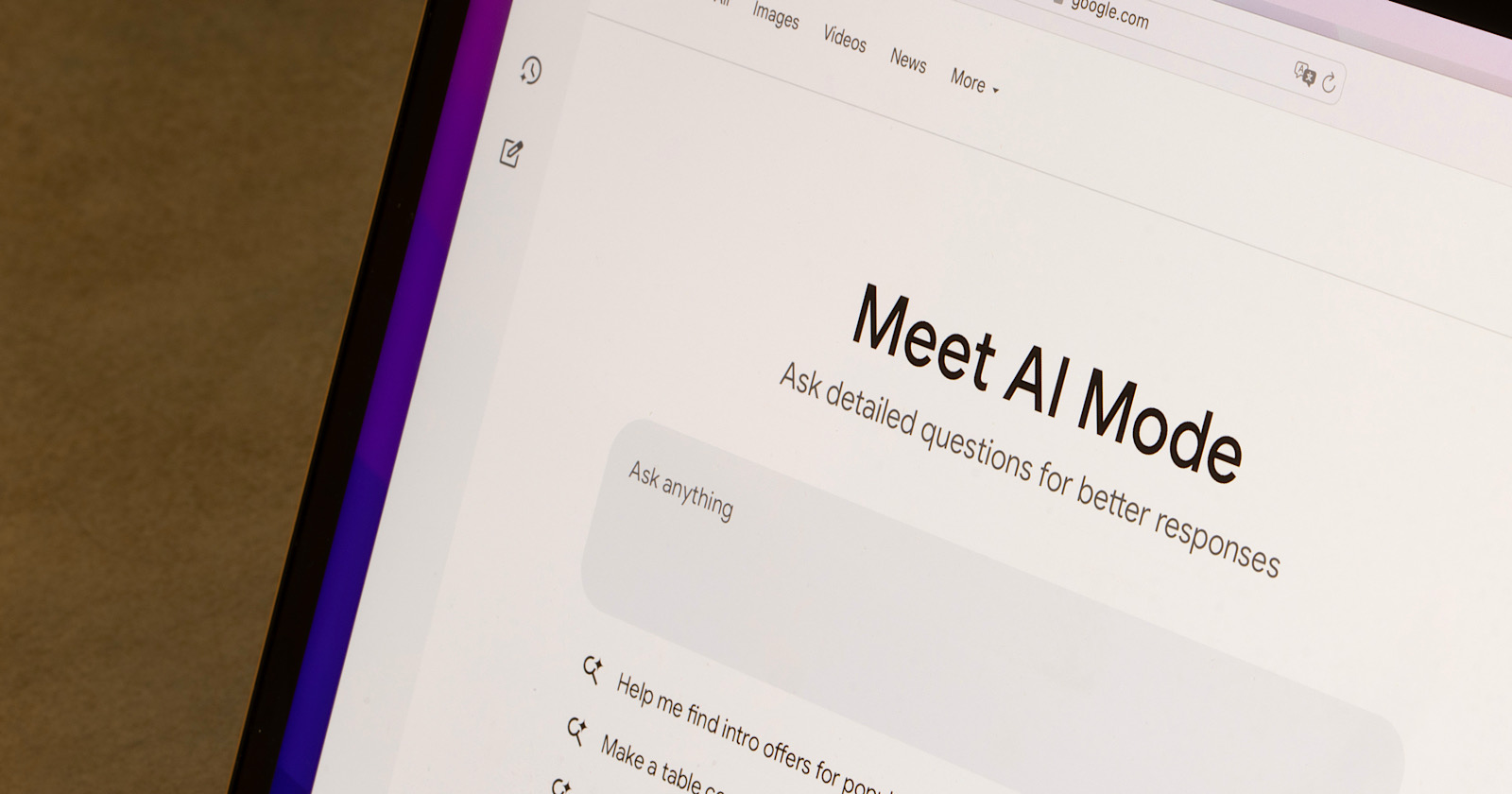

С другой стороны, недавнее введение режима AI может привести к тому, что пользователи перестанут пользоваться стандартной строкой поиска, что потенциально снизит эффективность функции ‘Discover’ как решения.

Как опытный вебмастер, недавно я имел честь провести плодотворную беседу с Джоном Шехатой, признанным экспертом в области Google Discover, роста цифровой аудитории и поисковой оптимизации для издателей новостей. Этот диалог предоставил мне ценные сведения о современном состоянии SEO-ландшафта для новых участников издательского дела.

Шехата является создателем NewzDash и имеет более чем двадцатилетний опыт работы в этой области. Этот багаж знаний поддерживается различными руководящими должностями в таких уважаемых изданиях как Vogue, The New Yorker и GQ под эгидой Condé Nast.

В ходе нашей дискуссии мы подробно изучаем возможные последствия доступности Google Discover на настольных компьютерах, что может привести к возвращению некоторого ранее утраченного веб-трафика, а также появление Искусственного Интеллекта (ИИ) в пользовательских интерфейсах поиска.

Как эксперт по SEO, я часто обсуждаю роль ИИ в управлении страницами результатов поисковых систем (SERP). Вот мои рекомендации для брендов и создателей контента, как эффективно ориентироваться в этом меняющемся ландшафте: 1. Приоритезировать качественный контент: Алгоритмы AI разработаны так, чтобы отдавать предпочтение высоко-качественному, релевантному и увлекательному контенту. Убедитесь, что ваш контент ценен, оригинален и хорошо структурирован для оптимальной видимости. 2. Оптимизировать пользовательский опыт: ИИ предпочитает сайты с плавным UX. Сосредоточьтесь на мобильной адаптивности, быстром времени загрузки, интуитивной навигации и удобной читаемости. 3. Использовать семантический поиск: AI лучше понимает контекст поисковых запросов, чем когда-либо прежде. Используйте релевантные ключевые слова, синонимы и связанные термины, чтобы помочь вашему контенту появляться в большем количестве запросов. 4. Создавать сильное онлайн присутствие: Установление авторитета в нише может повысить вашу видимость. Это включает создание высококачественных бэклинков, взаимодействие с аудиторией в социальных сетях и поддержание постоянного присутствия в интернете. 5. Быть в курсе последних трендов: Следите за последними тенденциями и обновлениями в AI и SEO, чтобы оставаться впереди конкурентов. Цифровой ландшафт постоянно меняется, поэтому важно адаптироваться и внедрять инновации соответственно.

Вы можете посмотреть полное видео здесь и найти полную расшифровку ниже:

https://www.youtube.com/watch?v=Leh4r23sj6w

ИМХО: Google Discover, искусственный интеллект и их значение для издателей (транскрипт)

Шелли Уолш: Джон, могли бы вы поделиться своими мыслями о предполагаемом влиянии AI на трафик новостных изданий?

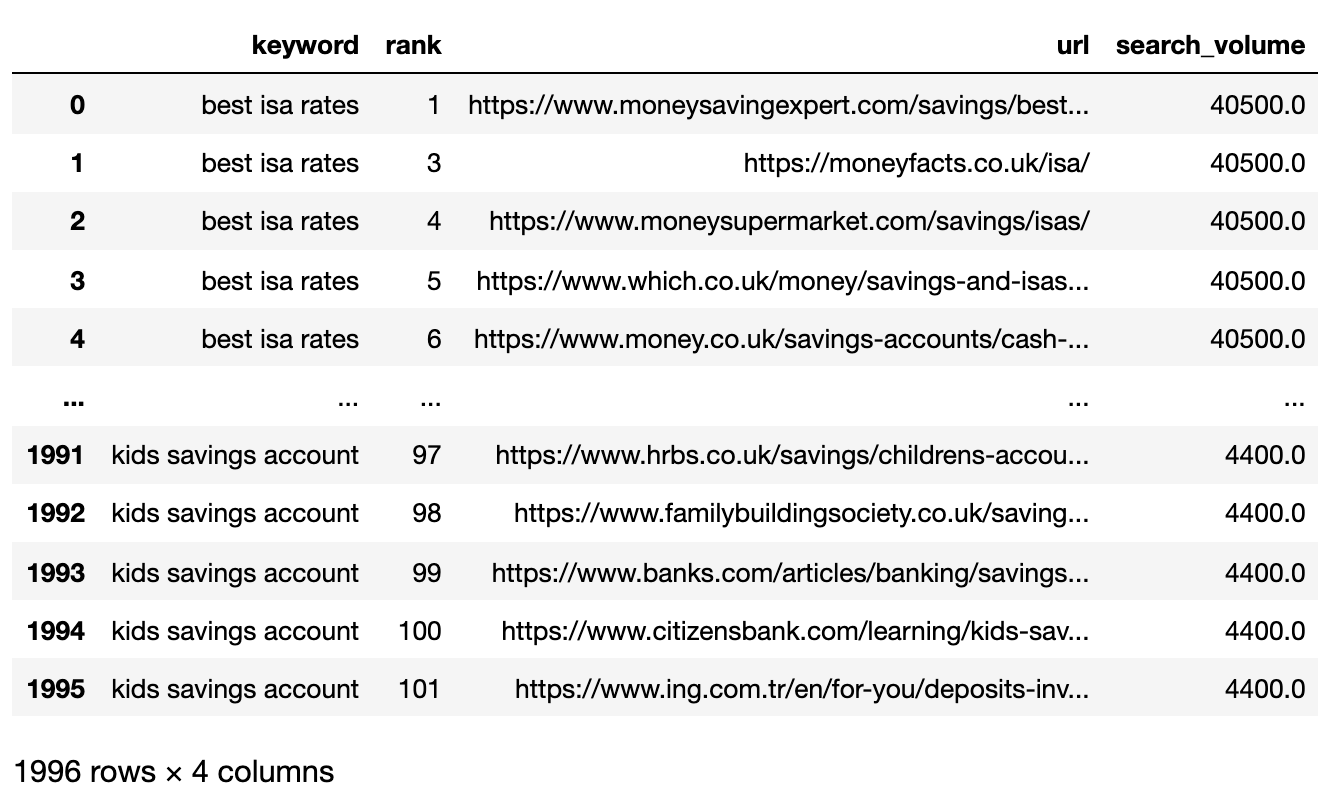

Джон: В среднем многочисленные исследования показывают, что веб-сайты могут испытывать потерю трафика в диапазоне от 25% до 32%, преимущественно из-за внедрения новейших систем ИИ для создания кратких выдержек.

На данный момент нет конкретных исследований, проведённых для новостных издателей, поэтому мы сейчас работаем над этим.

Примерно год назад мы провели анализ и обнаружили, что около 4% всех запросов новостей вызывали краткое резюме от ИИ. С тех пор прошел год.

В NewsDash мы представляем инновационный элемент: отслеживание в реальном времени обзорных данных по ИИ для каждого новостного запроса по мере их роста популярности. Примечательно, что данная функция пока показала наибольшее влияние на сектора здравоохранения и бизнеса.

Примерно четверть всех запросов новостей касалась здоровья, в то время как бизнес, хоть точную цифру я и не помню, составил около 8%. Что касается главных трендов новостей, это было почти несущественно.

Примерно через два месяца мы соберем надежные данные, однако из моих исследований год назад видно, что интеграция для новостных запросов ограничена за исключением некоторых специализированных областей.

В настоящее время исследования показывают, что они испытывают снижение трафика от 25% до 32%.

Может ли Google Discover восполнить потерю?

Шелли: Судя по моим личным наблюдениям, издатели столкнулись со значительными трудностями не только из-за ИИО (AIO), но и благодаря многочисленным полезным обновлениям Google за последние полтора года. В ходе исследования для нашего разговора я наткнулся на статистические данные, которые показывают…

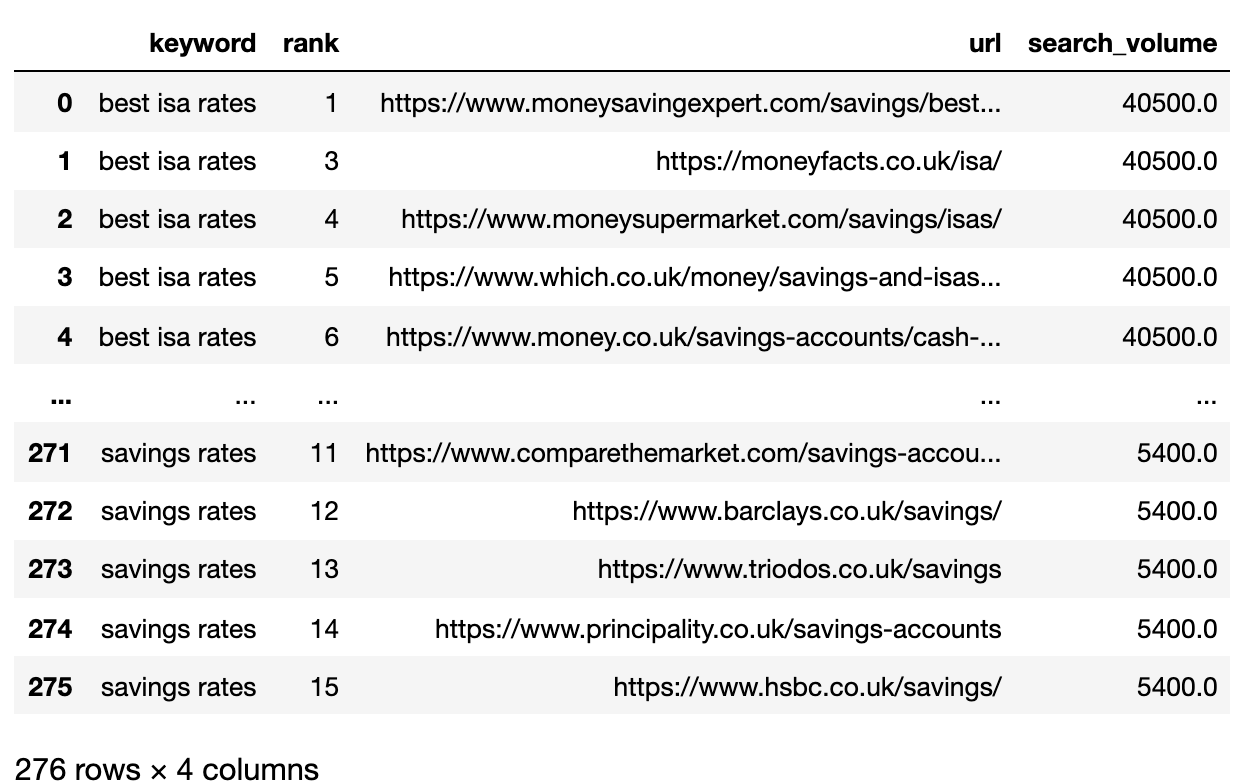

Учитывая существующее распределение трафика с 90% от мобильных устройств и 10% от настольных компьютеров, это обновление может привести к росту Discover-трафика для издателей примерно на 10-15%.

Вы считаете, что Discover может потенциально компенсировать потери трафика, которые испытывает AIO? Будет ли сосредоточение усилий исключительно на Discover жизнеспособной долгосрочной стратегией для издателей в текущих рыночных условиях?

Джон: Действительно, этот вопрос весьма интересен. Я размышлял над идеей, своего рода подозрением, что Google может направлять больше веб-трафика через Discover к создателям контента, одновременно снижая трафик из результатов поиска.

Эй, вместо того чтобы зацикливаться на этом, давайте сосредоточим внимание на поиске чего-то нового. Говоря проще, давайте исследовать, раскрывать и открывать вместе. И я могу ошибаться полностью.

Google Discover представляет проблему, поскольку он может быть весьма непредсказуемым, но трудно устоять перед его влиянием. В результате издатели часто обнаруживают, что более половины их веб-трафика приходится на Google Discover.

Мне кажется, что издатели могут постепенно забывать о важности поиска и уделять больше внимания функции Discover. На мой взгляд, это может быть рискованной стратегией.

По моему мнению, Google Дискавер работает скорее как средство распространения контента, нежели как стратегический подход. Поэтому крайне важно уделять первостепенное внимание качеству вашего материала независимо от того, делитесь ли вы им через социальные сети, Google Дискавер, поисковые результаты или другие каналы.

Мне кажется, что функция «Discover» работает как продолжение функции поиска. Соответственно, если ваш рейтинг в поисковой выдаче уменьшается, то и трафик от этой функции также со временем снижается — тенденция, которую я наблюдал ранее.

В некоторых случаях мы сотрудничаем с клиентами, предпочитающими более социально ориентированную или исследовательскую стратегию. Это означает, что они часто используют привлекательные заголовки, краткие описания и стремительный темп публикаций – постоянно выпуская новый контент один за другим.

За шесть месяцев я заметил значительное снижение поискового трафика на моем сайте. Этот спад затронул не только обычные результаты поиска, но и раздел Discovery, к сожалению, теперь мой контент отсутствует также в разделе Новости.

Google достиг той стадии, когда начал оценивать, что данный издатель больше не попадает в категорию новостных издателей.

Итак, это предупреждение.

Как опытный вебмастер, я усвоил, что хотя использование Google Discover для трафика может быть полезным, оно не должно являться основой вашей онлайн-стратегии. Максимально используйте каждую посетителя от Google Discover, но всегда помните о возможности непредсказуемого исчезновения трафика без явной причины. Очень важно разнообразить стратегии и сосредоточиться на долгосрочном росте для устойчивого успеха в цифровом мире.

Как эксперт по SEO, я получаю множество вопросов из Бразилии и других стран относительно значительных потерь трафика на их крупных веб-сайтах в апреле месяце. Несмотря на отсутствие изменений в технических или редакционных аспектах этих сайтов, они столкнулись с резким снижением числа посетителей.

Говоря проще, то о чём идёт речь — это не долгосрочный план или стратегия, а скорее краткосрочное действие или метод, которым стоит воспользоваться в полной мере. Однако для более стратегического подхода рекомендую рассмотреть диверсификацию как общий план.

Прямо сейчас Google составляет примерно 80% трафика издателей, включая поисковые запросы, Discovery и прочее.

Действительно, я твердо убежден, что новостные рассылки играют важную роль независимо от того, насколько они популярны или влияют на большинство партнерств.

Издателям было бы благоразумно тщательно обдумать пути расширения разнообразия их контента, привлечения большего числа посетителей и разработки множества источников дохода.

Режим Возрастания Искусственного Интеллекта

Шелли: Переходя к другой теме, я бы хотела обсудить с вами режим ИИ. Меня заинтересовало кое-что интригующее из того, что вы упомянули об этом в LinkedIn.

Говоря проще, вы упомянули, что режим искусственного интеллекта (AI) может быть установлен как стандартная точка зрения в будущем. Это могло бы привести к увеличению количества просмотров, но уменьшению кликов от пользователей.

В свете текущих трендов, какое развитие страниц результатов поисковой системы (SERP) вы ожидаете увидеть в следующем году с учетом важности сосредоточения внимания на этих результатах для издателей?

Джон: Когда речь заходит о развитии страниц результатов поиска (SERPs), сначала мы столкнулись с простыми синими ссылками. Однако Google осознала недостаточную эффективность этого подхода и ввела так называемый универсальный поиск. С этим обновлением стали доступны различные элементы, что обеспечило более полное поисковое взаимодействие.

Более того, это не остановилось на достигнутом; начали интегрироваться избранные фрагменты и прямые ответы. В конечном итоге всё зависит от пользовательского опыта.

За последний год был значительный рост использования технологий Языковых моделей (LMM), таких как ChatGPT, а также терминов вроде Perplexity. Это быстрое развитие привело к тому, что Google все чаще внедряет искусственный интеллект в свои сервисы.

Всё началось с SGE и развилось до AI Overview, а совсем недавно был запущен режим AI.

Как профессионал в области цифрового маркетинга, я не могу не согласиться с Сундаром из Google о будущем поиска. Искусственный интеллект (ИИ) действительно является нашим будущим и представляет собой не просто тренд, а трансформацию, которая пронижет каждый продукт и поисковый опыт, который мы знаем сегодня. Эта революция на основе ИИ установится доминировать над ландшафтом, определяя способы нашего взаимодействия с информацией и услугами в интернете.

1. Сколько людей может перейти на использование режима ИИ?

2. Соответствует ли их ожиданиям текущий формат краткого обзора ответа?

А если они захотят углубиться в тему, то могут обратиться к ссылкам или сайтам с источниками и так далее.

Неясно когда искусственный интеллект может взять верх над традиционным поиском. Однако стоит учесть следующее: посещение интерфейса Perplexity и просмотр результатов поиска кажутся словно взаимодействием между искусственным интеллектом и традиционными результатами.

Проще говоря, вероятно, взаимодействие с инструментами вроде ChatGPT станет стандартом в будущем при работе с поисковыми системами и генеративными технологиями, независимо от того, произойдет это скоро или немного позже.

Основываясь на наших наблюдениях, трудно точно предсказать когда это произойдет, но я полагаю, что это не будет слишком далеко от нас в будущем, особенно учитывая, что поколение Z предпочитает общение длительному поиску. Это значит, изменения могут произойти скорее раньше, чем позже.

Похоже, что мы станем свидетелями этого развития в ближайшее время. Я не могу точно сказать когда, но предполагаю, что сейчас они оценивают взаимодействие пользователей с режимом AI и сводками от ИИ для принятия решений по последующим действиям.

Видимость, а не трафик — новая метрика.

Кроме того, похоже, что ИИ может выступать в качестве хранителя страниц результатов поисковых систем (SERP).

Учитывая, что ассистенты по юридическим вопросам типа LLMA и режим ИИ не исчезают, какие стратегии вы применяете при работе с вашими клиентами для адаптации к изменяющемуся ландшафту?

Джон: Вчера состоялась продолжительная дискуссия с одним из наших клиентов по различным темам.

Проще говоря, я предложил начать с мониторинга, затем провести анализ и после этого принимать меры. Такая последовательность является критически важной, поскольку преждевременное действие без достаточной информации о влиянии ИИ на их платформу, сайты и общий трафик может привести к нежелательным результатам. Один лишь трафик не является единственным значимым показателем для учета.

На протяжении поколений это звучало как вопрос о трафике, но так быть не должно.

Поскольку новый мир характеризуется снижением уровня веб-трафика, это представляет собой проблему для издателей, которые в основном полагаются на трафик как основной источник дохода.

Вы можете измерить свои транзакции или конверсии независимо от того, получаете ли вы трафик или нет.

ЧатГПТ проводит интеграцию с Шопифэй.

Обзор искусственного интеллекта от Google предоставляет прямые ссылки на покупки, позволяя вам приобретать товары непосредственно через Google или другие веб-сайты. Это исключает необходимость прохождения нескольких этапов, например, сначала посещения сайта, а затем совершения покупки.

Я думаю, вам нужно отслеживать и анализировать, где вы теряете свой трафик.

Должны ли издатели уделять приоритетное внимание этим конкретным областям (вертикалям) для своего контента или нет? Важно следить за видимостью вашего контента в этих областях.

Все чаще люди ищут последние новости. Вчера я написал в LinkedIn о том, что если кто-то ищет «Met Gala 2025», то Гугл покажет самые релевантные заголовки и все актуальные новостные статьи по этой теме.

Как SEO-эксперт, я бы переформулировал это так: ‘Если вы настроите свой поиск на вопросы вроде «Что произошло на Met Gala?», «Что случилось между Трампом и Зеленским?» или «Каковы подробности того конкретного события или момента?», то обнаружите более релевантные результаты.’

Гугл определил, что вы предпочитаете сжатую и обобщенную версию текста вместо чтения множества источников для понимания основных моментов.

События вчерашнего дня были кратко изложены с акцентом на основную тему. Представлены ключевые моменты, которые служат дорожной картой для дальнейшего изучения.

С увеличением числа пользователей предпочитающих краткие резюме вместо повторных заходов на веб-сайты ожидается снижение количества генерируемых просмотров.

Все более вероятно, что схемы будут играть значительную роль в том, как ChatGPT находит контент. Я полагаю, мы увидим рост числа издателей, устанавливающих прямые связи или соглашения с различными моделями обучения языкам (LLM).

Важно учитывать ситуацию, когда чат-боты вроде ChatGPT и другие модели языкового обучения (LLMs) должны компенсировать издателям за информацию, которую они используют. Это может быть в виде оплаты контента, используемого при их обучении, или конкретных данных, таких как поисковые запросы, к которым они имеют доступ.

Похоже, важно рассмотреть возможность появления нового источника дохода, возможно связанного с обменом или транзакцией, как дополнительного финансового ресурса для издателей.

Приоритет анализа перед новостями о товарах

Действительно, разве это не значительная проблема перед нами стоит? Традиционные издательства новостей усердно стараются обеспечить высококлассные свежие новости, в то время как крупные языковые модели (LLM) кажутся извлекающими выгоду из этих усилий.

Если они планируют выпускать только обобщения (summaries), похоже, мы можем вернуться к начальным стадиям развития Google, где все критиковали компанию за похожие действия.

Может ли быть полезно для издателей новостей адаптировать свой подход и тип создаваемого контента? И реально ли такое изменение с учетом текущих обстоятельств?

Джону кажется существенным для них сосредоточиться на контенте, который является полезным и просветительским для пользователей, хотя не все издатели попадают в эту категорию, так как некоторые просто сообщают новости, например, ‘Такой-то сделал то-то там.’

Подобный тип новостей можно найти на множестве веб-сайтов, что означает: если вы перестанете создавать такой контент, поисковые системы вроде Google и различные языковые модели (LLM) найдут аналогичный материал примерно в ста различных формах. Это не тот вид качественного контента, к которому мы стремимся.

В отличие от этого, другой материал предоставляет детальный анализ сценариев или событий, предлагая такие идеи, как «Вот обзор поведения рынка вчера. Вот некоторые действия, которые вы могли бы рассмотреть.»

Вместо того чтобы сосредотачиваться исключительно на репортажах новостей, я считаю, что создание уникального и ценного контента будет выделяться больше. Хотя освещение событий остаётся важным, изобилие оригинальных и скопированных статей может перенасытить рынок, делая отличительный контент более заметным.

Если Google и подобные модели обучения языкам указывают на необходимость высококачественного контента, важно понимать, что создание и распространение такого контента не являются дешёвыми. Это включает в себя производство контента, его освещение в СМИ и сопутствующие мероприятия.

Похоже, разумным подходом может быть создание системы, при которой данные платформы компенсируют издателей не только за изначально предоставленный контент, но и за контент, потреблённый пользователями и используемый в моделях обучения платформ.

Первоначально Google предлагал сделку: они будут показывать один-два фрагмента вашей статьи, а взамен отправят трафик на ваш сайт для возможной монетизации. Однако сейчас эта договоренность больше не работает так, как раньше.

В своей работе в качестве специалиста по цифровому маркетингу я часто сталкивался с мнением: «Не завышай ожидания от Google». Однако за последние два десятилетия, кажется, существовало неявное соглашение между всеми нами — своего рода контракт, если можно так выразиться — о том, как мы будем взаимодействовать с Google. Это контекст, из которого я формирую стратегии SEO и тактики цифрового маркетинга.

Так что да, именно туда мы должны идти.

Этическая дискуссия вокруг LLM и контента издательств

Джон (Эксперт по SEO): Передвижение в такой ситуации может оказаться трудным делом, но я полностью согласен с важностью первоклассного контента с точки зрения SEO.

В SEJ мы больше концентрируемся на создании высококачественных авторских материалов по лидерству и инновациям вместо того, чтобы просто публиковать статьи, основанные на текущих событиях. Мы вкладываем значительные ресурсы в разработку этих экспертных колонок.

Однако концепция LLM кажется повторяющейся; по сути они основываются на труде других без добавления значительных новых идей. Эта тема вероятно вызовет дебаты в следующем году, делая интересным наблюдение за ее развитием. Тем не менее, это более широкая тема, требующая отдельного рассмотрения позднее.

Как SEO эксперт, один аспект моей работы, который меня восхищает, — это исследование сферы отслеживания LLM (links leading machines), то есть ссылок, ведущих к машинам. В цифровом пространстве, по которому я путешествую, я всегда в поисках новых упоминаний, цитирований и даже реферальных переходов, созданных системами ИИ. Этот процесс не только помогает мне оптимизировать стратегии SEO, но также предоставляет ценные сведения о растущем влиянии искусственного интеллекта на наш онлайн-мир.

Джон: Один из аспектов моей работы включает регулярные встречи с издателями — обычно от 10 до 15 раз в неделю.

Взаимодействуя с издателями и будучи информированным о текущих событиях в их редакциях — понимая их проблемы, области для улучшения и т.д., мы усиливаем свои возможности, эффективно формируя наш стратегический план или направление.

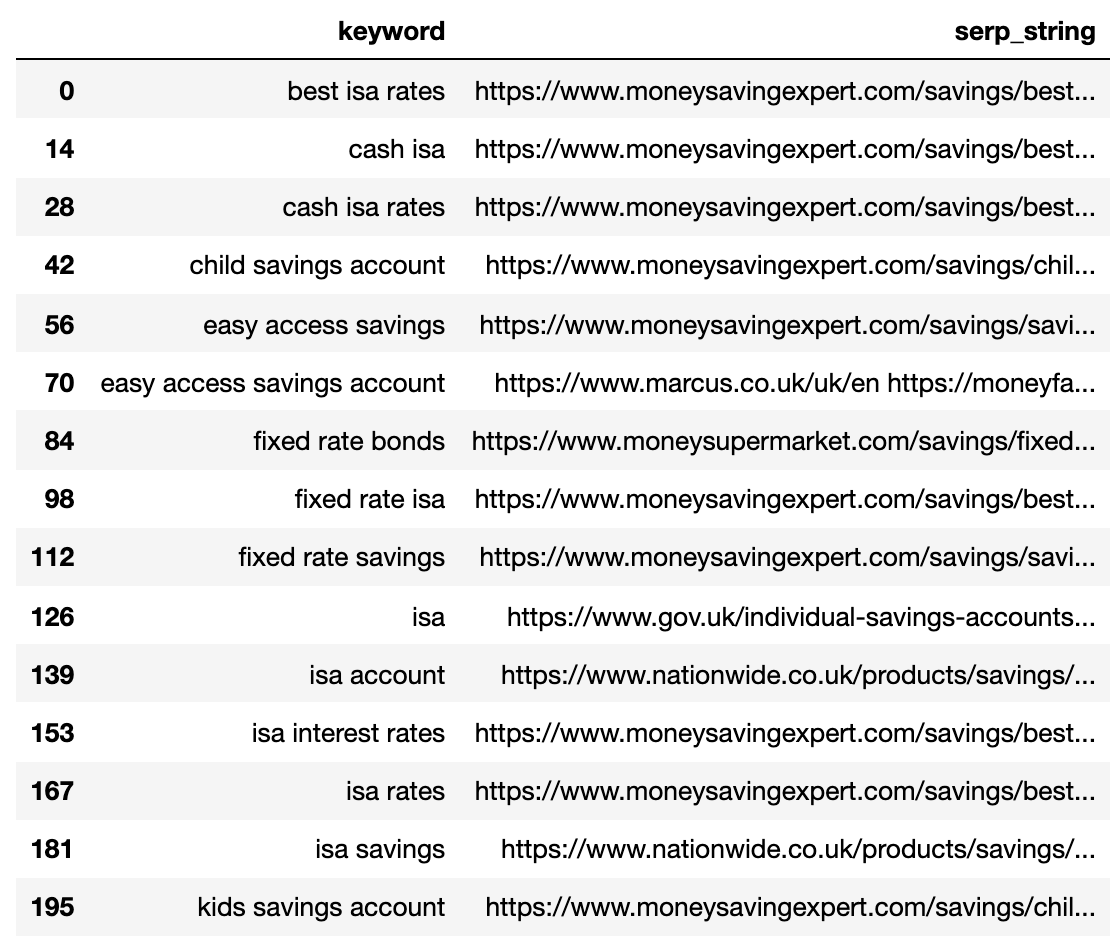

Мы следили за обзором ИИ для NewzDash и рады объявить о выпуске этой новой функции в течение следующих двух месяцев!

Проще говоря, подумайте обо всех ключевых словах или терминах, которые вы отслеживаете, включая названия ваших статей и их идеальные поисковые запросы. Затем мы сообщим вам: ‘Для этого ключевого слова доступен AI-обзор’, а также дадим оценку его видимости и потенциальному снижению позиций в рейтинге.

Для тем или категорий, которые вы часто освещаете, например новостей об iPhone, стоит учесть, что рынок уже перенасыщен обзорами искусственного интеллекта (AI). Это значит, что при публикации материала о предстоящем запуске нового iPhone, такого как iPhone 16, хотя ваш контент может быть релевантен и ценен, он скорее всего будет затмеваться обилием статей с обзорами AI. В результате это может снизить вашу видимость.

После этого мы стремимся расширить наш охват и включить другие Большие Языковые Модели (LLM). В частности, планируем отслеживать упоминания, запросы, цитаты и ссылки в рамках ChatGPT, ведущего LLM-влиятеля, а также Перплексити и других крупных моделей.

Как эксперт по поисковой оптимизации (SEO), я твердо уверен в необходимости глубокого понимания текущего ландшафта и трендов, после чего разрабатываю индивидуальную стратегию, соответствующую моей конкретной нише или области контента.

Шелли: В настоящее время одной из главных препятствий, с которыми сталкиваются издатели при работе с SEO, является необходимость оставаться хорошо информированными и определять источник рефералов, генерируемых ИИ-трафиком и подобными источниками. Эта тема также вызывает мой интерес.

Джон, мне было приятно общаться с вами сегодня, и я очень ценю ваши мнения. Жду встречи лично на одном из ваших собраний в ближайшее время.

Джон: Огромное спасибо! Было очень приятно, благодарю за приглашение.

Спасибо Джону Шехата за то, что он был гостем в шоу IMHO.

Примечание: это было снято до Google I/O и объявления о запуске режима ИИ в США.

Смотрите также

- Анализ динамики цен на криптовалюту PI: прогнозы PI

- Анализ динамики цен на криптовалюту ETH: прогнозы эфириума

- Акции X5. Корпоративный Центр Икс 5: прогноз акций.

- Акции VKCO. ВК: прогноз акций.

- Платный медиамаркетинг в 2025 году: 7 изменений, которые должны внести маркетологи

- Акции PIKK. ПИК: прогноз акций.

- SEO-специалисты рекомендуют структурированные данные для поиска с помощью ИИ… Почему?

- Акции RBCM. РБК: прогноз акций.

- Акции LENT. Лента: прогноз акций.

- Акции RNFT. РуссНефть: прогноз акций.

2025-05-29 15:11