Сегодняшний коммюнике представляет собой обновлённую версию моих ранних ресурсов по созданию экспертизы в предметной области, включая инсайты от утечек Google, раскрытых судебных документов, моего последнего анализа опыта пользователя для операторов искусственного интеллекта и последних трансформаций внутри поисковой среды.

Как профессионал в области цифрового маркетинга, я считаю, что часто недооценивается важность семантического поиска в мире искусственного интеллекта и поисковых систем, несмотря на то, что он может не привлекать особого внимания. Однако его влияние на пользовательский опыт и SEO неоспоримо.

Я расскажу:

- Суть тематической авторитетности и почему стоит обращать на неё внимание.

- Как измерить авторитетность тематики.

- Что говорят внутренние документы и утечки компании Google об авторитете по теме.

- Как Google и LLM могут понимать тематический авторитет.

- Какие конкретные рычаги вам следует использовать для построения авторитетности в определенной теме.

Я бы сказал, что наряду с авторитетом бренда актуальность темы имеет сейчас большее значение, чем когда-либо.

https://www.searchenginejournal.com/wp-json/sscats/v2/tk/Middle_Post_Text

Но прежде чем углубиться в тему, необходимо рассмотреть реальную ситуацию с нашим текущим поиском:

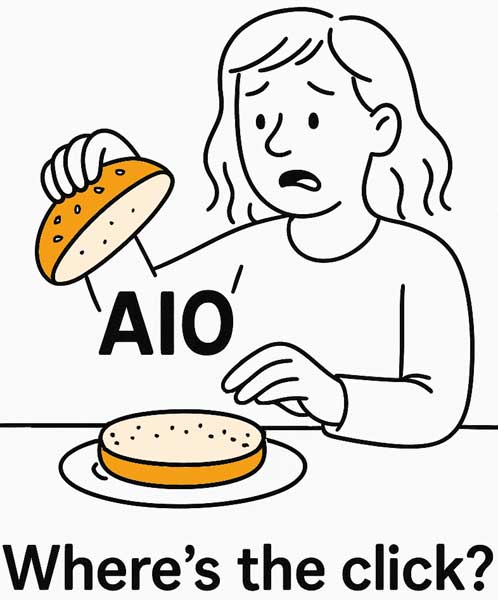

Похоже, вы и ваша команда посвятили значительное количество времени традиционным стратегиям SEO, таким как оптимизация контента, создание контентных кластеров и наращивание ссылок. Однако, несмотря на эти усилия, число органических кликов на вашем сайте могло перестать расти или даже сократиться из-за того, что Искусственная Оптимизация (AIO) занимает больше места в страницах результатов поисковых систем.

Вау, кажется, что многие сайты столкнулись с уменьшением органического трафика начиная с конца 2023 года, возможно из-за недостаточной экспертизы или релевантности в своих конкретных темах.

Между тем, заинтересованные стороны жаждут уверенности в том, что ваш план действий на эпоху ИИ работает.

Локальное авторитетность — критически важная концепция как для старой, так и для новой эры поисковой оптимизации.

Действительно, недавнее исследование компании Graphite показало интересный результат: веб-страницы с глубоким знанием предметной области привлекают трафик примерно на 57% быстрее, чем те, что имеют меньшую авторитетность. Это подчеркивает важность тщательной проработки и полноты информации, так как это может привести к существенным преимуществам в виде быстрого роста видимости. Более того, исследование показало, что усиление тематического авторитета потенциально может увеличить количество страниц, достигающих видимости в течение первых трех недель.

1 Ссылка на исходное заявление или источник.

Я разрабатываю систему для наших премиальных членов, которая упрощает отслеживание прогресса по конкретным темам. Данная система будет запущена в июне. Если вы хотите оставаться в курсе новостей, подумайте о переходе на нашу услугу премиум-подписки.

В чем заключается концепция топикальной авторитетности?

Ранее я часто относился к понятию авторитетности в тематике как к размытой концепции, которая зачастую связана с SEO и кажется скорее фразой для объяснения важности построения ссылочного профиля или глубины контента.

Но в 2022 году я ошибался: Это далеко не призрак.

Действительно, информация из внутренних документов и наблюдаемых признаков указывает на то, что степень, с которой веб-сайт всесторонне охватывает связанные темы и запросы, значительно влияет на его позиции в поисковой выдаче.

В эпоху, где доминируют Операторы Искусственного Интеллекта (AIOs) и Модели Языков для Правовых Целей (LLMs), сильная идентичность бренда (схожая по значению с экспертными знаниями в определенной области, известную как тематический авторитет) может решить, будет ли ваш контент востребован или затеряется среди AI-генерируемых кратких изложений.

Как сообщество SEO определяет тематический авторитет после AIO?

Принцип тематической авторитетности предполагает, что когда веб-сайты подробно обсуждают различные аспекты конкретной темы, поисковые системы вроде Google рассматривают их как экспертов или авторитетов в этой области знаний, что может способствовать более высокому ранжированию этих сайтов.

На другом конце спектра находятся сайты, которые лишь поверхностно касаются темы.

Вот как сообщество SEO определяло топовую авторитетность со временем:

Глубокое понимание темы также можно описать как ‘обширные знания’. Оно достигается за счет регулярного создания уникального, высшего качества и подробного контента, который всесторонне охватывает предмет обсуждения.

Как профессионал в области диджитал-маркетинга, я понимаю, что создание авторитета по теме критически важно для нашего присутствия в интернете. В отличие от фокусировки на конкретном термине или концепции, обладание авторитетностью по теме означает признание экспертом в широком диапазоне идей или нишах нашей области. Такой целостный подход не только увеличивает нашу надежность, но и расширяет наш охват аудитории и взаимодействие с ней.

B методе Google оценки ‘качества’ для ранжирования поисковых результатов учитывается экспертиза по темам наряду с качеством страницы и домена.

Вот упрощенное объяснение того, как актуальная релевантность отображается в страницах результатов поисковой системы (SERP):

1. Страницы с контентом, наиболее близким к запросу пользователя, ранжируются выше. Это означает, что чем точнее и релевантнее информация на странице соответствует поисковому запросу, тем больше вероятность ее появления вверху списка результатов.

2. Веб-сайты, имеющие сильное общее внимание к теме поиска, также приоритизируются. Например, если пользователь ищет ‘обучение собак’, страницы с сайтов, специализирующихся на дрессировке собак или уходе за питомцами, скорее всего, будут ранжироваться выше общих интересных ресурсов.

3. Авторитет веб-сайта, определяемый такими факторами, как его возраст, репутация и количество качественных ссылок, также может влиять на его положение в результатах поиска. Устоявшиеся и надежные сайты имеют больше шансов занять верхние позиции, чем новые или менее авторитетные.

4. Структура и организация контента на странице могут оказать влияние на ее рейтинг. Поисковые системы отдают предпочтение страницам с удобной навигацией, четкими заголовками и хорошим пользовательским опытом.

5. Наконец, свежесть и актуальность информации на странице также являются факторами при определении ее позиции в результатах поиска. Новые материалы обычно имеют больший вес по сравнению со старыми материалами, когда речь идет о релевантности для конкретного запроса.

- Глубина знаний: Регулярная публикация оригинального, высококачественного контента, охватывающего все аспекты темы.

- Покрытие сущностей: Сравнение объема вашего контента с собственным пониманием Google взаимосвязей между объектами — то есть, насколько хорошо вы охватываете концепции, которые Google ожидает по данной теме.

- Финальные ответы: Как часто ваш сайт предоставляет окончательный ответ (завершающий пользовательскую сессию), когда пользователи ищут решение конкретной проблемы в определенной теме.

Важно также учитывать семантическую релевантность. Речь идет не только о широте тематики, но и о том, чтобы внимательно подходить к рассмотрению подтем и связанных запросов по всем вашим предметам — подумайте о общих темах или подобии моделей между вашими страницами и оптимальным охватом тем.

Здесь мы рассматриваем ‘информационный прирост’ как новые, не массовые знания или точки зрения, которые вы вносите в заданную тему. Иными словами, какие уникальные перспективы или данные вы привносите в эту конкретную область, которая может пока еще не быть широко принятой или обсужденной?

proof-of-concept

У вас когда-нибудь были такие мысли раньше?

Благодаря глубокому чтению и многочисленным дискуссиям я приобрел полное понимание топиковой авторитетности (topical authority). Вот мой взгляд на концепцию:

1. Топиковая авторитетность относится к степени признания человека или источника как знающего и влиятельного в определенной области или теме.

2. Обладание топиковой авторитетностью означает, что вы хорошо информированы, обладаете экспертизой и способны предоставлять ценные инсайты по данной конкретной теме.

3. Это критически важно для создания доверия и авторитета среди вашей аудитории при написании или обсуждении темы, в которой у вас есть топиковая авторитетность.

4. Достижение топиковой авторитетности требует времени, усилий и преданности делу, но оно может значительно увеличить ваш влияние и воздействие в вашем поле деятельности.

- Google награждает сайты, глубоко освещающие тему.

- Он делает это, сравнивая то, насколько хорошо сайт охватывает релевантные сущности с собственным пониманием взаимоотношений сущностей Google.

- Google сопоставляет своё понимание с другими факторами, такими как профиль обратных ссылок сайта и упоминания в интернете, поведение пользователей и поисковые запросы на сочетание бренда с общим ключевым словом.

Тем не менее, позвольте мне представить доказательства, опровергающие идею о призрачности этого понятия, и почему эта концепция имеет значение для достижения естественного онлайн-превосходства.

- Новости о репутации изданий: В майском посте 2023 года в блоге Google по поисковому центру ‘Понимание авторитета новостных тем’ рассказывается, как Google оценивает экспертность публикаций в специализированных областях, таких как финансы, политика и здравоохранение.

- Документы Yandex просочились: Подобно Google, просочившиеся материалы Яндекса указывают на то, что они учитывают охват графа тем при ранжировании новостных и контентных центров (то есть сколько семантически связанных подтем сайт авторитетно затрагивает).

В совокупности инструкции от Google и подтвержденные утечки оставляют мало места для сомнений: знания по теме крайне важны, независимо от их случайной маскировки.

Это не просто миф о SEO; это действительно измеримый показатель, демонстрирующий глубину и надежность обращения вашего сайта к определенной теме. Этот аспект становится все более важным при переходе через страницы результатов поисковых систем (SERP), где доминирует оптимизация искусственного интеллекта (AIO).

Как измерить тематический авторитет

Когда вы понимаете важность установления специализированных знаний или релевантности в рамках предмета обсуждения, следующим естественным вопросом является: каковы эффективные методы измерения этого?

Хотя пятнадцать процентов ежедневных поисков в Google представляют собой новые запросы, важно отметить, что объем генерируемого веб-трафика никогда не сможет превысить общее количество поисковых запросов. Это ограничение распространяется и на трафик, созданный по конкретным ключевым словам внутри определенной темы, так как число поисковых запросов для этих слов ограничено.

Проще говоря:

Один из простых способов определить специализацию веб-сайта на конкретной теме — это анализ доли общего трафика сайта, приходящейся именно на эту тему. Я называю этот показатель «Тема Пропорция», что аналогично рыночной доле или доле голоса в более широком контексте.

Это очень практичный подход, поскольку он учитывает следующее:

- Ранг, определяемый обратными ссылками, глубиной и качеством контента, а также пользовательским опытом.

- Поищите объем и уровень конкуренции ключевого слова.

- Тот факт, что URL-адреса могут занимать высокие позиции по многим ключевым словам.

- Функции SERP и оптимизация сниппетов.

Проще говоря, расчет доли темы включает определение пропорции трафика, полученного от конкретных ключевых слов или тем для вас или вашего конкурента.

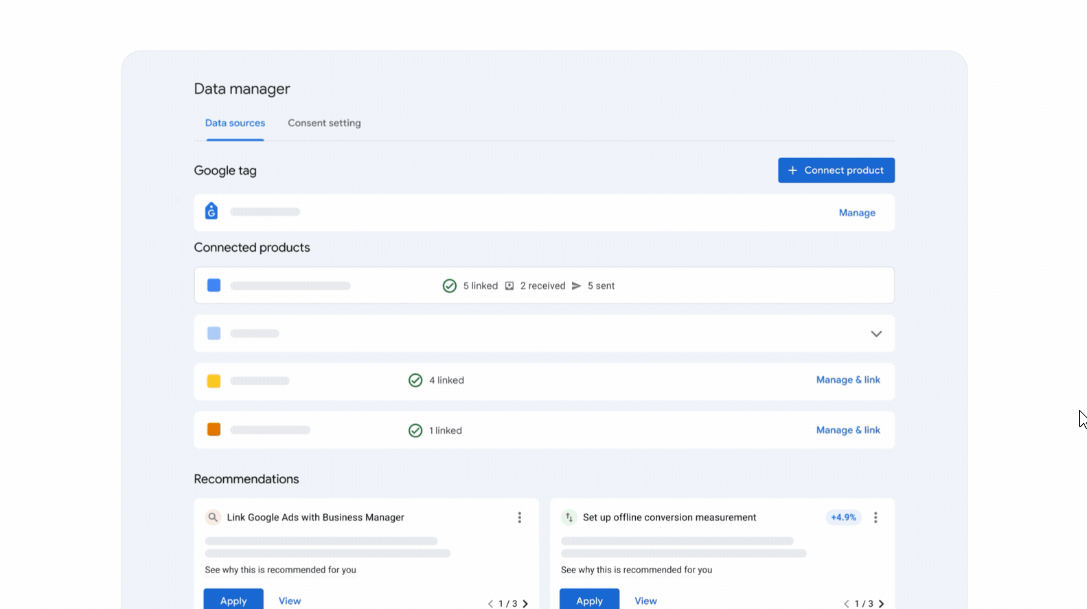

Например, вы можете сделать это в Ahrefs:

- Возьми сущность (главный термин), такую как ‘экомерчант’ и введи его в KeywordExplorer.

- Перейдите в секцию Соответствующие термины и отфильтруйте по объему, который больше или равно 10.

- Экспортируйте все ключевые слова и загрузите их снова в Keyword Explorer.

- Перейдите в раздел распределения трафика по доменам.

- Доля трафика = Доля темы = «Темерический авторитет».

Один простой способ определить, можно ли легко найти организацию, — это проверить наличие панели знаний в результатах поиска Google.

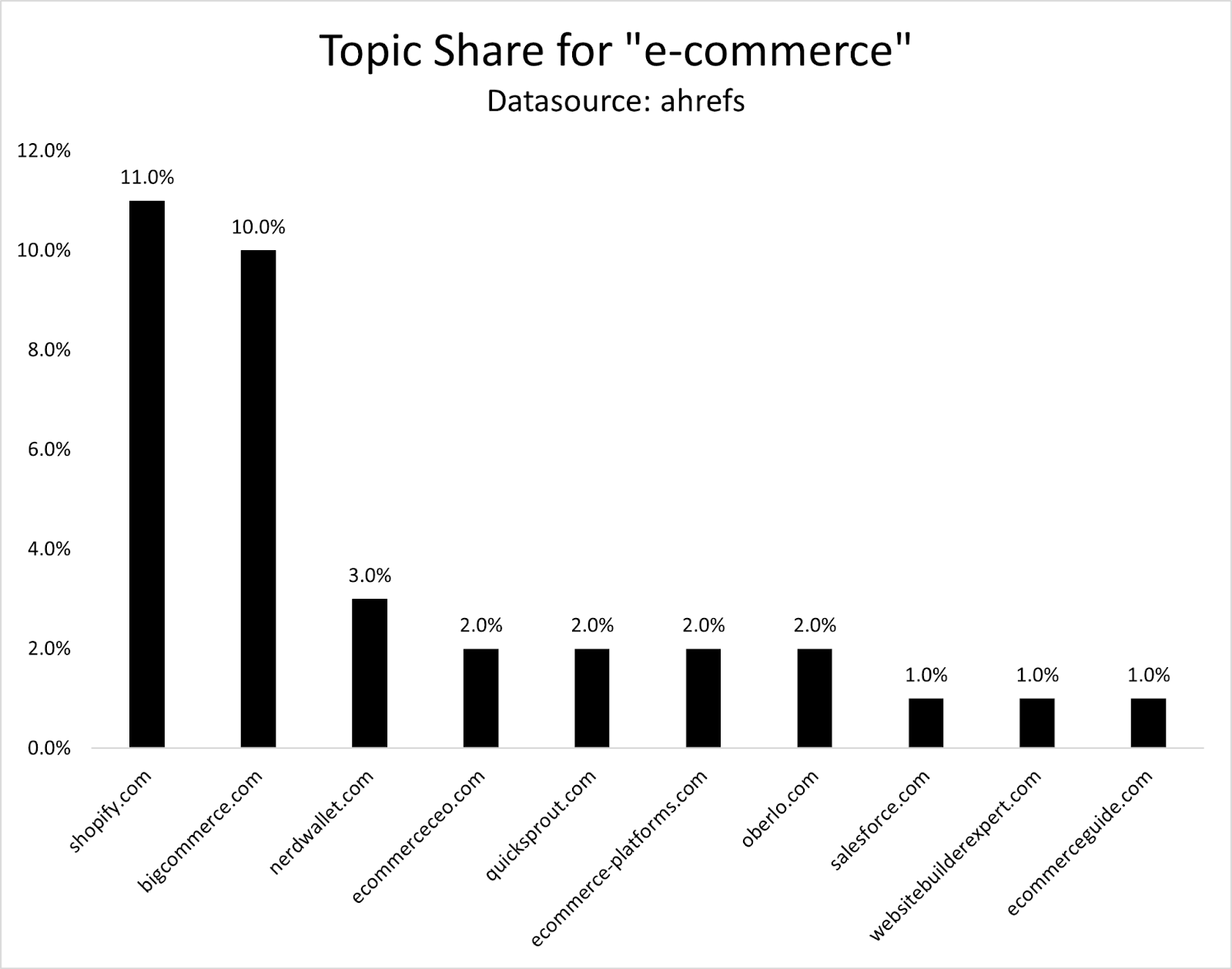

Пример: «Эко-коммерция»

Изначально, когда я впервые извлек этот экземпляр, Ahrefs показал около 29 135 фраз с использованием слова ‘экомерчандайз’ и минимальным объемом поиска в 10 запросов, согласно их инструмента Keyword Explorer.

По сути, эти 29,000 ключевых слов полностью охватывают предмет обсуждения, представляя собой полную 100%-ую охваченность темы. Если веб-сайт занимает первое место по каждому из них, он обеспечит максимальную охваченность или долю в теме.

Если часть контента каким-то образом заняла верхнюю позицию по каждому релевантному ключевому слову, она бы обладала 100% доминацией темы, однако подобный исход крайне маловероятен в реальности.

В результате нам нужно использовать тему сравнения Share относительно других сайтов.

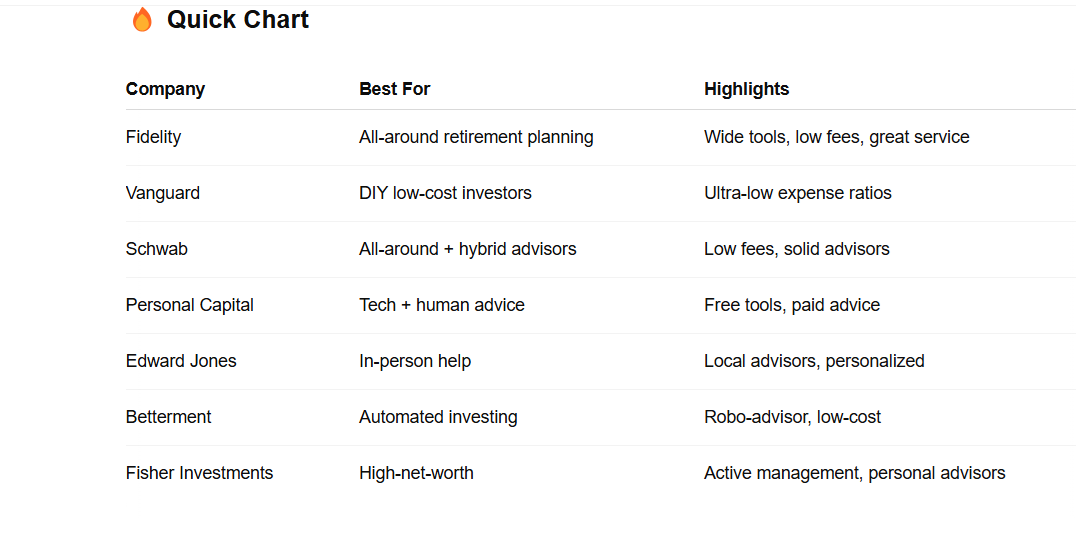

Я определил доминирование тем в области электронной коммерции (e-commerce) с использованием топ-3,000 наиболее часто запрашиваемых ключевых слов. Shopify занимает долю рынка 11%, за ним следует Bigcommere с долей 10%, а Nerdwallet составляет 3%.

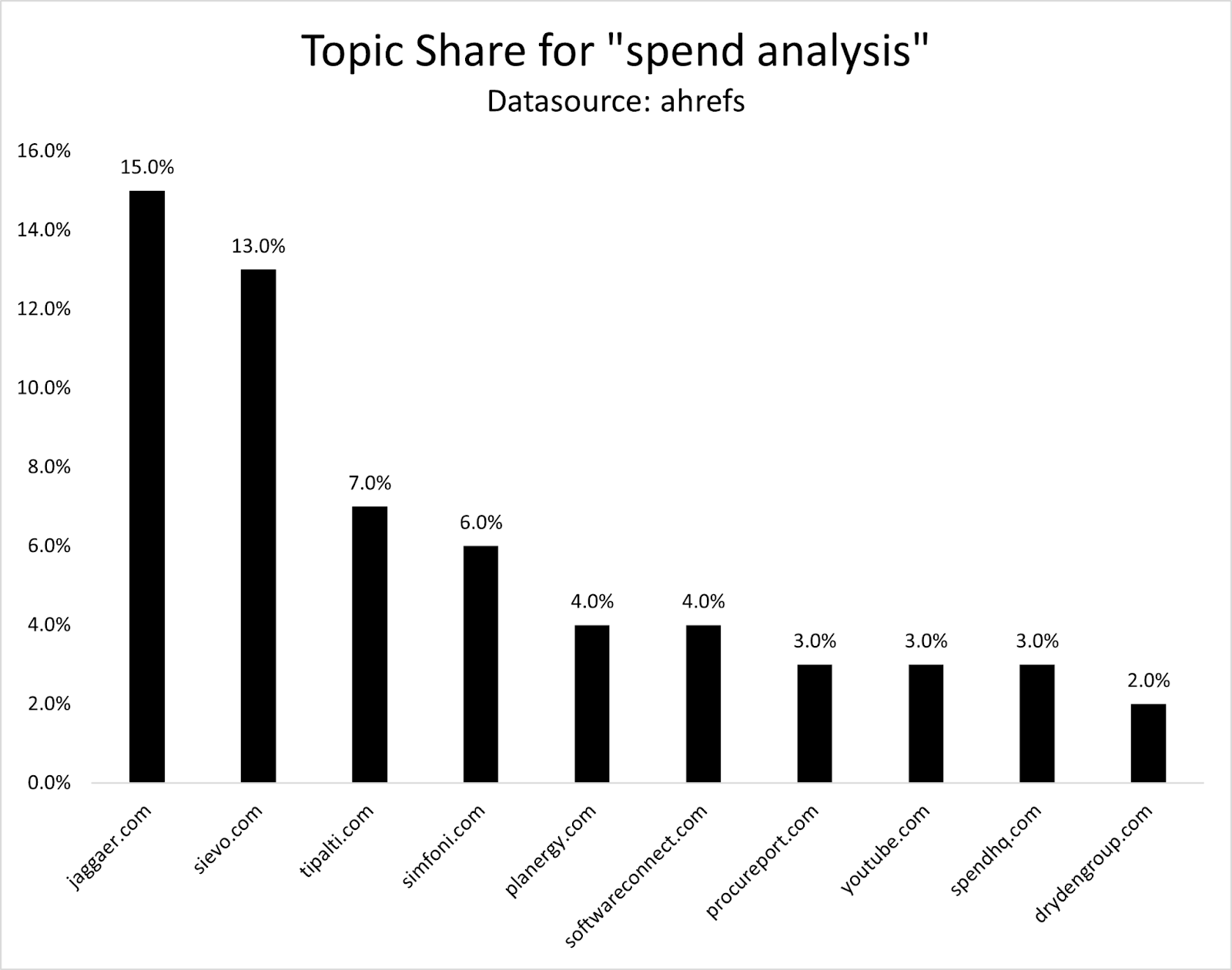

Пример: «анализ расходов»

Вот еще один пример с более узкой темой.

При проведении первоначального исследования с использованием Ahrefs термин ‘Spend Analysis’ был связан со 142 ключевыми словами. При использовании аналогичного метода Jaggaer.com занимает наибольшую долю тем — 15%, за ним следуют Sievo с долей в 13% и Tipalti, который составляет 7%.

Вместо постоянной проверки доминирования определенной темы с помощью отслеживания рейтинга ключевых слов в Ahrefs, это может стать финансово обременительным при работе с обширными темами. Чтобы оптимизировать ресурсы, можно использовать альтернативные методы оценки распространенности темы, такие как анализ трендовых обсуждений на социальных сетях или соответствующих форумах, а также изучение популярного контента от авторитетных источников в данной области.

Если ваша цель — отслеживать множество тем, вы быстро обнаружите, что сталкиваетесь с десятками тысяч ключевых слов.

Более управляемый подход заключается в проведении данного анализа каждый месяц с ручным фиксированием всех изменений (хотя это и не самый эффективный метод, он выполним).

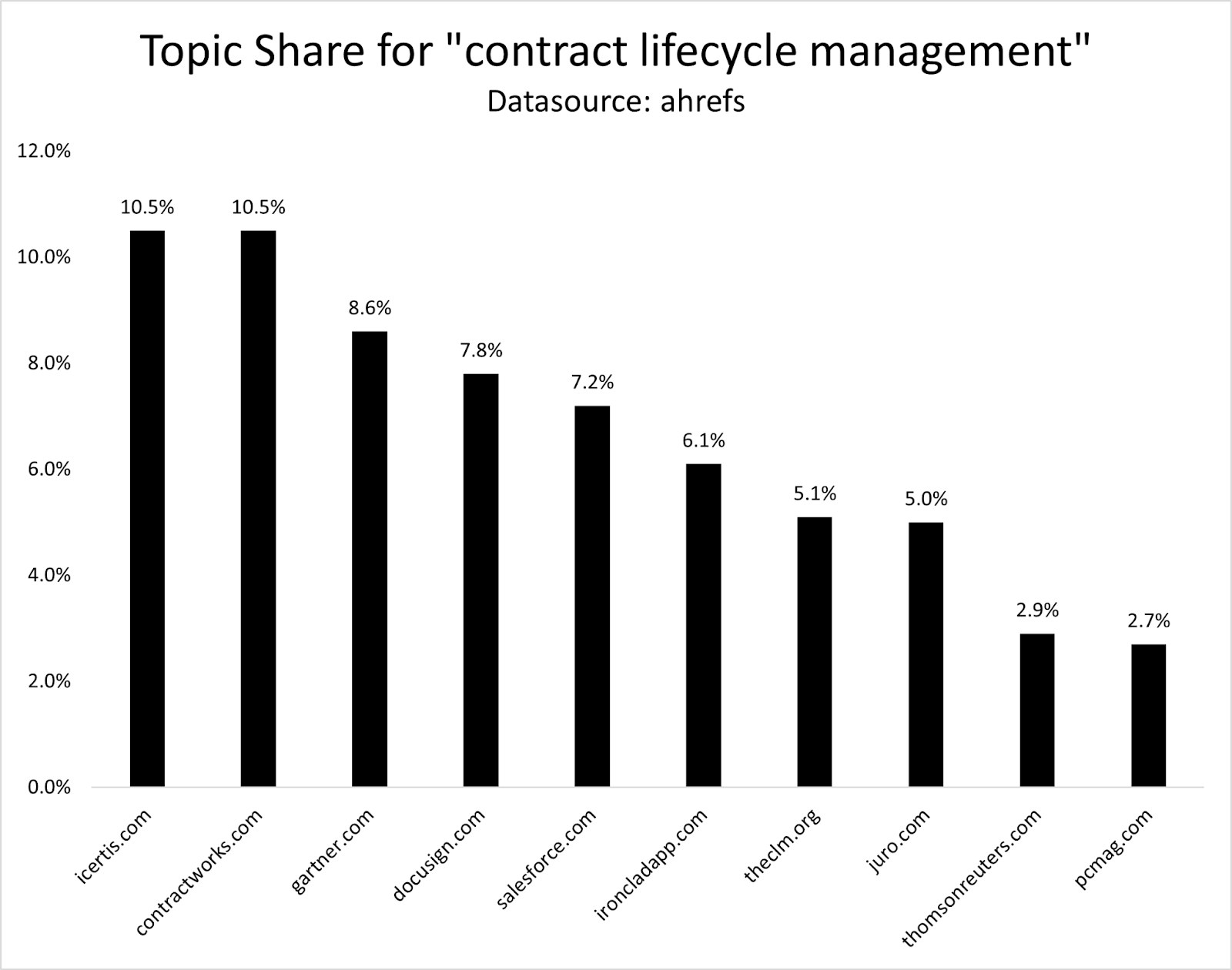

Пример: «Управление жизненным циклом контракта»

Другим примером является тема «управление жизненным циклом контракта», по которой насчитывается около 480 ключевых слов.

В этой области лидируют Iceert и Contractworks, за которыми следуют Garntner, DocuSign, Salesforce и Ironclad.

Почему вы должны измерять тематический авторитет

Если этот процесс такой ручной, стоит ли тратить время на его ежемесячное измерение?

Чтобы убедить заинтересованные стороны отдать приоритет инвестициям в тему X перед темой Y, как бы вы продемонстрировали потенциал более быстрого преимущества при поисковой оптимизации (SEO)?

Оценивая текущую глубину охвата каждого подтемы, вы можете определить основные предметы, где Google признаёт вас экспертом или авторитетом.

При расширении в новую область знаний из-за новых услуг или функций продукта полезно следить за своим уровнем экспертизы и оценивать его с точки зрения доминирования в данной теме относительно конкурентов, а также определять шаги, необходимые для установления авторитета в своей специализированной области.

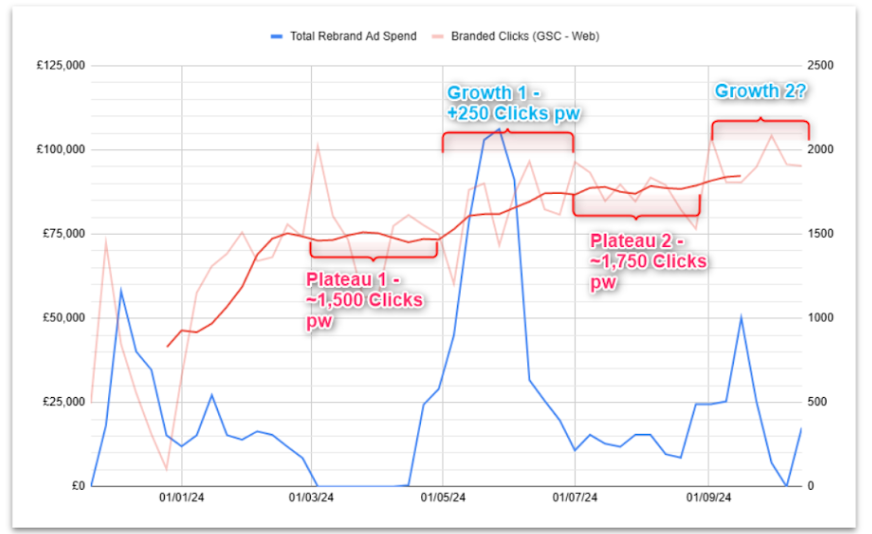

Если вы систематически отслеживаете это, то сможете связать долю вашего материала с данными отслеживания для искусственного интеллекта вещей (AIoT) и законопослушных машин (LLM), а также их воздействия.

Расследуйте общие темы между ними и поймите причины этого. Определите области, где ваше знание признается Google, но не признаётся экспертами по правовым языкам (Legal Language Masters, LLMs).

Практические рычаги местной власти

Построение и демонстрация экспертности в определенной тематике сводится к четырем основным рычагам.

По существу, это относится к количеству веб-страниц или тем, охватываемых на вашем сайте в рамках определенной тематической области, а также к качеству этих страниц с точки зрения их релевантности и глубины информации.

Погрузитесь глубже в богатство и практичность вашей коллекции контента, исследуя все аспекты выбранной вами темы. Ознакомьтесь с её основными составляющими, такими как определения, примеры использования, часто задаваемые вопросы и смежные подтемы для обеспечения всестороннего понимания.

Вместо того чтобы полагаться исключительно на традиционные методы, подумайте об использовании стратегий, ориентированных на сущности, или искусственного интеллекта для сопоставления вашего контента с идеями и запросами, которые обычно связаны с вашим предметом в поисковой системе Google.

Умная внутренняя перелинковка

Внутренние ссылки являются сигналами связи между статьями по одной теме.

Улучшение ключевых слов, используемых в качестве ссылок (анкор-текста), обеспечение релевантного содержания вокруг них (контекст) и увеличение количества связей на вашем сайте (внутренних ссылок) могут помочь Google лучше понять ваш контент и облегчить пользователям навигацию по сайту и обнаружение нужной информации.

3. Актуально значимые обратные ссылки и упоминания

Обратные ссылки служат дополнительным подтверждением для Google того, что созданный вами контент является ценным и соответствует определенной тематике.

Стремитесь к обратным ссылкам и упоминаниям от проверенных сайтов из смежных категорий.

Упоминание или ссылка в разделе Розничной торговли газеты Wall Street Journal (WSJ.com/business/retail) имеет большее значение для Shopify по сравнению с Salesforce, например.

4. Обрезать Контент

Я тщательно исследовал IBM и Progressive, две компании, преуспевающие в поисковой оптимизации (SEO) для конкурентных ключевых слов. После значительного сокращения, оба веб-сайта улучшили свою доменное авторитетность.

В SEOzempic я показал, как DoorDash непреднамеренно снизил органический трафик путем увеличения количества страниц. Суть авторитетности по теме заключается в интенсивной концентрации на вопросах, наиболее релевантных для вашего бизнеса, а не просто в наличии наибольшего числа страниц.

После удаления контента, не относящегося к их основным темам, все эти бизнесы испытали рост посетителей за счет естественного трафика. Иногда это включало высококачественный контент, который просто не соответствовал их веб-сайтам (как в случае с Progressive, которая обрезала страницы своих агентов).

Как Топикальная Авторитетность Влияет На Результаты ИИ

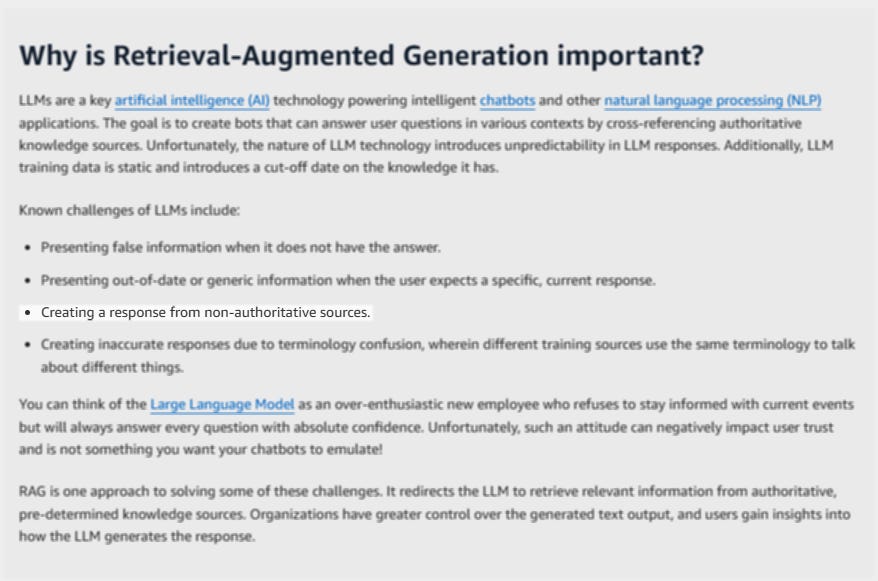

Локальная власть является ключевым элементом, благодаря которому LLM оптимизируют получение правильных ответов.

Проще говоря, генерация с использованием извлечения информации (RAG) — это система, используемая в таких моделях, как OpenAI’s, Google’s и Meta’s языковые модели (LLM). Эта система проверяет надежность внешних источников перед их использованием для обеспечения более точных ответов.

Как специалист по поисковой оптимизации (SEO), я понимаю важность качества данных и авторитетности при использовании предварительно обученных моделей, таких как OpenAI. Мы тщательно отбираем источники данных для обеспечения использования только высококачественной информации и материалов от надежных авторов в этом процессе.

В ходе начальной фазы обучения мы произвели отбор и проверку нашей смешанной базы данных, специально для модели GPT-4, исключив указанные документы из тренировочного пула. 3 Ссылка: Набор предобучения — это коллекция данных, используемая на этапе предобучения при обучении моделей машинного обучения, таких как GPT-4.

Однако важно отметить, что AIOS — не единственный тип контента, который получает признание. На платформах вроде ChatGPT и других моделях обучения языкам (LLM), верхние 10% наиболее заметного контента также благосклонно принимаются, если он предлагает полную информацию и соответствует идеальному профилю с высоким авторитетом.

Как ценный специалист по цифровому маркетингу, я рад сообщить о запуске специализированного потока контента, адаптированного специально для вас в ближайшие месяцы. Если вы еще не являетесь подписчиком, обязательно воспользуйтесь этой уникальной возможностью! Обновите подписку сейчас и оставайтесь впереди всех остальных. [Ссылка на обновление]

Прогнозирование тематических полномочий будущего SEO

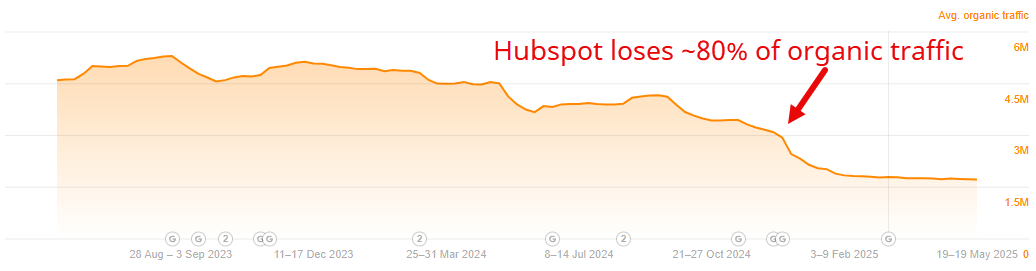

Отклонение от основных тематических зон может привести к существенным рискам в оптимизации поисковых систем (SEO), как показали примеры, такие как HubSpot.

Я называю это ‘чрезмерным группированием’. По сути, чрезмерное группирование происходит, когда вы создаёте тематические группы, которые не тесно связаны с вашими основными продуктами или услугами. Изучая периферийные темы и подтемы, вы рискуете ослабить идентичность вашего бренда. Будущее основное обновление может привести к значительному снижению посещаемости вашего сайта.

Тем не менее, хорошо зарекомендовавшие себя бренды вроде Forbes и LinkedIn сохранят свое влияние, поскольку они сохраняют высокий уровень доверия в своих областях, что может распространяться также на конкретные темы или запросы по нишам.

В области обзора ИИ часто упускаются возможности, которые кроются в цитированиях. Иногда это может привести к небольшим сайтам, обладающим авторитетом по узкоспециализированным темам или содержанию с нестандартной точкой зрения. Поэтому крайне важно сохранять комплексный подход в своей нише, чтобы гарантировать признание и приоритет вашей работы алгоритмами ИИ благодаря ее глубине и релевантности.

Из наших выводов в исследовании юзабилити, которое я недавно опубликовал, ясно, что люди склонны считать более привлекательными ответы от других людей по сравнению с теми, которые генерируются системами искусственного интеллекта.

Как подойти к авторитетности в тематике как SEO во время изменчивого поискового ландшафта

Я думаю, по сути есть два вопроса, которые нужно задать о вашем бренде:

Доверие: Достаточно ли наших знаний и понимания, чтобы эффективно решить эту тему? Накопили ли мы значительный объем релевантной информации, навыков и опыта для компетентного подхода?

Стратегия расширения влияния: Как мы можем планировать постепенное увеличение нашего влияния, особенно в условиях, где искусственный интеллект генерирует контент и эксерпты модели живого языка все чаще доминируют на страницах результатов поисковых систем (SERP)?

Истинный авторитет в теме не ограничивается выполнением требований, но предполагает создание доверия как среди людей, так и машин.

Исследование показывает, что высокий тематический авторитет приводит к более быстрой органической видимости в поисковых системах.

Понимание авторитетности темы новостей

Три ГПТ-4 системные карты

Представляем OpenAI о3 и o4-mini

Смотрите также

2025-05-21 16:41