За последние двенадцать лет я провёл более пятисот подробных обзоров веб-сайтов, которые показали устойчивые тенденции в отношении эффективных и неэффективных стратегий SEO.

Я видел почти всё, что может пойти не так или быть успешным на разных типах сайтов.

Вот более разговорчивый и персонифицированный подход для вас: Как специалист по цифровому маркетингу, хочу поделиться с вами ценными наблюдениями, которые помогут вам избежать дорогостоящих ошибок в SEO. По моему опыту, эти 11 практических уроков из ключевых областей, таких как технический SEO, on-page оптимизация, стратегия контента, инструменты SEO и off-page SEO, оказались невероятно полезными для эффективной оптимизации сайтов под поисковые системы. Давайте вместе окунемся глубже!

За десять лет я открыл для себя эти важные уроки. Прочитав эту статью, вы узнаете способы использования этих знаний для оптимизации усилий как своих собственных, так и клиентов по SEO, что потенциально позволит сэкономить значительное количество времени, ресурсов и снизить стресс — все это за час.

Урок №1: Техническое SEO — Ваша Основа Для Успеха В SEO

- Урок: Всегда начинайте работу по оптимизации под поисковые системы с технических основ; доступность и индексация определяют, могут ли поисковики вообще увидеть ваш сайт.

Обеспечение того, чтобы поисковые системы могли легко навигировать по сайту, анализировать и понимать его содержимое — это то, что мы называем техническим SEO (Technical Search Engine Optimization). Если поисковым системам сложно получить доступ к вашему сайту, даже отличный контент или многочисленные обратные ссылки не смогут существенно улучшить вашу видимость в интернете.

Основываясь на моем анализе более 500 сайтов, я убежден, что техническое SEO играет критически важную роль в оптимизации для поисковых систем. Эта существенная часть SEO может быть разделена на две ключевые концепции:

- Краулобабильность: Могут ли поисковые системы легко находить и перемещаться по страницам вашего сайта?

- Индексируемость: После сканирования могут ли ваши страницы появляться в результатах поиска?

Если ваши веб-страницы не проходят эти две проверки, они не попадут на поле игры в SEO; таким образом, усилия по поисковой оптимизации окажутся напрасными.

Очень важно регулярно проверять техническое состояние поисковой оптимизации вашего сайта с помощью минимум двух ключевых инструментов, а именно Google Search Console и Bing Webmaster Tools.

Приступая к любому SEO-аудиту, всегда задавайте себе эти два критически важных вопроса:

- Мог бы Google, Bing или другие поисковые системы просканировать и проиндексировать мои важные страницы?

- Позволяю ли я поисковым роботам сканировать только нужные страницы?

Один этот шаг может избавить вас от множества проблем и гарантировать отсутствие значительных технических препятствий в SEO.

Урок № 2: SEO в JavaScript может легко пойти не так.

- Урок: Будьте осторожны, сильно полагаясь на JavaScript. Он может легко помешать Google увидеть и индексировать важный контент.

JavaScript значительно расширяет интерактивные функции на веб-сайтах; однако даже таким сложным поисковым системам, как Google, может быть сложно последовательно понимать и индексировать такой контент.

Я проанализировал множество веб-сайтов, где производительность SEO была низкой из-за того, что важный контент скрывался от Google вследствие динамической загрузки через JavaScript.

Обычно в изначальном HTML отсутствовал важный контент, он не загружался корректно при рендеринге или были значительные различия между сырым HTML и отрендеренным HTML относительно контента или метаэлементов.

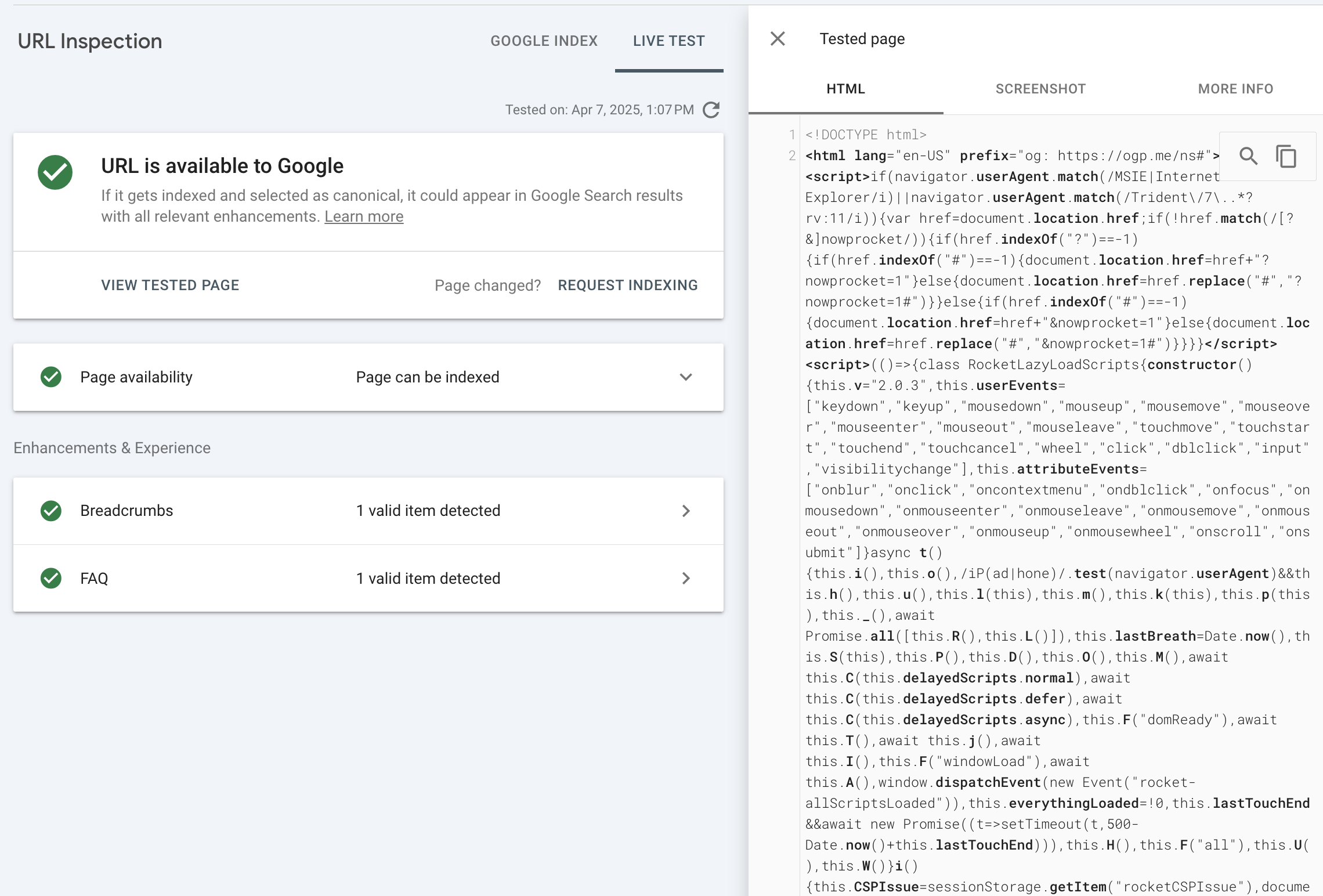

Вы всегда должны проверять, видит ли Google ваш контент на основе JavaScript.

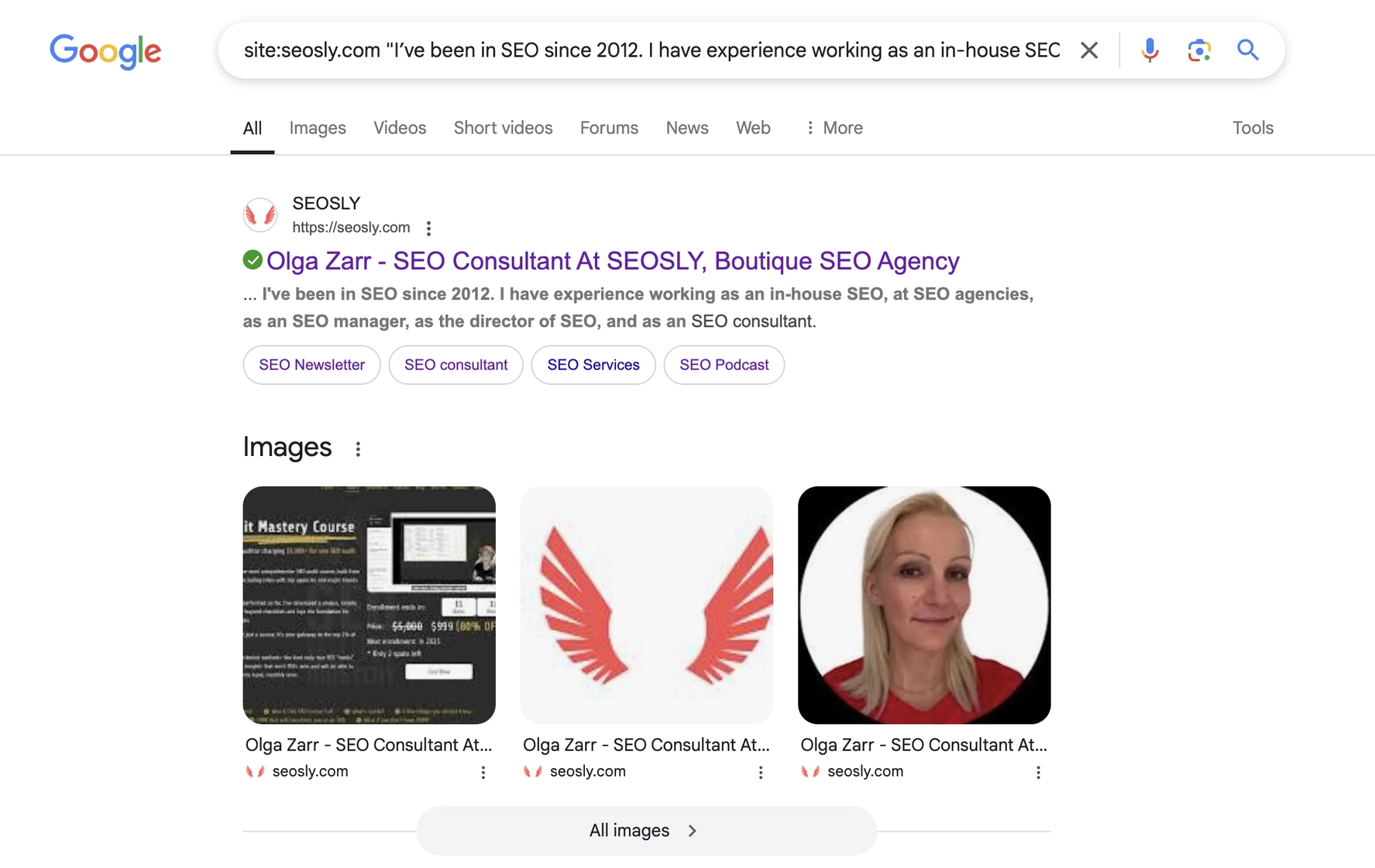

- Используйте тест живого URL в консоли поиска Google и проверьте отображенный HTML.

- Или выполните поиск в Google по уникальному предложению из вашего содержимого на языке JavaScript. Если ваше содержимое не отображается, возможно, Google не может его проиндексировать.

Вот несколько лучших практик относительно оптимизации под поисковики (SEO) на JavaScript:

- Критически важный контент в HTML: Вы должны включить названия, описания и важные элементы непосредственно в исходный HTML-код, чтобы поисковые системы могли сразу индексировать его. Помните, что Google не прокручивает страницы и не кликает.

- Правильная настройка robots.txt: Сайты должны блокировать существенные файлы JavaScript, необходимые для отображения страницы, так как это предотвращает индексацию.

- Используйте доступные для сканирования URL-адреса: убедитесь, что каждая страница имеет уникальный и доступный для сканирования URL. Также избегайте использования фрагментов URL (#раздел) для важного контента; они часто не индексируются.

Для изучения полного набора советов по избеганию типичных ошибок JavaScript в области поисковой оптимизации и следования оптимальным практикам, пожалуйста, ознакомьтесь с руководством по JS SEO, созданным специально для специалистов по поисковой оптимизации и разработчиков.

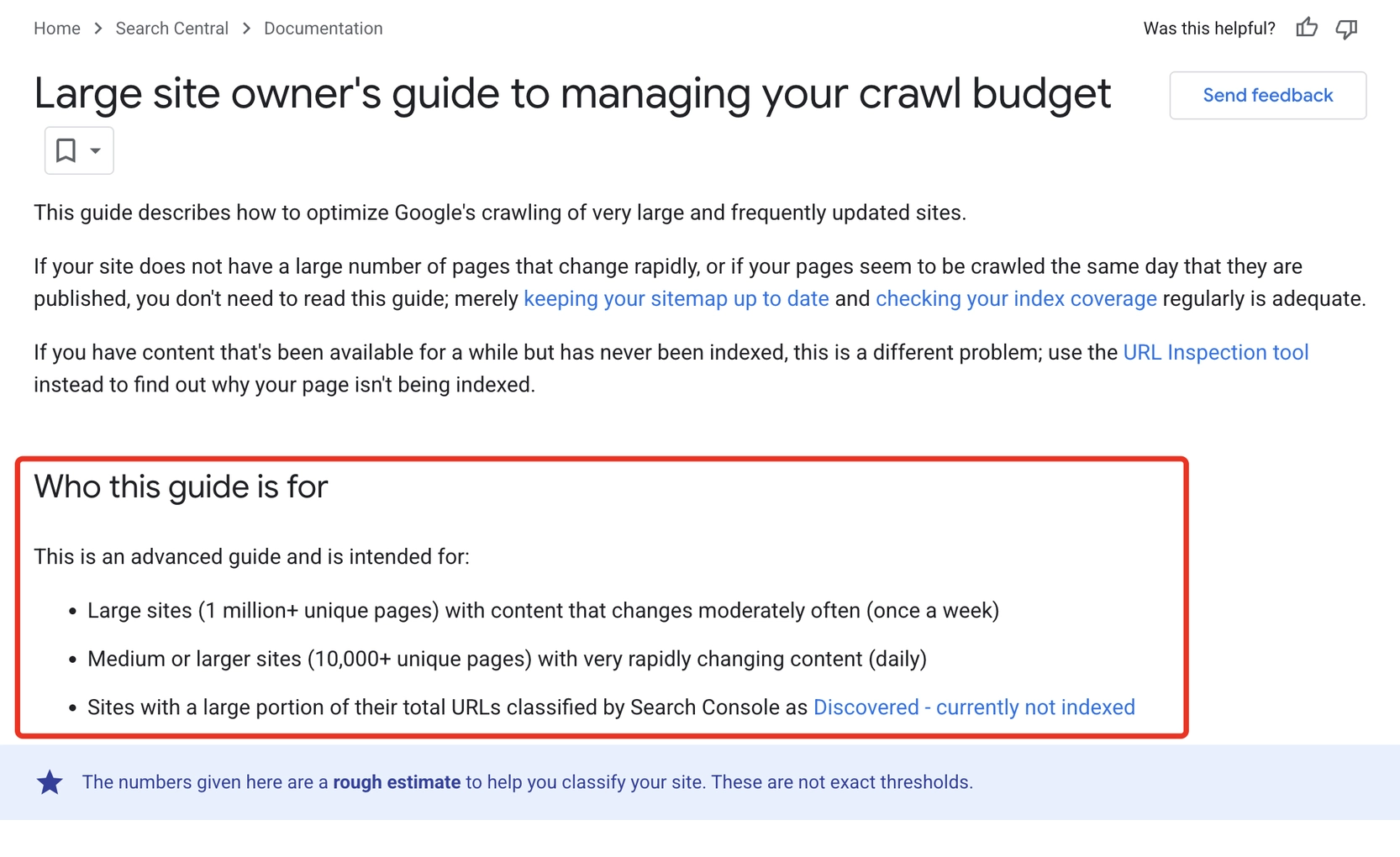

Как опытный вебмастер, я бы сформулировал это так: бюджет сканирования — это количество страниц на моем сайте, которые поисковая система, такая как Google, изучает в течение определенного периода. Это распределение зависит от двух ключевых факторов: 1. Общий размер и сложность сайта: более крупные и сложные сайты могут потребовать больше времени для тщательного изучения. 2. Популярность и свежесть сайта: страницы с частыми обновлениями или высоким трафиком обычно имеют приоритет в процессе сканирования.

- Ограничение пропускной способности Crawl: это предотвращает перегрузку вашего сервера слишком большим количеством одновременных запросов от Googlebot.

- Запрос на сканирование основан на популярности вашего сайта и частоте изменения его контента.

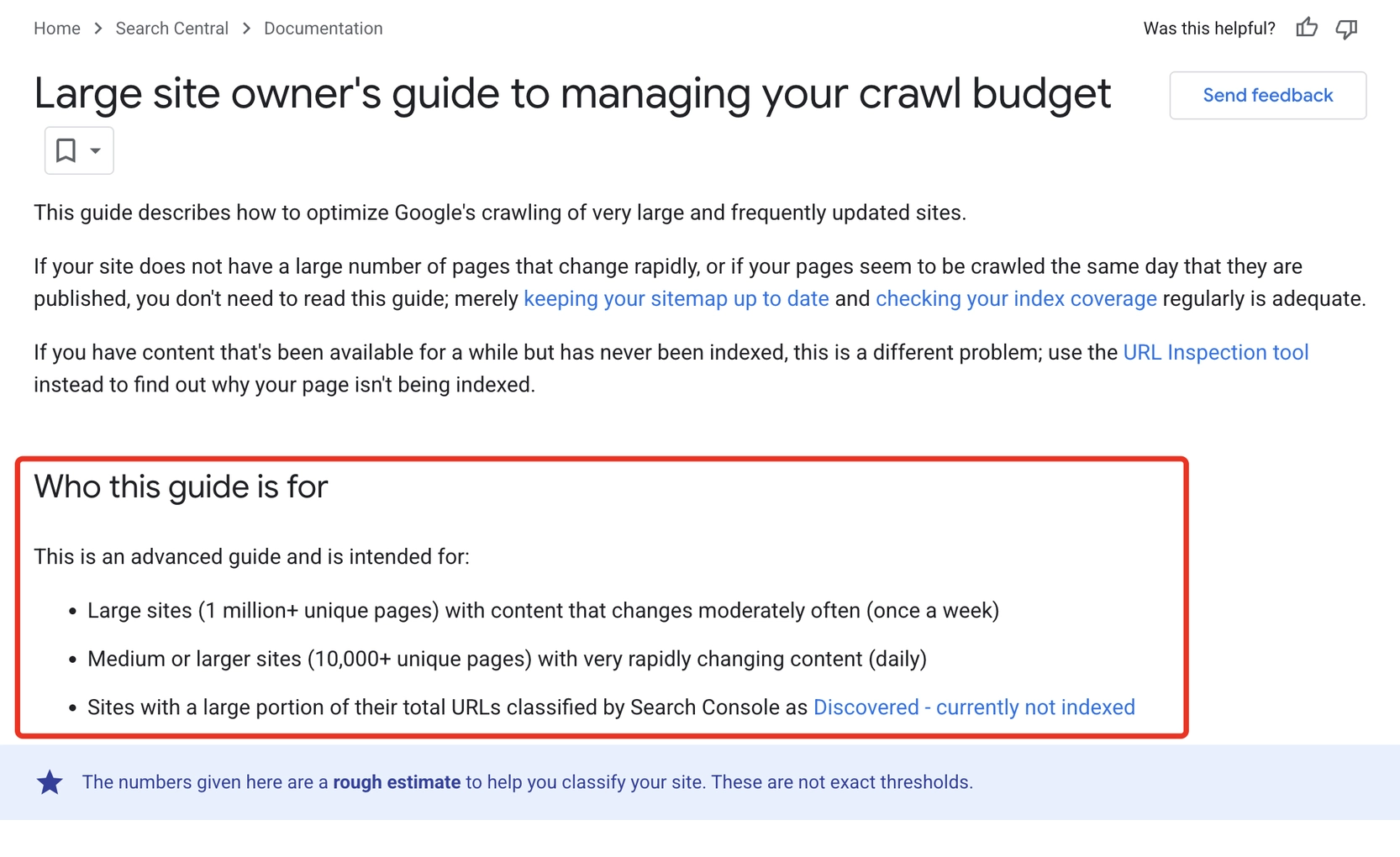

Несмотря на то что вы можете встретить онлайн, многие сайты не считают необходимым беспокоиться о бюджете краулинга. В общем и целом, Google эффективно управляет процессом веб-краулинга для небольших сайтов.

Для крупных веб-сайтов, особенно тех, которые содержат множество URL или часто обновляемый контент, управление бюджетом краулинга является крайне важным. Об этом особо подчеркивает Google в своих рекомендациях по бюджету краулинга.

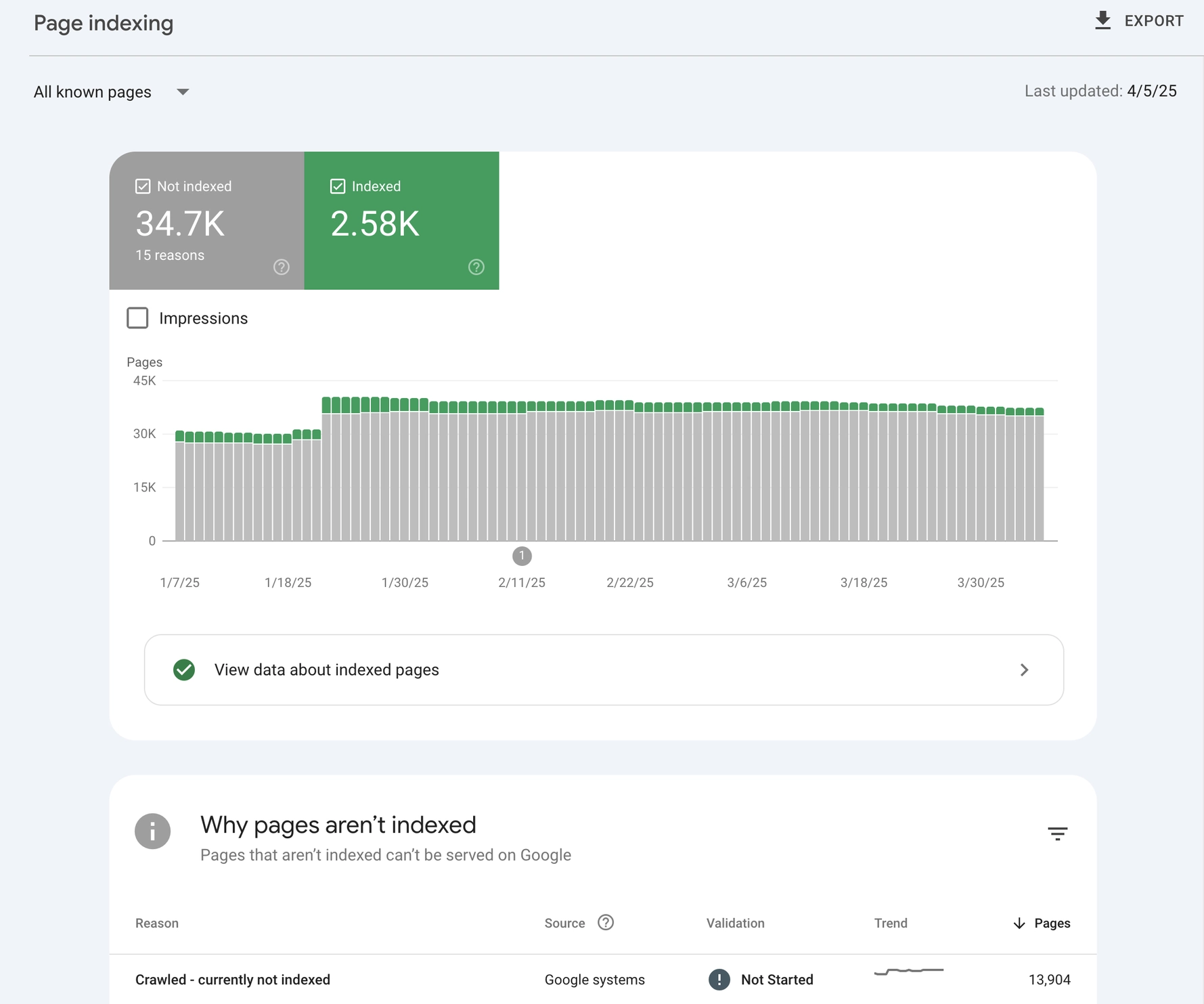

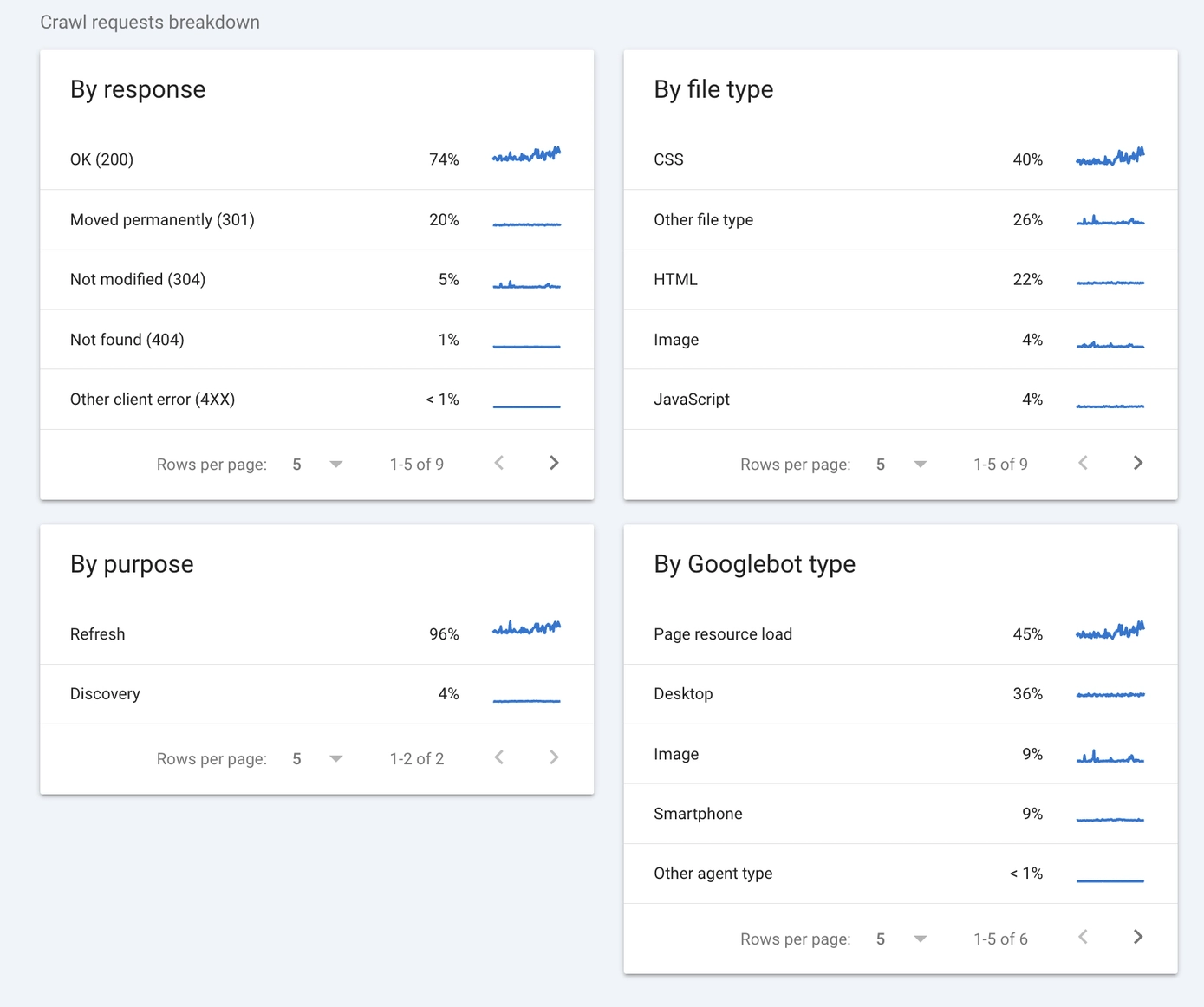

Вы можете оценить состояние бюджета сканирования вашего сайта, изучив отчет об индексации в консоли поиска Google Search Console. Обращайте внимание на: 1. Общее количество запросов: показывает, сколько раз бот Google запрашивал URL с вашего сайта. Высокое значение может указывать на то, что ваш сайт потребляет излишние ресурсы, поэтому стоит оптимизировать его для лучшей эффективности. 2. Запрошенные и проверенные URL: сравните эти два числа, чтобы убедиться, что Google может получить доступ к большинству страниц вашего сайта без ошибок. Если есть значительное расхождение между ними, исследуйте причины этих ошибок проверки. 3. Отправленные URL с предупреждениями: эти URLs могут не быть проиндексированы из-за проблем, таких как дублированный контент или заблокированные ресурсы. Устраните эти проблемы для улучшения общего состояния бюджета сканирования. 4. Заблокированные ресурсы: проверьте наличие ресурсов, заблокированных файлом robots.txt или метатегами, что может мешать эффективному сканированию вашего сайта ботом Google. При необходимости скорректируйте эти настройки.

- Проверено поисковым роботом — В настоящее время не проиндексировано: Обычно указывает на проблемы с индексацией, а не ограничение бюджета поисковых роботов.

- Обнаружено — В настоящее время не проиндексировано: Обычно это указывает на проблемы с бюджетом сканирования.

Полезно регулярно проверять отчёт о статистике сканирования в Google Search Console, поскольку он показывает количество страниц вашего сайта, которые сканируются Google каждый день. Сравнивая этот показатель с общим количеством страниц на вашем сайте, вы можете определить места для возможных улучшений.

Хотя краткий обзор в Google Search Console не может заменить анализ лог-файлов, он способен предоставить быстрые наблюдения относительно потенциальных проблем с бюджетом обхода (crawl budget), что может указывать на необходимость более детального анализа лог-файлов.

Это подводит нас к следующему пункту.

Урок №4: Анализ лог-файлов позволяет увидеть полную картину.

- Урок: Анализ лог-файлов необходим для многих вебсайтов. Он раскрывает детали, которые нельзя увидеть иначе, и помогает диагностировать проблемы с обходом и индексируемостью, влияющие на способность сайта занимать высокие позиции в поисковой выдаче.

Файлы логов хранят запись всех посещений поисковых роботов, таких как Googlebot и Bingbot. Эти записи указывают на то, какие веб-страницы были просканированы, с какой частотой и какие действия выполняли эти автоматизированные агенты. Эта информация позволяет определить потенциальные проблемы и принимать взвешенные решения о том, как эффективно их решить.

Например, при перемещении по веб-сайту магазина можно столкнуться с тем, что автоматизированный бот Google (Googlebot) выполняет действия вроде добавления товаров в корзину и последующего их удаления. Такие повторяющиеся и ненужные операции могут непродуктивно расходовать бюджет сканирования сайта.

Вот как вы можете использовать анализ лог-файлов:

- Начните с доступа к логам активности ботов на вашем сервере.

- Посмотрите на какие страницы чаще всего заходят боты, как часто они посещают эти страницы и не застряли ли они на малоценных URL.

- Вам не нужно анализировать журналы вручную. Такие инструменты, как Screaming Frog Log File Analyzer, позволяют быстро определять паттерны.

- Если вы заметили проблемы, такие как боты, многократно сканирующие URL-адреса с параметрами, вы можете легко обновить свой файл robots.txt, чтобы заблокировать эти ненужные сканы

Получение лог-файлов иногда может вызывать затруднения, особенно на крупных корпоративных сайтах, где доступ к серверу ограничен или строго контролируется.

Если это правда, то вы можете воспользоваться упомянутой ранее статистикой обхода Google Search Console. Этот инструмент предоставляет ценные данные о деятельности поисковых роботов Googlebot, включая количество обработанных страниц, частоту их обработки и время ответа.

Просматривая статистику поискового трафика, можно быстро и информативно оценить потенциальные проблемы с взаимодействием поисковых систем, которые иначе могли бы остаться незамеченными, хотя логи файлов предоставляют наиболее полное представление.

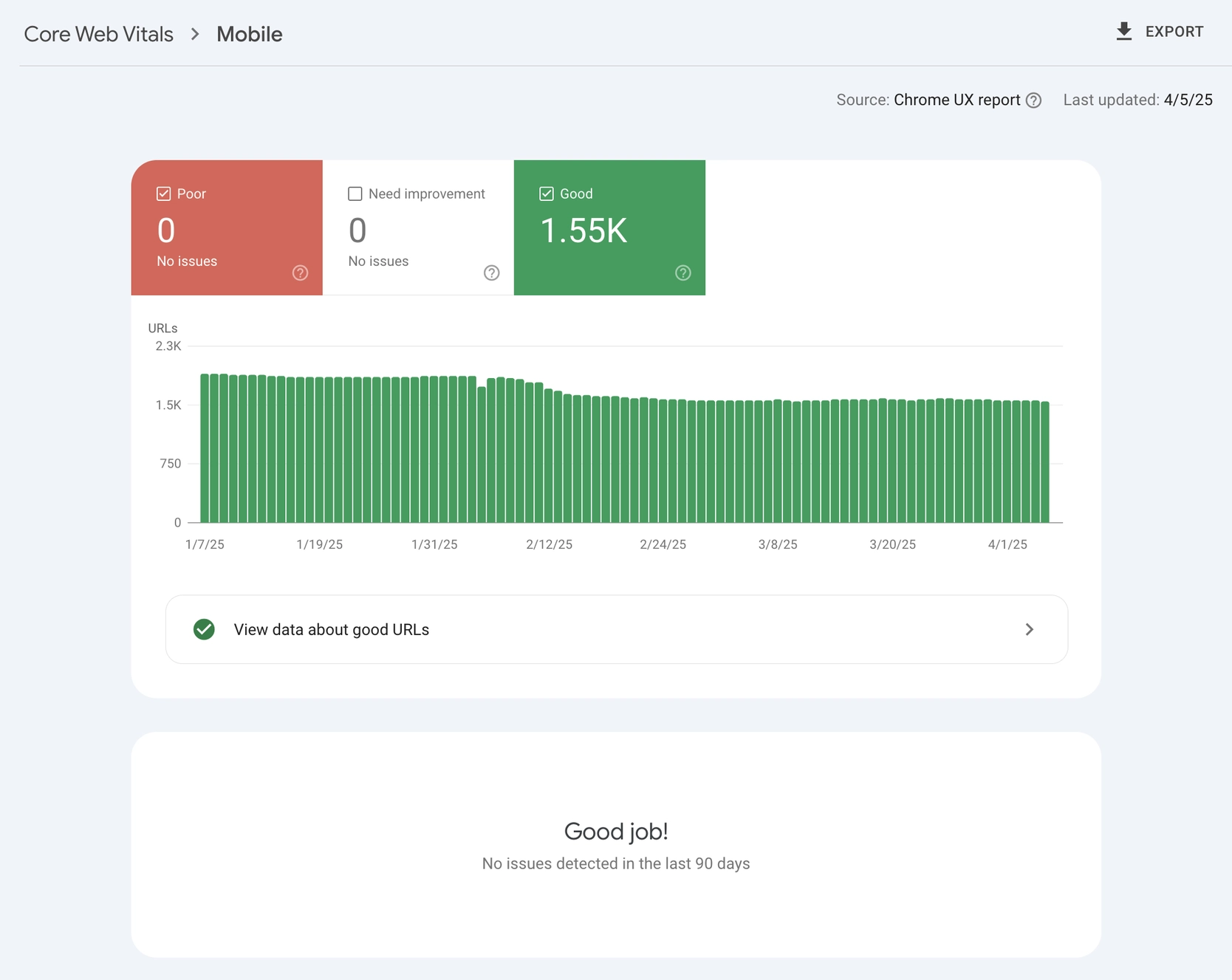

Основные показатели веб-жизненной важности оценивают скорость загрузки страницы, взаимодействие пользователя и качество визуализации, хотя вопреки распространенному мнению они не оказывают такого значительного влияния на позиции в поисковой выдаче, как можно было бы предположить.

Проведя анализ примерно 500 различных сайтов, я обнаружил, что ключевые показатели веб-производительности (Core Web Vitals) редко оказывают существенное влияние на позиции в поисковой выдаче при рассмотрении их изолированно.

Улучшения на большинстве сайтов заметны прежде всего тогда, когда время загрузки превышает 30 секунд значительно или имеются значительные проблемы, указанные в Google Search Console, где все вопросы выделены красным.

Часто клиенты вкладывают большие суммы денег — порой до десятков тысяч долларов — стремясь к оптимальному показателю показателей Core Web Vitals. При этом часто они пренебрегают важными основами SEO, такими как качество контента или продуманная стратегия ключевых слов.

Как профессионал в области цифрового маркетинга, я бы рекомендовал отдавать предпочтение анализу основных показателей производительности сайта (Core Web Vitals) на основе аутентичных данных из Google Search Console вместо лабораторных данных от Google PageSpeed Insights. Дело в том, что реальные данные более точно отражают опыт пользователей, что критично для успеха SEO. Кроме того, при оценке Core Web Vitals необходимо учитывать географическое расположение и среднюю скорость интернета целевой аудитории, так как эти факторы существенно влияют на время загрузки страницы и вовлеченность пользователей.

Пользователи, проживающие в городских районах с высоким качеством интернет-соединения, могут не испытывать существенного влияния от ключевых показателей производительности Core Web Vitals. Однако для тех, кто находится в сельской местности с более медленным подключением к интернету или использует старые устройства, скорость загрузки сайта и визуальная стабильность приобретают огромное значение.

По сути, при оптимизации основных веб-показателей важно учитывать уникальные требования вашей конкретной аудитории и реальные данные пользователей, а не общие сведения по отрасли.

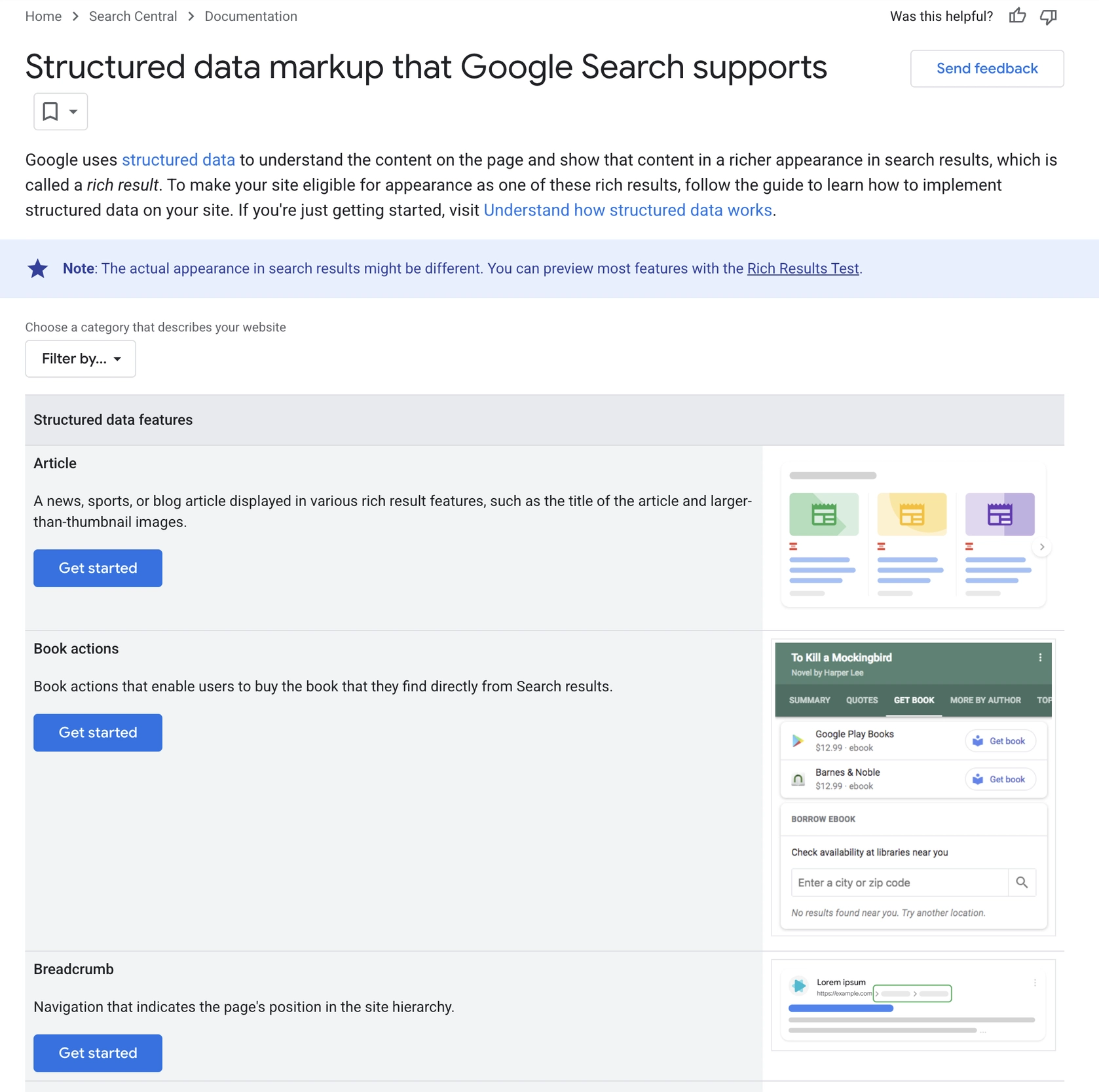

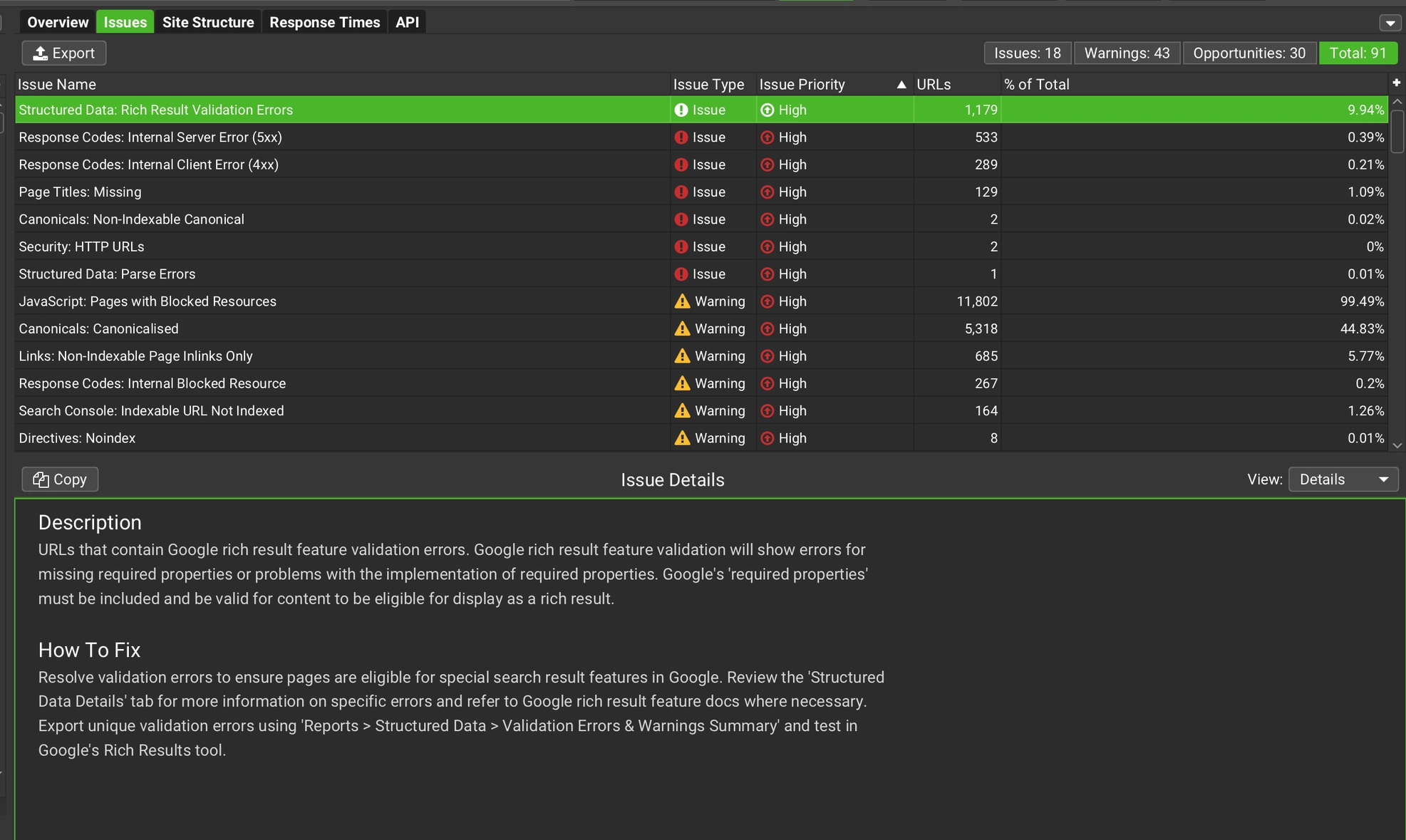

Урок №6: Используйте схему (структурированные данные), чтобы помочь Google понимать и доверять вам.

- Урок: Вам следует использовать структурированные данные (схему) чтобы рассказать Google кто вы такие, чем занимаетесь и почему ваш сайт заслуживает доверия и видимости.

Как специалист по цифровому маркетингу, я хочу подчеркнуть важность разметки схемы в нашей работе. По сути, разметка схемы — это способ чёткого определения значения нашего контента. Это позволяет поисковым системам, таким как Google, быстро понять основную тему и контекст наших веб-страниц, что, в конечном счёте, повышает их релевантность в результатах поиска.

Используя определенные типы схем, такие как разметка расширенных результатов, можно повысить видимость вашего листинга, отображая дополнительные детали, например оценки звезд, информацию о событиях или цены товаров. Эти «детальные превью» (или «обогащенные сниппеты») могут привлечь внимание в результатах поиска и потенциально увеличить кликабельность.

Как профессионал в области цифрового маркетинга я люблю представлять схему как описательные теги для Google. Эти теги могут быть применены к различным элементам, таким как товары, статьи блогов, обзоры или мероприятия, предоставляя краткое объяснение их связей и контекста. Таким образом, поисковым системам становится легче понять, почему мой контент соответствует определенному запросу поиска, что повышает его видимость.

Обязательно выберите подходящий тип схемы (например, ‘Статья’ для блогов или ‘Продукт’ для онлайн магазинов) и правильно реализуйте его с помощью JSON-LD. После этого тщательно протестируйте свою реализацию, используя либо Google Rich Results Test, либо Structured Data Testing Tool.

Схема позволяет оптимизировать SEO в фоновом режиме, не влияя на то, что видят ваши пользователи.

Клиенты SEO-услуг могут неохотно вносить изменения в видимое содержание сайта, однако обычно им кажется менее сложным внедрение структурированных данных, так как они не заметны для обычных посетителей сайта.

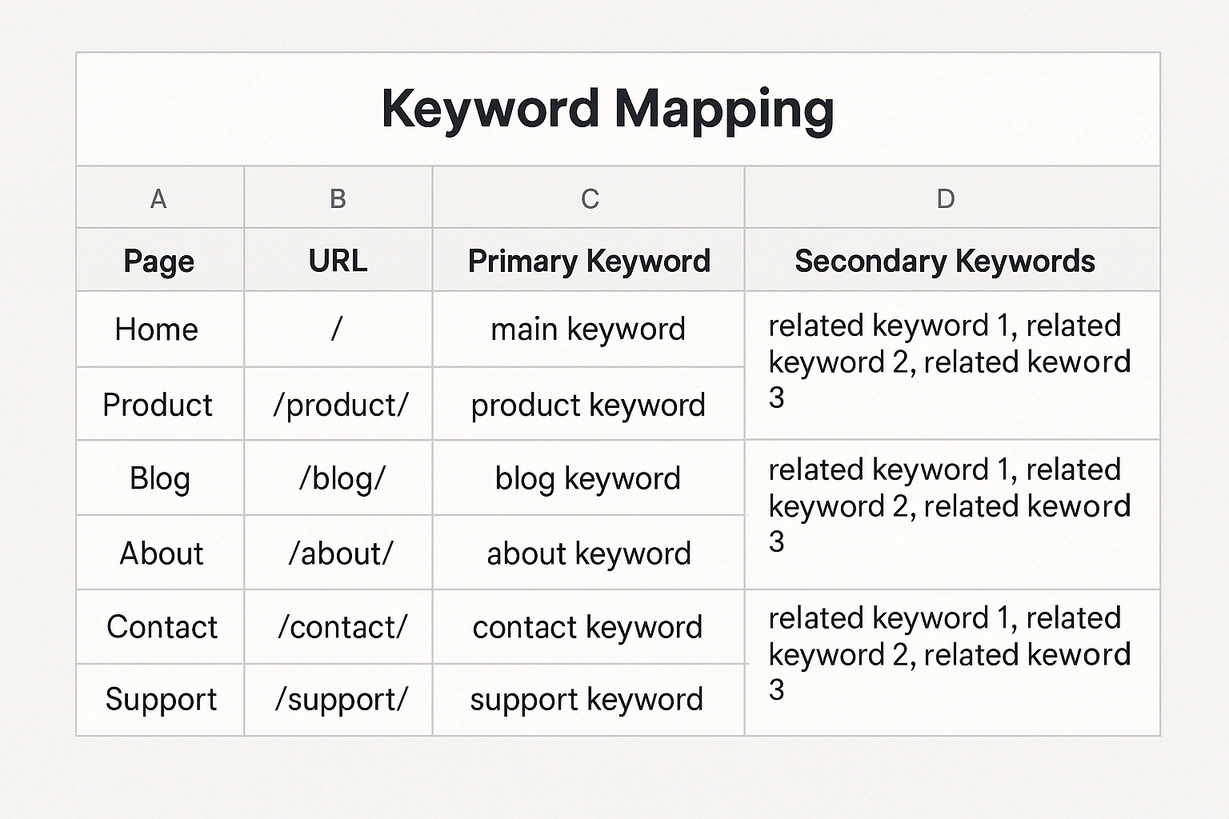

Урок №7: Исследование и планирование ключевых слов — всё!

- Урок: Техническое SEO помогает вам начать игру, контролируя то, что могут просканировать и проиндексировать поисковые системы. Но следующий шаг — исследование ключевых слов и их группировка — объясняет поисковым системам тему вашего сайта и как его ранжировать.

Часто сайты сосредоточиваются на самых современных методах SEO или стремятся к общим, высококонкурентным ключевым словам без тщательно продуманной стратегии. Обычно они упускают из виду тщательное исследование ключевых слов и редко выделяют ресурсы для их распределения по карте, что является критически важными компонентами для достижения устойчивых результатов в области SEO.

- Исследования ключевых слов позволяют определить точные слова и фразы, которые ваша аудитория использует при поиске.

- Назначением ключевых слов является привязка этих исследованных терминов к определенным страницам и определение четкой цели каждой страницы.

Каждый сайт должен иметь таблицу со всеми своими индексируемыми каноническими URL.

Для каждого URL-адреса указывайте основное ключевое слово, по которому он пытается занимать позиции в поисковой выдаче, а также некоторые связанные термины или альтернативные фразы. Это поможет улучшить SEO (оптимизацию для поисковых систем) и повысить видимость в поисковых машинах.

Для достижения более высоких позиций в поисковых системах для вашего контента крайне важно иметь правильную структуру. Отсутствие таковой может привести к тому, что вы будете полагаться на предположения и удачу при выборе ключевых слов, которые могут не соответствовать фактическому содержанию ваших страниц.

Иметь хорошо проработанную карту ключевых слов для каждой страницы гарантирует, что каждая веб-страница на вашем сайте выполняет определенную функцию, тем самым повышая общую эффективность вашего подхода к поисковой оптимизации (SEO).

Это не простая работа, это основа крепкой стратегии SEO.

Урок №8: SEO на странице отвечает за 80% успеха

- Урок: Из моего опыта аудитов сотен сайтов, внутренняя оптимизация (on-page SEO) обеспечивает около 80% результатов поисковой оптимизации. Тем не менее, только примерно один из каждых двадцати или тридцати рассмотренных мною сайтов справился с этим успешно. Большинство допускают ошибки на начальном этапе.

Вместо того чтобы сразу погружаться в построение ссылок, некоторые сайты поспешно накапливают множество низкокачественных обратных ссылок, используя повторяющиеся и точные ключевые анкоры без предварительной подготовки надежной основы для поисковой оптимизации.

Вместо этого они обходят анализ ключевых слов, игнорируют соответствие ключевых слов определенным веб-страницам и пренебрегают начальной оптимизацией основных страниц.

Я часто сталкиваюсь с повторяющейся закономерностью: концентрируясь на сложных стратегиях или привлекающих внимание методах, мы пренебрегаем основными методами, которые неизменно приносят результаты.

Создание сильной технической базы SEO обычно приносит значительные преимущества, когда речь идет о фокусировке на оптимизации отдельных веб-страниц (внутренняя оптимизация).

Вы найдете множество ресурсов с обсуждениями базовых методов оптимизации сайта под поисковые системы (on-site SEO): правильное структурирование заголовков, подзаголовков и текста с использованием релевантных поисковых запросов.

Мало кто на самом деле идеально применяет эти принципы. Лучше начать с основ, вместо того чтобы стремиться к сложным или изощренным стратегиям.

- Проведите тщательное исследование ключевых слов, чтобы определить термины, которые ваша аудитория действительно ищет.

- Сопоставьте эти ключевые слова четко с конкретными страницами.

- Оптимизируйте теги заголовков страниц, мета-описания, заголовки, изображения, внутренние ссылки и содержимое соответственно.

Следуя этим простым стратегиям, обычно достигается успех в SEO, однако некоторые предпочитают их обойти и искать сложные лазейки.

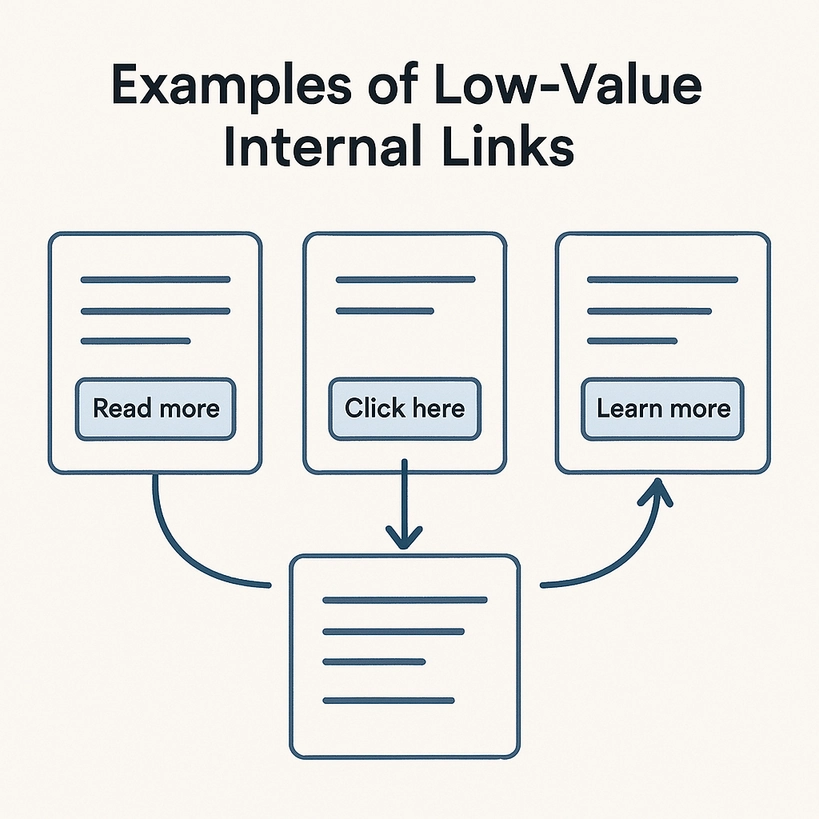

Урок №9: Внутренняя перелинковка — недооценённая, но мощная возможность SEO

- Урок: Внутренние ссылки обладают большей силой, чем раздутые внешние обратные ссылки, и могут существенно прояснить структуру вашего сайта для Google.

Внутренние ссылки гораздо более мощны, чем большинство владельцев сайтов осознают.

В то время как большое внимание часто уделяется обратным ссылкам с других сайтов, важно не упускать силу правильной внутренней перелинковки, которая может значительно улучшить производительность вашего сайта.

Если ваш сайт не является совсем новым, улучшение структуры внутренних ссылок может значительно улучшить вашу поисковую оптимизацию (SEO), так как это помогает поисковым системам, таким как Google, лучше понимать основную тему и контекст отдельных страниц вашего сайта.

Даже несмотря на то, что многие сайты активно используют внутренние ссылки, они часто не оптимизируют их должным образом. Вместо использования описательного текста ссылок, который предоставляет контекст о содержании связанной страницы, они зачастую выбирают общие фразы вроде «Читать далее» или «Узнать больше,», которые не предлагают никакой полезной информации поисковым системам относительно связанного контента.

Владельцы веб-сайтов часто обращаются ко мне, будучи убеждены, что им нужен глубокий технический аудит.

Изначально проблемы с поисковой оптимизацией сайта могут показаться сложными, но после тщательного анализа я часто обнаруживаю, что основной причиной является недостаточная внутренняя перелинковка или запутанная архитектура сайта. Это затрудняет понимание поисковыми системами вроде Google содержания и важности контента сайта.

Внутренняя перелинковка также может дать толчок к улучшению результатов недостаточно производительных страниц.

Связываясь со страницы с высоким авторитетом (имеющей множество внешних ссылок) на менее влиятельные страницы внутри вашего сайта, вы можете передать часть этого авторитета, что потенциально может улучшить их позиции в поисковой выдаче.

Потратив дополнительное время на улучшение внутренней структуры ссылок, вы всегда получите пользу. Эти ссылки легко реализовать и являются невероятно мощными ресурсами для SEO.

Урок № 10: Обратные ссылки — это только один из рычагов SEO, а не единственный.

- Урок: Никогда не нужно слепо гнаться за обратными ссылками, чтобы исправить свои показатели по поисковой оптимизации. Создавайте их стратегически только после освоения основ.

Аудит SEO часто показывает, что веб-сайты склонны переоценивать значимость обратных ссылок, тем самым упуская множество важных возможностей для оптимизации.

Игнорирование основных принципов SEO, таких как устранение технических проблем, проведение всестороннего исследования ключевых слов и стратегическое распределение ключевых слов по каждой веб-странице перед сосредоточением на построении ссылочного профиля — частая и дорогостоящая ошибка.

Даже после правильной настройки базовых параметров, построение ссылок никогда не должно быть случайным или реактивным.

Как эксперт по SEO, я часто сталкиваюсь с сайтами, которые слепо следуют стратегии построения ссылок только из-за ухудшения показателей SEO, ожидая чудесного улучшения. Однако такие тактики редко приводят к положительным результатам. Вместо этого сосредоточьтесь на создании высококачественного контента и развитии отношений с авторитетными ресурсами для получения органических, ценных обратных ссылок.

Вместо произвольного подхода к построению ссылок важно сначала проанализировать ваших конкурентов на страницах результатов поисковых систем (SERP), чтобы выяснить, являются ли обратные ссылки действительно важным фактором, которого вам не хватает.

- Внимательно посмотрите на страницы, которые превосходят вас.

- Определите, исходит ли их преимущество действительно от обратных ссылок или лучшей оптимизации на странице, качества контента или внутренней перелинковки.

Перед тем как инвестировать в целенаправленное наращивание ссылочной массы, убедитесь что ваш внутристраничный SEO оптимизирован, внутренние ссылки хорошо структурированы и подтверждено, что бэклинки действительно выделяют вас среди конкурентов.

Обычно нет необходимости иметь сотни низкокачественных ссылок на ваш сайт. Вместо этого, несколько тщательно подобранных редакционных линков или грамотно написанных пресс-релизов для SEO могут быть достаточны, чтобы улучшить позиции в поисковой выдаче.

Урок №11: Инструменты SEO сами по себе не могут заменить ручную проверку SEO

- Урок: Никогда не доверяйте инструментам SEO слепо. Всегда перепроверяйте их выводы вручную, используя собственное суждение и здравый смысл.

Использование инструментов SEO облегчает и упрощает наши задачи, делая их быстрее, менее трудоемкими и более продуктивными. Однако эти инструменты пока не могут полностью имитировать глубину и интуитивность анализа, предоставляемого человеком.

В отличие от специалистов по SEO, инструменты не способны понимать стратегический контекст и нюансы последствий. Они обычно не обладают возможностью связывать связанную информацию (или ‘соединять точки’) и оценивать истинную важность конкретных инсайтов.

Очень важно дважды проверить любые предложения от инструмента и самостоятельно оценить серьезность и практические последствия проблемы.

Часто владельцы сайтов обращаются ко мне в панике из-за «фатальных» ошибок, отмеченных их инструментами SEO.

Тем не менее, когда я вручную проверяю эти проблемы, большинство из них оказываются незначительными или несущественными.

Между тем, существенные компоненты поисковой оптимизации (SEO), такие как тактический выбор ключевых слов или оптимизация веб-страниц, часто игнорируются, поскольку ни один инструмент не может охватить все эти тонкие детали.

Инструменты SEO остаются полезными, поскольку выполняют обширные задачи, которые трудны для человека, например, изучение большого количества веб-адресов (URL) одновременно. Ручное выполнение такого объема работы заняло бы огромное количество времени и усилий.

Тем не менее важно проявлять осторожность при интерпретации их результатов. Вручную проверяйте значимость и последствия в реальной жизни перед принятием решений на основе них.

Итоговые мысли

После тщательного изучения множества веб-сайтов становится очевидным общий тренд — не сложно решаемые технические проблемы SEO, хотя они и имеют значение. Вместо этого важнее определить и решить более простые, но критически важные аспекты поисковой оптимизации.

Вместо множества проблем главная задача заключается в отсутствии четко определенного и приоритетного плана по поисковой оптимизации (SEO).

Часто работа по поисковой оптимизации выполняется без прочной базы или четких целей, что делает последующие усилия менее эффективными.

Частой проблемой является наличие технических трудностей, которые остаются незамеченными после миграции или обновления веб-сайта в прошлом. Эти невидимые проблемы могут привести к постепенному ухудшению позиций вашего сайта в результатах поиска на протяжении длительного времени.

Информация, которую я предоставляю, обычно покрывает большинство проблем, с которыми я сталкиваюсь регулярно. Однако всегда имейте в виду, что каждый сайт уникален и не обязательно соответствует универсальному чеклисту.

Каждый аудит должен быть адаптирован к уникальным обстоятельствам сайта, принимая во внимание его специфический контекст, потребности и предпочтения аудитории, цели, которые он стремится достичь, а также любые ограничения или трудности, с которыми он может столкнуться.

По мере того как инструменты SEO и искусственный интеллект становятся всё более полезными, важно помнить, что они являются лишь инструментами. В конечном счёте ключевые факторы успешного SEO — ваше личное суждение, практический опыт и старый добрый здравый смысл — остаются самыми значимыми.

Смотрите также

2025-04-30 14:41