![]()

Очень важно отслеживать данные конверсии в Google Ads, так как это гарантирует максимальную эффективность ваших рекламных затрат.

Без этого вы летите вслепую, гадая, что работает, а что тратит деньги.

Отличная новость! Настройка тега Google для мониторинга конверсий стала менее сложной по сравнению с предыдущими версиями. Теперь рекламодатели могут выбирать из множества методов установки, адаптированных к их конкретным требованиям.

Если вы новичок в этом или просто нуждаетесь в напоминании, вот пошаговое руководство по установке и правильной активации тега Google: 1. Сначала войдите в свой аккаунт Google Tag Manager. 2. Нажмите на ‘Новый тег’, чтобы создать новый тег. 3. Выберите тип тега (например, Google Analytics, отслеживание конверсий AdWords). 4. Заполните необходимые детали для выбранного типа тега. 5. Настройте требуемые параметры триггеров, когда должен сработать тег. 6. Проверьте ваш тег, чтобы убедиться в его корректной работе. 7. Наконец, опубликуйте изменения, чтобы обновленный тег стал активным на вашем сайте.

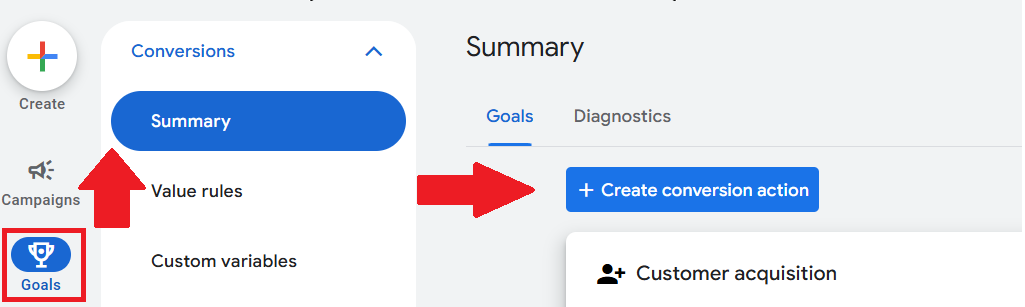

Шаг 1: Создание конверсионного действия

Прежде чем углубляться в детали настройки Google Tag, давайте сначала сосредоточимся на определении конверсионного действия.

Зачем нужны конверсионные действия?

Они являются критически важными данными, которые:

- Позволяет оценить эффективность рекламы, измеряя релевантные конверсионные действия пользователей на вашем сайте.

- Позволит оптимизировать ваши кампании, анализируя данные о конверсиях.

- Позвольте алгоритму использовать эти действия, чтобы определить ваших лучших клиентов и найти больше таких же.

Как эксперт SEO, я бы направил вас в мою учетную запись Google Ads, где мы настроем действие по конверсии. Чтобы начать, давайте перейдем вместе к целям и GT; Конверсии & gt; РЕЗЮМЕ. Оказавшись там, просто нажмите кнопку «+ Создать действие преобразования», и мы отключены!

Теперь пришло время решить, какие типы действий конверсии нужно отслеживать. Вы можете выбрать из:

- Веб -сайт.

- Приложение.

- Телефонные звонки.

Кроме того, Google предоставляет различные категории конверсий, чтобы помочь организовать отслеживание и объяснить причины этого. Категории конверсий, предоставляемые Google, состоят из:

- Покупка.

- Зарегистрироваться.

- Скачать.

- Подписаться.

- Получена информация о телефонном звонке.

- Заполнить форму лида.

- Записаться на прием.

- Запрос цитаты.

- Контакт.

- Добавить в корзину.

- Начало оформления заказа.

- Проложите маршрут.

- Доход от рекламы внутри приложений.

- Просмотр страницы.

- Исходящий клик.

Как опытный эксперт по SEO, я буду рад помочь вам управлять действиями конверсий в Google Рекламе. Вы можете настроить их автоматически через события на вебсайтах и приложениях или вручную, согласно вашим конкретным потребностям.

Выбрав события веб-сайтов и приложений в Google Аналитике, вы обнаружите, что нет необходимости изменять существующий код.

Для создания действия конверсии вручную вам потребуется добавить скрипт события в код вашего веб-сайта.

Шаг 2: Установка Тега Google

Существуют три основных компонента установки тега Google.

- Устанавливается тег Google.

- Добавляя фрагменты конверсионных событий (если создаёте действия по конверсии вручную).

- Проверка тега Google.

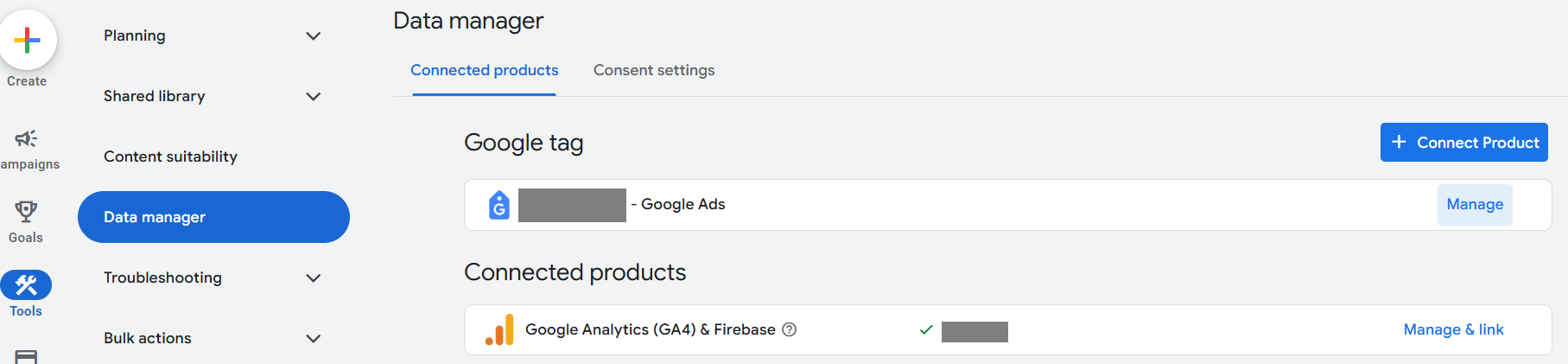

Как установить Google Tag

В интерфейсе Google Рекламы найдите опцию настройки тега. Перейдите в раздел «Инструменты > Управление данными».

Оттуда вы увидите первый вариант тега Google.

В предоставленном случае я уже установил метку Google. Для тех, кто этого еще не сделал, просто нажмите «+ Подключить продукт», чтобы настроить ее.

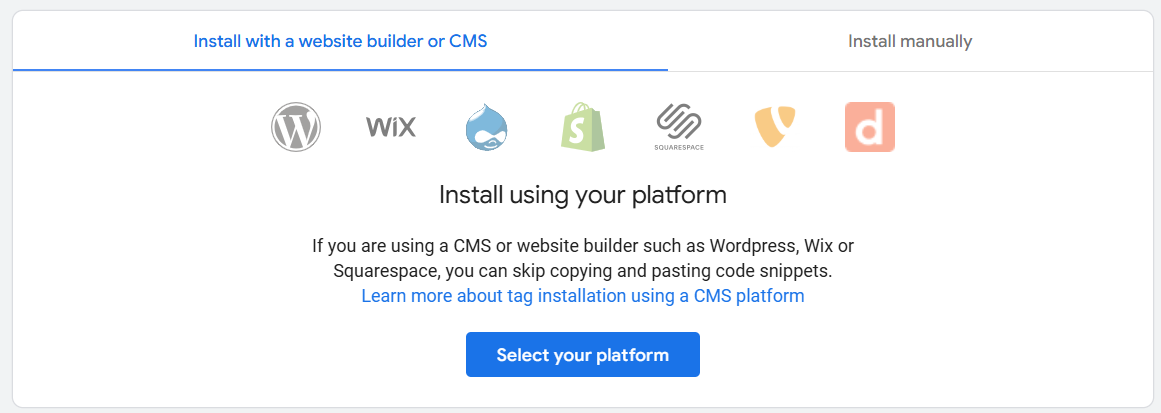

Тег Google можно установить двумя разными способами:

- Установите с помощью конструктора сайтов или системы управления контентом (CMS), такой как Wix, Shopify и т.д.

- Вручную.

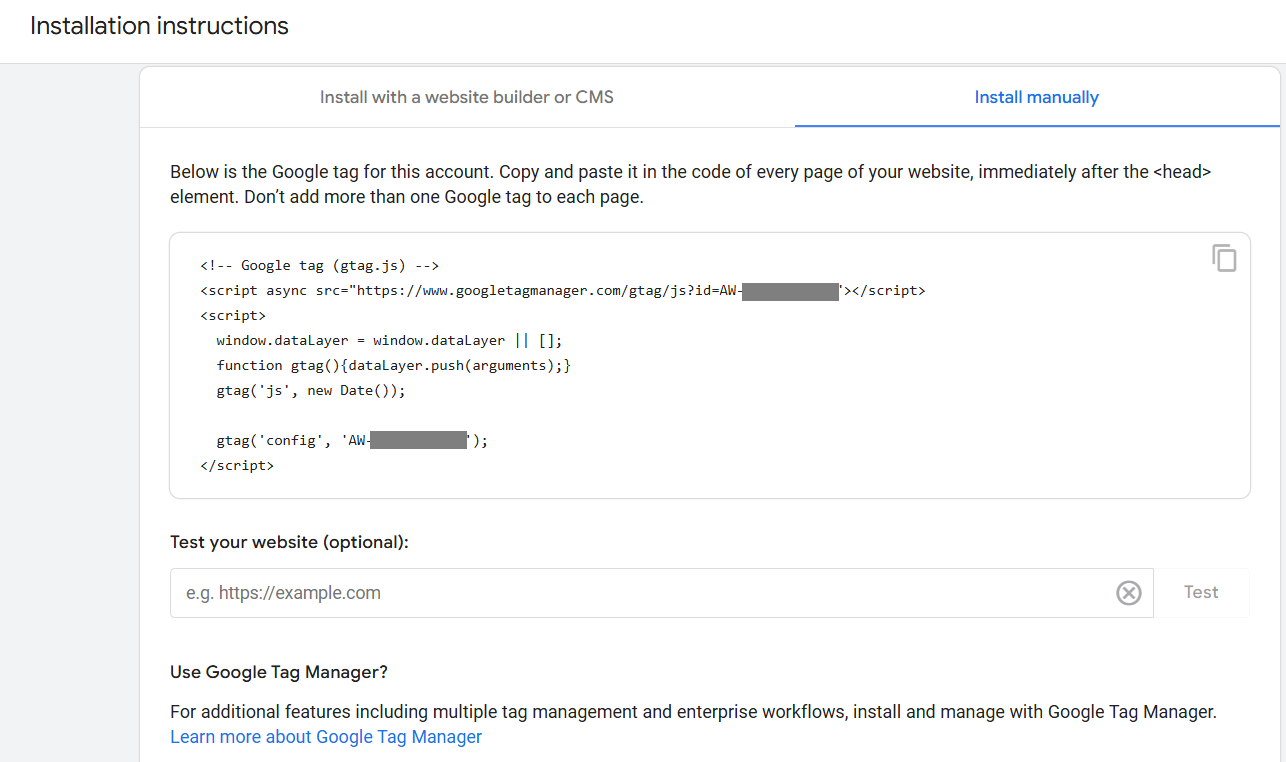

При ручной установке убедитесь, что вы скопировали и вставили код непосредственно после тега на каждой странице вашего сайта.

Важно не добавлять более одного тега Google на каждую страницу.

После добавления вы можете проверить сайт на работоспособность.

Подводя итог, если ваша команда использует Google Tag Manager, вы можете добавить тег Google для дополнительных возможностей. Это особенно полезно при работе с множеством тегов для целей управления.

Добавление сниппета события конверсии

Если тег Google был установлен через конструктор сайтов или CMS, вы можете пропустить этот шаг!

Если вы добавили тег Google вручную, это важный шаг, который нельзя пропустить.

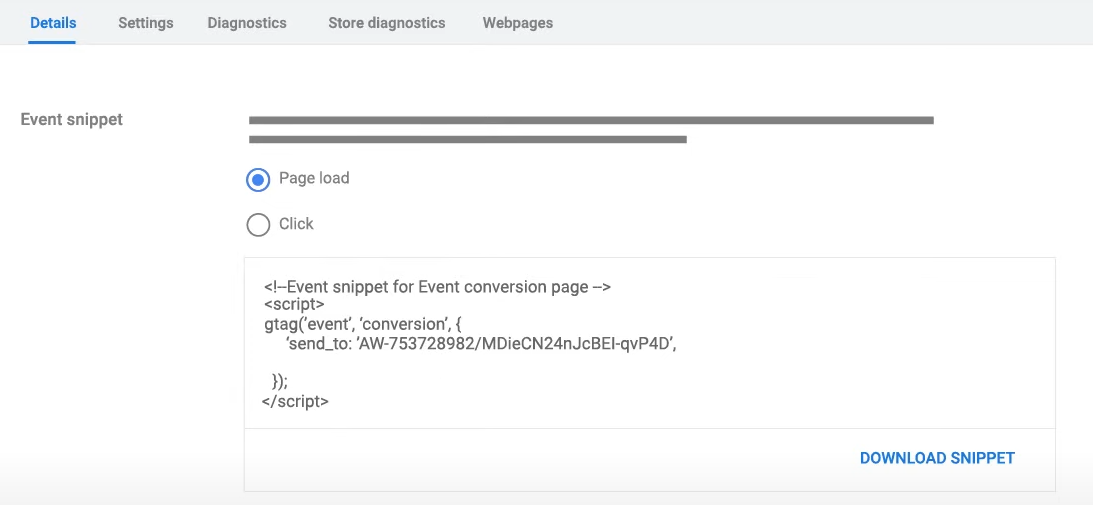

В разделе Google Tag в Google Ads перейдите к пункту «Детали», чтобы увидеть фрагмент события.

Отсюда вы выбираете способ отслеживания конверсий.

- Страница загружается.

- Клики.

Код можно скачать или скопировать непосредственно с этой страницы.

Наконец-то убедитесь, что вставляете код внутри области «» на соответствующих лендинговых страницах. Этот шаг крайне важен, так как позволяет отслеживать фрагмент кода по различным страницам, где происходят конверсии.

Проверяю Гугл Тэг

Как эксперт по SEO, я настоятельно рекомендую вам немедленно проверить настройки вашего тега, особенно если вы установили его вручную и использовали сниппеты для отслеживания конверсий. Это обеспечивает точное отслеживание производительности вашего сайта и эффективно оптимизирует ваши усилия в области SEO.

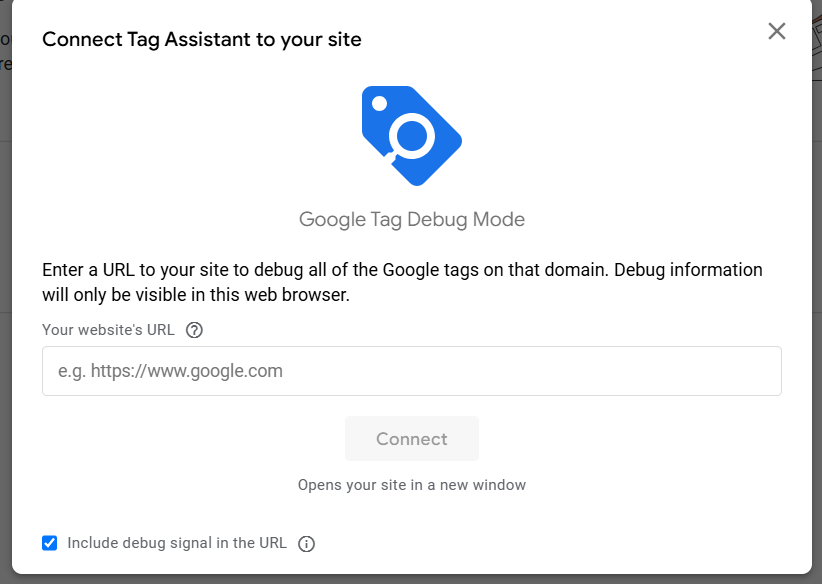

Как специалист по цифровому маркетингу, рекомендую перейти в раздел «Администраторы» внутри вашего аккаунта Google Ads. Там вы найдете опцию под названием «Запуск помощника тегов». Прокрутите страницу вниз до этого пункта и кликните для начала использования этого полезного инструмента.

Это откроет новую вкладку, где вы введете URL вашего сайта, а затем нажмете кнопку «Соединить»

С этого момента вы можете использовать Google Tag Assistant для проверки корректного размещения тега или определения необходимости дополнительных корректировок.

Точное отслеживание имеет важное значение

Как опытный веб-мастер, после успешного внедрения моего Google Тага, я с нетерпением наблюдаю за тем, как ценные данные конверсии начинают поступать, предоставляя мне истинные знания об эффективности моих рекламных мероприятий.

Больше не нужно гадать, приносят ли ваши кампании доход — теперь у вас будут данные, чтобы это доказать.

Имейте в виду: если ваш сайт претерпевает изменения (например, обновление процесса оформления заказа или изменение форматов URL), необходимо перепроверить настройку отслеживания для обеспечения корректной работы. Кроме того, если вы столкнулись с низким коэффициентом конверсии, начните с тестирования тега – зачастую это простая проблема.

Теперь вы на один шаг ближе к достижению целей своей кампании благодаря точным измерениям.

Смотрите также

- Анализ динамики цен на криптовалюту PI: прогнозы PI

- Акции X5. Корпоративный Центр Икс 5: прогноз акций.

- Акции DATA. Группа Аренадата: прогноз акций.

- Google Tests Learn More Links After Ad Text

- Акции OZPH. Озон Фармацевтика: прогноз акций.

- 7 лучших конструкторов целевых страниц для 2026 года

- SEO-специалисты рекомендуют структурированные данные для поиска с помощью ИИ… Почему?

- Акции VKCO. ВК: прогноз акций.

- Акции LENT. Лента: прогноз акций.

- Анализ динамики цен на криптовалюту OP: прогнозы OP

2025-04-11 15:09