Как опытный SEO-специалист с некоторыми седыми волосами, я видел свою долю головной боли, связанной с параметрами URL. Это все равно, что пытаться собрать кубик Рубика, жонглируя горящими факелами — сложно и потенциально опасно, если все сделано неправильно!

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)В мире SEO параметры URL представляют собой серьезную проблему.

Как для разработчиков, так и для аналитиков данных эти строки запроса могут оказаться ценными инструментами. Однако они доставляют настоящую неприятность, когда дело доходит до поисковой оптимизации (SEO).

Бесчисленные комбинации параметров могут разделить одно намерение пользователя на тысячи вариантов URL-адресов. Это может вызвать осложнения при сканировании, индексировании, видимости и, в конечном итоге, привести к снижению трафика.

Важно понимать, что просто желать, чтобы проблемы, связанные с управлением параметрами URL-адресов с точки зрения SEO, исчезли, невозможно. Вместо этого нам необходимо изучить эффективные стратегии правильной обработки параметров URL-адресов в контексте SEO.

Что такое параметры URL?

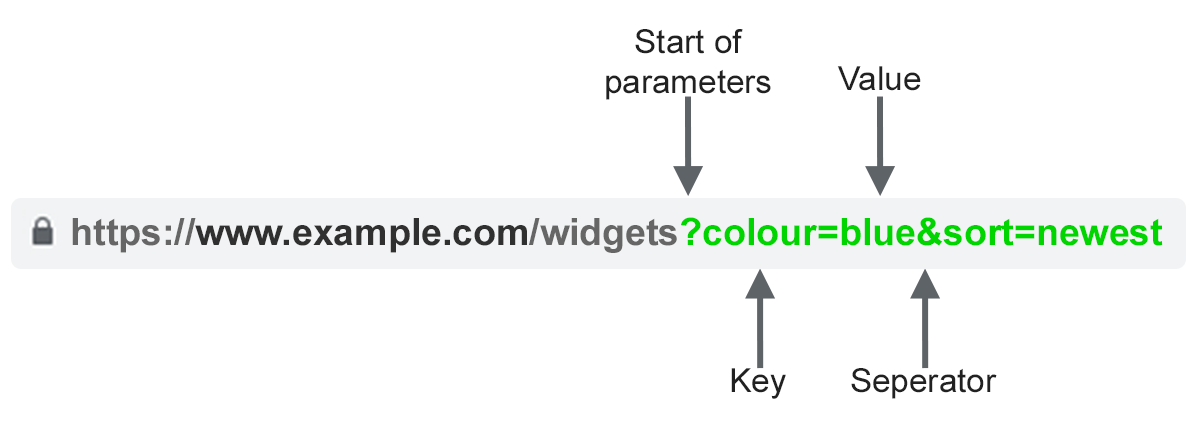

Как опытный веб-мастер, позвольте мне рассказать вам о параметрах URL-адресов, которые часто называют строками запроса или переменными URI. Это часть URL-адреса, которая идет после знака «?». символ. Они состоят из пары ключ-значение, где ключ и значение разделены знаком равенства («=»). На одну страницу можно добавить несколько параметров, разделив их амперсандом («&»).

Наиболее распространенные варианты использования параметров:

- Отслеживание Например ?utm_medium=social, ?sessionid=123 или ?affiliateid=abc.

- Изменение порядка. Например, ?sort=lowest-price, ?order=highest-rated или ?so=latest.

- Фильтрация – например ?type=widget, color=purple или ?price-range=20-50.

- Идентификация – Например ?product=small-purple-widget, Categoryid=124 или itemid=24AU.

- Разбиение на страницы – например, ?page=2, ?p=2 или viewItems=10-30.

- Поиск – например, ?query=users-query, ?q=users-query или ?search=drop-down-option.

- Перевод – например, ?lang=fr или ?language=de.

Проблемы SEO с параметрами URL

1. Параметры создают дублирующийся контент

Зачастую параметры URL-адреса не вносят существенных изменений в содержимое страницы.

Пересмотренный макет страницы обычно не сильно отличается от первоначального. URL-адрес веб-страницы, содержащий маркеры отслеживания или идентификатор сеанса, остается точно таким же, как оригинал.

Например, все следующие URL-адреса будут возвращать коллекцию виджетов.

- Статический URL: https://www.example.com/widgets

- Параметр отслеживанияr: https://www.example.com/widgets?sessionID=32764

- Параметр изменения порядка: https://www.example.com/widgets?sort=latest

- Идентифицирующий параметр: https://www.example.com?category=widgets

- Параметр поиска: https://www.example.com/products?search=widget

Наличие нескольких URL-адресов для практически идентичного контента во всех категориях на вашем сайте может быстро накапливаться, учитывая, что каждый из них увеличивает общую сумму.

Проблема заключается в том, как поисковые системы рассматривают каждый URL с параметрами как отдельные страницы. Это означает, что они воспринимают множество версий одной и той же веб-страницы, каждая из которых представляет идентичный контент и ориентирована на один и тот же поисковый запрос или тему.

Дублирование контента на вашем сайте, возможно, не приведет к его полному исключению из результатов поиска, но создает ситуацию, известную как «каннибализация ключевых слов». Это потенциально может снизить восприятие Google общего качества вашего сайта, поскольку дополнительные URL-адреса практически не приносят никакой дополнительной ценности.

2. Параметры снижают эффективность сканирования

Пропуск ненужных страниц, заполненных повторяющимися параметрами, во время сканирования веб-страниц ботом Google может затруднить индексацию важных SEO-страниц на вашем веб-сайте, а также увеличить нагрузку на ресурсы вашего сервера.

Google прекрасно резюмирует этот момент.

Как специалист по цифровому маркетингу, я заметил, что сложные структуры URL-адресов, особенно содержащие множество параметров, могут создавать проблемы для веб-сканеров. Это связано с тем, что они могут непреднамеренно увеличить количество URL-адресов, ведущих к идентичному или очень похожему контенту на наших сайтах, что может оказаться весьма затруднительным для эффективного управления поисковыми системами.

Следовательно, сканирующий бот Google потенциально может использовать больше данных, чем требуется, или не сможет полностью просканировать весь контент вашего веб-сайта.

3. Сигналы ранжирования страницы по параметрам

Когда идентичный контент веб-страницы представлен в разных формах или версиях, это может привести к тому, что ссылки и публикации в социальных сетях приведут к многочисленным вариантам этого контента.

Поступая так, вы ослабляете показатели релевантности для поисковых систем. Это действие вызывает путаницу у сканера, из-за чего он не знает, какой из нескольких страниц отдать приоритет при ответе на конкретный поисковый запрос.

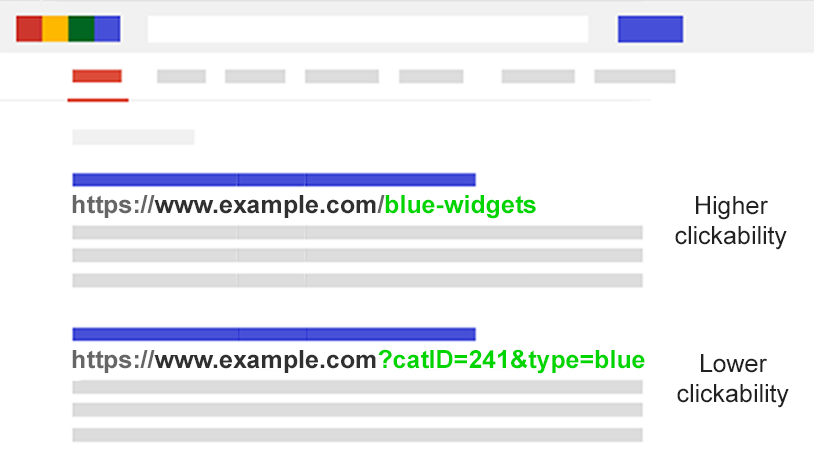

4. Параметры делают URL-адреса менее кликабельными

Понятно, что URL-адреса с параметрами могут быть непривлекательными и сложными для чтения. Они могут показаться не такими надежными, что делает их менее привлекательными для кликов.

Это может повлиять на скорость веб-страницы. Дело не только в том, что рейтинг кликов (CTR) влияет на рейтинг в поисковых системах, но и потому, что клики по ним становятся менее привлекательными в чат-ботах с искусственным интеллектом, сообщениях в социальных сетях, электронных письмах, онлайн-форумах или в любом другом месте, где виден полный URL-адрес, из-за возможное копирование и вставка.

В отношении каждой страницы эти действия — твиты, лайки, репосты, электронные письма, ссылки, упоминания — могут показаться незначительными, но каждое из них вносит значительный вклад в общую видимость вашего веб-сайта или его усиление в цифровом мире.

Плохая читаемость URL-адресов может способствовать снижению вовлеченности бренда.

Оцените масштабы проблемы с параметрами

Важно знать каждый параметр, используемый на вашем сайте. Но есть вероятность, что ваши разработчики не поддерживают актуальный список.

Как мы можем обнаружить все факторы, требующие управления, или понять, как поисковые системы сканируют и классифицируют эти типы страниц? Каково их значение для пользователей?

Выполните следующие пять шагов:

- Запустите сканер. С помощью такого инструмента, как Screaming Frog, вы можете выполнить поиск по запросу «?» в URL-адресе.

- Просмотрите файлы журналов: проверьте, сканирует ли робот Googlebot URL-адреса на основе параметров.

- Посмотрите в отчете об индексировании страницы Google Search Console: в образцах индекса и соответствующих неиндексируемых исключениях найдите «?» в URL-адресе.

- Поиск с помощью site: inurl: расширенные операторы. Узнайте, как Google индексирует найденные вами параметры, вставив ключ в запрос с комбинацией ключей site:example.com inurl:key.

- Посмотрите в отчете Google Analytics по всем страницам: выполните поиск по запросу «?» чтобы увидеть, как каждый из найденных вами параметров используется пользователями. Обязательно проверьте, что параметры URL-запроса не были исключены в настройках просмотра.

Вооружившись этими данными, вы теперь можете решить, как лучше всего обрабатывать каждый из параметров вашего веб-сайта.

SEO-решения для управления параметрами URL-адресов

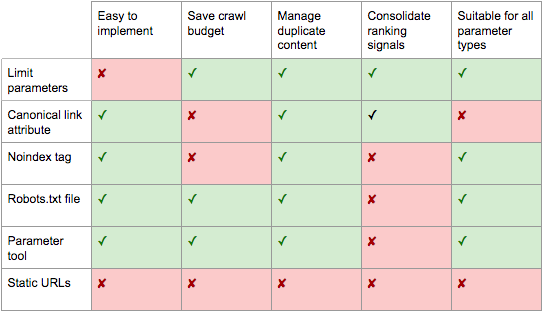

В вашем арсенале SEO есть шесть инструментов для работы с параметрами URL-адресов на стратегическом уровне.

Ограничить URL-адреса на основе параметров

Простой обзор того, как и почему генерируются параметры, может обеспечить быстрый выигрыш в SEO.

Вы часто будете обнаруживать методы упрощения URL-адресов за счет уменьшения количества параметров, тем самым ограничивая потенциальный вред для SEO. Вот четыре типичные проблемы, которые следует учитывать, начиная анализ.

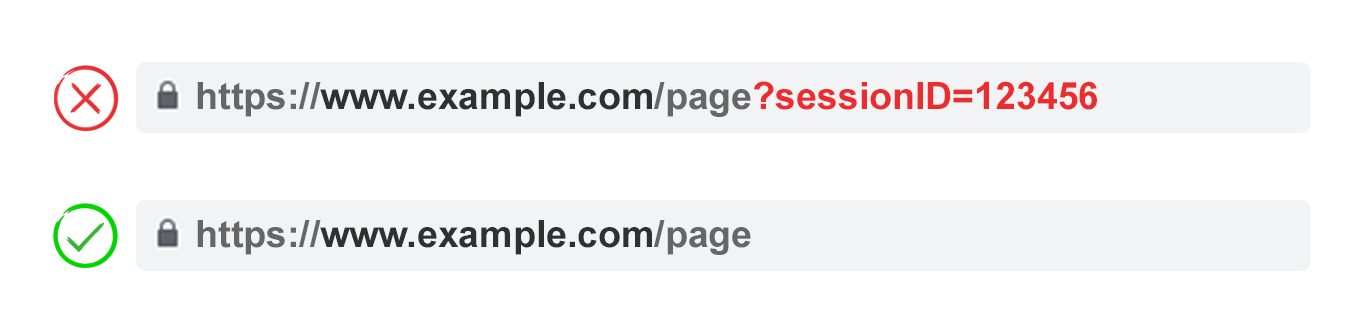

1. Устраните ненужные параметры

Как опытный веб-мастер, я бы порекомендовал обратиться к вашему разработчику и запросить подробное описание параметров каждого веб-сайта, а также их соответствующих функций. Вполне возможно, что некоторые параметры утратили свое первоначальное назначение и больше не представляют существенной ценности для сайта.

Например, пользователей лучше идентифицировать по файлам cookie, чем по идентификаторам сеансов. Тем не менее, параметр sessionID все еще может существовать на вашем веб-сайте, поскольку он использовался исторически.

Или вы можете обнаружить, что пользователи редко применяют фильтры в вашей фасетной навигации.

Любые параметры, вызванные техническим долгом, должны быть немедленно устранены.

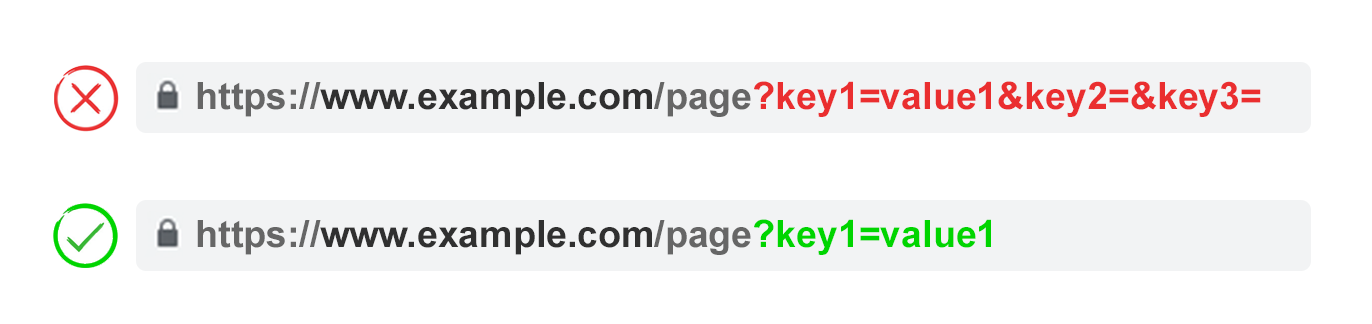

2. Не допускайте пустых значений

В URL-адреса включайте параметры только тогда, когда это необходимо для функциональности. Избегайте добавления пустых значений ключей в качестве параметров.

В приведенном выше примере ключ2 и ключ3 не добавляют значения ни в прямом, ни в переносном смысле.

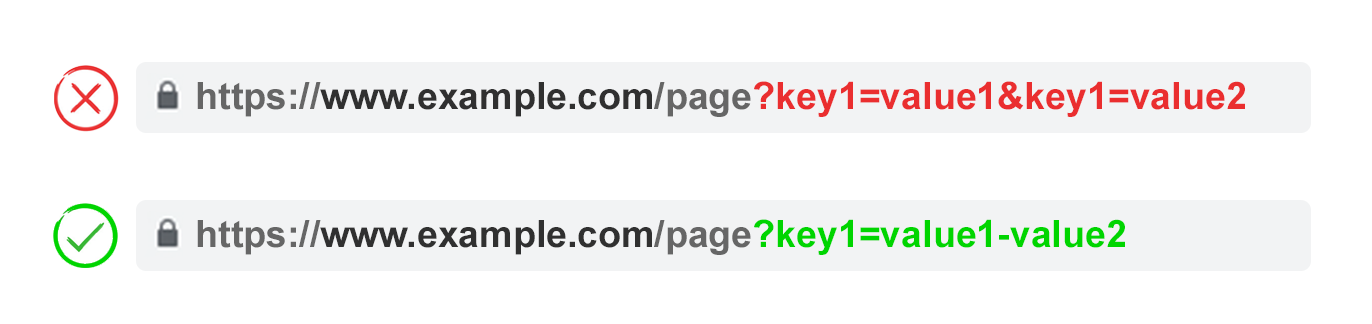

3. Используйте ключи только один раз

Избегайте применения нескольких параметров с одинаковым именем и разными значениями.

Для опций с множественным выбором лучше объединить значения после одного ключа.

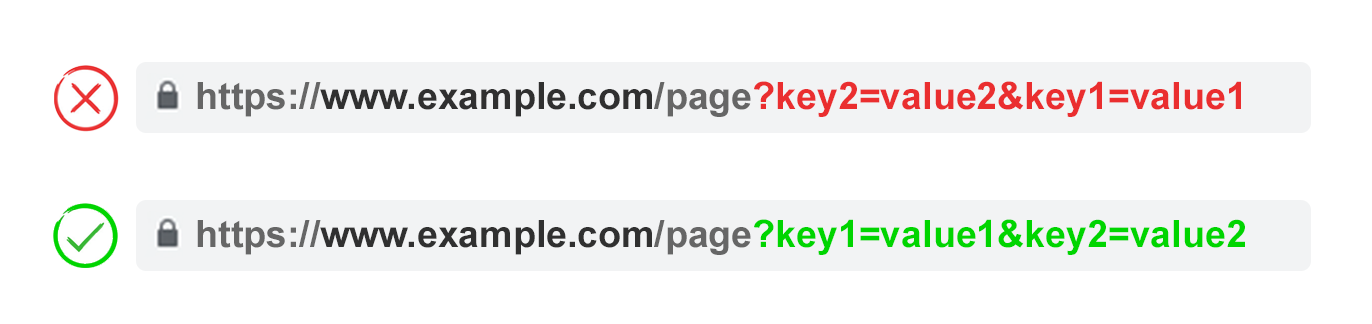

4. Параметры URL заказа

Если изменить порядок одного и того же параметра URL, страницы интерпретируются поисковыми системами как равные.

С точки зрения проблем с дублированием контента последовательность параметров не имеет значения. Однако изменение этих комбинаций может привести к расходованию краулингового бюджета и неравномерному распределению сигналов ранжирования.

Чтобы обеспечить согласованность, попросите своего разработчика создать сценарий, который упорядочивает параметры единообразно, независимо от последовательности, выбранной пользователем во время выбора.

С моей точки зрения, лучше всего начать с настройки параметров перевода, перейти к этапу идентификации, затем решить проблемы с нумерацией страниц и впоследствии применить фильтры и параметры сортировки/поиска. Наконец, следите за процессом.

Плюсы:

- Обеспечивает более эффективное сканирование.

- Уменьшает проблемы с дублированием контента.

- Объединяет сигналы ранжирования на меньшем количестве страниц.

- Подходит для всех типов параметров.

Минусы:

- Умеренное время технической реализации.

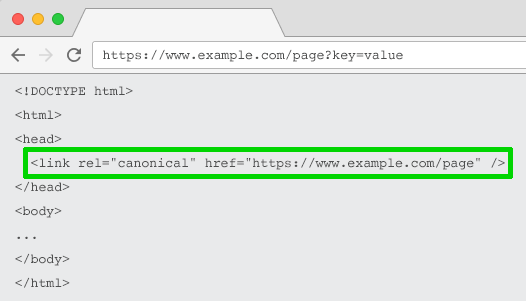

Атрибут ссылки Rel=”Канонический”

Как опытный веб-мастер, я хотел бы поделиться некоторыми мыслями об атрибуте ссылки «rel=canonical». Проще говоря, этот тег указывает, что определенная страница имеет такое же или очень похожее содержимое с другой в Интернете. Тем самым он тонко намекает поисковым системам объединить сигналы ранжирования обеих страниц в URL-адрес, указанный как канонический. Это оптимизирует усилия по SEO и улучшает общую видимость выбранного URL-адреса в результатах поиска.

Чтобы оптимизировать ваши URL-адреса для поисковых систем (SEO), вы можете рассмотреть возможность установки канонической ссылки (rel=»canonical») на URL-адресах на основе параметров, которые указывают на ваш более удобный и управляемый URL-адрес. Это может быть полезно для таких задач, как отслеживание, идентификация или изменение параметров.

Как эксперт по SEO, я всегда гарантирую, что тактика применяется продуманно. Например, когда содержимое страницы параметров значительно отличается от канонической страницы — например, в случае нумерации страниц, результатов поиска, перевода или определенных параметров фильтрации — крайне важно соответствующим образом скорректировать мои стратегии, поскольку эти страницы могут не использовать одинаковый SEO. преимущества, как и их коллеги.

Плюсы:

- Сравнительно простая техническая реализация.

- Скорее всего, для защиты от проблем с дублированием контента.

- Объединяет сигналы ранжирования с каноническим URL-адресом.

Минусы:

- Бесполезное сканирование страниц параметров.

- Подходит не для всех типов параметров.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

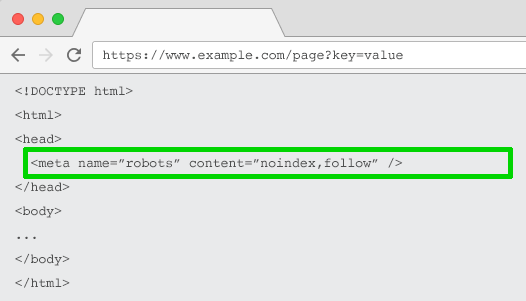

Мета-роботы Noindex-тег

Как специалист по цифровому маркетингу, я рекомендую добавить директиву noindex к любой веб-странице, которая не имеет SEO-ценности и основана на параметрах. Внедрив этот тег, мы можем запретить поисковым системам включать эти бесполезные страницы в результаты поиска, тем самым улучшая общую оптимизацию сайта.

Веб-сайты с URL-адресами, содержащими тег «noindex», могут нечасто сканироваться поисковыми системами, такими как Google, и, если их оставить неизменными в течение длительного периода, ссылки на эти страницы могут стать игнорируемыми или иметь статус «nofollow».

Плюсы:

- Сравнительно простая техническая реализация.

- Скорее всего, для защиты от проблем с дублированием контента.

- Подходит для всех типов параметров, индексация которых не требуется.

- Удаляет существующие URL-адреса на основе параметров из индекса.

Минусы:

- Это не помешает поисковым системам сканировать URL-адреса, но будет стимулировать их делать это реже.

- Не консолидирует сигналы ранжирования.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

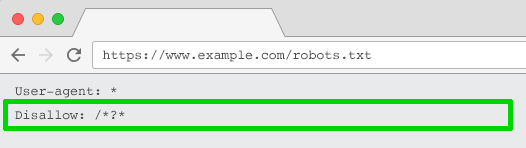

Robots.txt Запретить

Проще говоря, файл robots.txt служит руководством для поисковых систем при посещении вашего сайта. Он определяет области, которые не следует искать или индексировать. Если поисковая система обнаружит в этом файле что-то запрещенное, она вообще пропустит эти отдельные разделы.

У вас есть возможность применить этот файл для ограничения доступа веб-сканеров ко всем URL-адресам на основе параметров с помощью команды «Disallow: /*?» или, альтернативно, ограничить доступ только к определенным строкам запроса, которые не должны включаться в результаты поиска.

Плюсы:

- Простая техническая реализация.

- Позволяет более эффективно сканировать.

- Избегает проблем с дублированием контента.

- Подходит для всех типов параметров, сканирование которых не требуется.

Минусы:

- Не консолидирует сигналы ранжирования.

- Не удаляет существующие URL-адреса из индекса.

Переход от динамических к статическим URL-адресам

Распространено мнение, что лучше по возможности избегать использования параметров URL-адреса для более упрощенного подхода.

Как специалист по цифровому маркетингу, я обнаружил, что организация контента по подпапкам, а не только на параметрах, помогает Google более эффективно понимать структуру наших веб-сайтов. Последовательное использование статических, удобных для ключевых слов URL-адресов уже давно является решающим аспектом моей стратегии SEO на странице.

Для этого вы можете использовать перезапись URL-адресов на стороне сервера для преобразования параметров в URL-адреса подпапок.

Например, URL-адрес:

www.example.com/view-product?id=482794

Стало бы:

www.example.com/widgets/purple

Этот метод эффективно работает для описательных параметров, ориентированных на ключевые слова, например тех, которые используются для категоризации элементов, продуктов или поисковых фильтров по характеристикам, релевантным для поисковых систем. Кроме того, это оказывается полезным для переведенного контента.

Однако проблемы возникают, когда дело доходит до аспектов фасетной навигации, не связанных с ключевыми словами, например, фиксированной цены. Поскольку такие фильтры постоянно встроены в URL-адреса для индексации, они не способствуют поисковой оптимизации (SEO).

Это также проблема с параметрами поиска, поскольку каждый пользовательский запрос будет создавать статическую страницу, которая конкурирует за рейтинг с канонической или, что еще хуже, представляет сканерам страницы с контентом низкого качества всякий раз, когда пользователь ищет элемент, который вы не предлагаете. .

Довольно необычно, хотя и не совсем неожиданно, учитывая использование WordPress, что такая структура используется для нумерации страниц, в результате чего получается такой URL-адрес.

www.example.com/widgets/purple/page2

Очень странно для переупорядочения, которое дает URL-адрес, например

www.example.com/widgets/purple/lowest-price

Статический параметр UTM обычно не распознается Google Analytics, что делает его непригодным методом для отслеживания.

С моей точки зрения как специалиста по SEO, простая замена динамических параметров статическими URL-адресами для таких элементов, как нумерация страниц, внутренний поиск по сайту или функции сортировки, не решает автоматически проблемы, связанные с дублированием контента, управлением бюджетом сканирования или уменьшением эффективности внутренних ссылок. .

Создавая все возможные комбинации фильтров из вашей фасетной навигации в виде индивидуально индексируемых URL-адресов, вы часто можете столкнуться с проблемами недостаточного контента. Это особенно актуально при работе с фильтрами с несколькими выборками.

Некоторые эксперты в области поисковой оптимизации считают, что вы можете обеспечить единообразный пользовательский опыт, избегая при этом проблем, связанных с SEO, используя такие методы, как использование POST вместо запросов GET для изменения содержимого страницы. Таким образом, пользовательский опыт остается неизменным и можно избежать потенциальных сложностей с SEO.

Удаление подобных параметров будет означать, что люди не смогут сохранять или делиться ссылкой на определенную страницу, что нецелесообразно для сохранения закладок или обмена контентом. Кроме того, это затрудняет отслеживание параметров и не идеально подходит для реализации нумерации страниц.

По сути, оптимизация многочисленных веб-сайтов для оптимального взаимодействия с пользователем и хорошей поисковой оптимизации часто требует стратегического использования параметров, поскольку полное их исключение может оказаться невозможным или нецелесообразным.

Вот более простой способ выразить это:

Плюсы:

- Смещает фокус сканера с основанных на параметрах на статические URL-адреса, которые имеют более высокую вероятность ранжирования.

Минусы:

- Значительные затраты времени на перезапись URL-адресов и 301-редирект.

- Не предотвращает проблемы с дублированием контента.

- Не консолидирует сигналы ранжирования.

- Подходит не для всех типов параметров.

- Может привести к проблемам с тонким контентом.

- Не всегда предоставляет URL-адрес, на который можно ссылаться или добавлять в закладки.

Лучшие практики обработки параметров URL-адресов для SEO

Итак, какую из этих шести тактик SEO вам следует реализовать?

Ответ не может быть всем.

С точки зрения цифрового маркетинга, я бы выразил это так: по моему опыту, одновременная реализация нескольких стратегий SEO может привести к нежелательной сложности и, к сожалению, эти стратегии могут даже конфликтовать друг с другом, нанося потенциальный вред, а не пользу в целом. усилия по оптимизации.

Проще говоря, использование директивы robots.txt disallow означает, что Google не будет получать доступ ни к каким тегам «meta noindex» на веб-странице. Лучше избегать одновременного использования тега «meta noindex» и атрибута ссылки «rel=canonical».

В подкасте «Search Off The Record» эксперты Джон Мюллер, Гэри Илиес и Лиззи Сассман столкнулись с разногласиями по поводу лучшего метода решения проблем, связанных с параметрами при сканировании веб-страниц.

Они даже предлагают вернуть инструмент обработки параметров в консоль поиска Google. Гугл, если ты это читаешь, пожалуйста, верни это обратно!

Очевидно, что единого идеального решения не существует. В некоторых случаях приоритет эффективности сканирования над консолидацией авторитетных сигналов может быть более полезным.

В конечном счете, то, что подходит для вашего веб-сайта, будет зависеть от ваших приоритетов.

Лично я придерживаюсь следующего плана атаки для оптимизированной для SEO обработки параметров:

- Изучите намерения пользователей, чтобы понять, какие параметры должны быть статическими URL-адресами, удобными для поисковых систем.

- Реализуйте эффективную обработку нумерации страниц с помощью параметра ?page=.

- Для всех остальных URL-адресов на основе параметров заблокируйте сканирование с помощью запрета в файле robots.txt и добавьте тег noindex в качестве резервного.

- Дважды проверьте, что в XML-карте сайта не представлены URL-адреса на основе параметров.

Независимо от того, какой подход к управлению параметрами вы выберете для реализации, всегда записывайте влияние своей работы на ключевые показатели эффективности (KPI).

Смотрите также

- Акции EUTR. ЕвроТранс: прогноз акций.

- 11 лучших бесплатных и платных курсов по цифровому маркетингу (2024 г.)

- Падение ETH приближается?!

- Панель знаний в стиле карточек Google Tests. Дизайн рабочего стола.

- Какой самый низкий курс евро к филиппинскому песо?

- WP Engine против Automattic: судья склонен вынести предварительный судебный запрет

- Google: #1 Запуски Google Ads в 2025 году

- Обновление ядра Google за декабрь 2024 г. уже доступно — что мы видим

- Google сотрудничает с AP для получения данных в реальном времени

- Акции ROLO. Русолово: прогноз акций.

2024-09-13 12:09