После многих лет борьбы со сложностями обработки параметров URL-адресов для SEO я пришел к выводу, что найти идеальное решение так же неуловимо, как найти Святой Грааль. Постоянно развивающаяся среда поисковых систем и поведения пользователей усложнила разработку универсального подхода.

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)В мире SEO параметры URL представляют собой серьезную проблему.

Эти строки запроса могут быть полезны как разработчикам, так и аналитикам данных; однако они представляют собой серьезную проблему, когда дело доходит до поисковой оптимизации (SEO).

Бесчисленные комбинации параметров могут разделить одно намерение пользователя на тысячи вариантов URL-адресов. Это может вызвать осложнения при сканировании, индексировании, видимости и, в конечном итоге, привести к снижению трафика.

Как эксперт по SEO, я понимаю, что игнорировать проблемы с параметрами URL-адресов невозможно; вместо этого мы должны сосредоточиться на совершенствовании искусства эффективного управления этими параметрами с точки зрения SEO.

Что такое параметры URL?

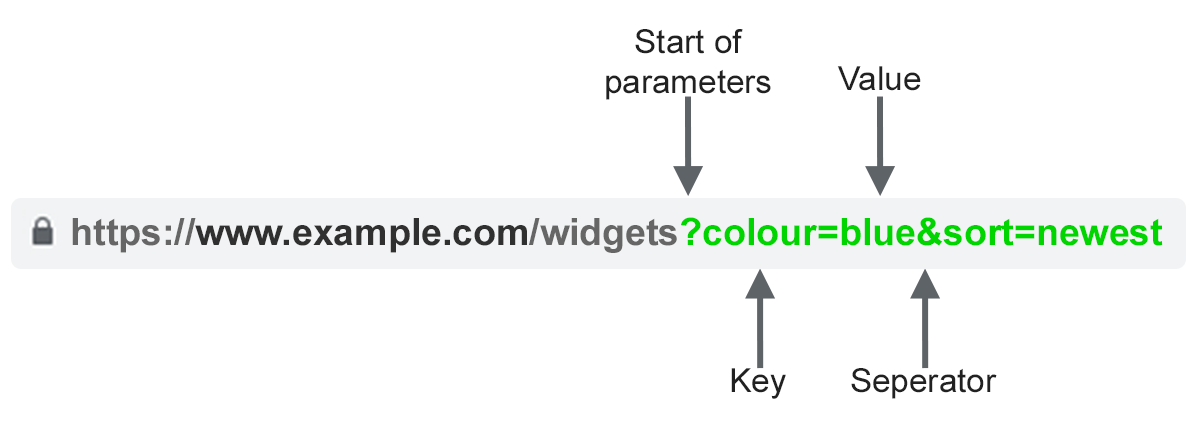

Параметры URL, часто называемые строками запроса или переменными URI, являются частью веб-адреса, которая идет после знака «?». символ. Они состоят из комбинации имени и значения, где имя и значение разделяются знаком равенства («=»). На одну страницу можно включить несколько наборов этих пар, если они разделены амперсандом («&»).

Наиболее распространенные случаи использования параметров:

- Отслеживание Например ?utm_medium=social, ?sessionid=123 или ?affiliateid=abc.

- Изменение порядка. Например, ?sort=lowest-price, ?order=highest-rated или ?so=latest.

- Фильтрация – например ?type=widget, color=purple или ?price-range=20-50.

- Идентификация – Например ?product=small-purple-widget, Categoryid=124 или itemid=24AU.

- Разбиение на страницы – например, ?page=2, ?p=2 или viewItems=10-30.

- Поиск – например, ?query=users-query, ?q=users-query или ?search=drop-down-option.

- Перевод – например, ?lang=fr или ?language=de.

Проблемы SEO с параметрами URL

1. Параметры создают дублирующийся контент

Зачастую параметры URL не вносят существенных изменений в содержимое страницы.

Как опытный веб-мастер, я хотел бы подчеркнуть, что иногда измененная веб-страница может не сильно отличаться от своей первоначальной версии. Когда дело доходит до URL-адреса страницы, включающего теги отслеживания или идентификатор сеанса, вы обнаружите, что он по сути тот же, что и оригинал.

Например, все следующие URL-адреса будут возвращать коллекцию виджетов.

- Статический URL: https://www.example.com/widgets

- Параметр отслеживанияr: https://www.example.com/widgets?sessionID=32764

- Параметр изменения порядка: https://www.example.com/widgets?sort=latest

- Идентифицирующий параметр: https://www.example.com?category=widgets

- Параметр поиска: https://www.example.com/products?search=widget

Интересно отметить, что существует множество URL-адресов, ведущих к практически идентичному контенту — если вы умножите их на все категории на своем веб-сайте, их может накопиться довольно много.

Один из способов перефразировать это простым, разговорным языком: поисковые системы воспринимают каждый URL-адрес с параметрами как уникальную страницу. Это означает, что они просматривают несколько версий одной и той же веб-страницы, каждая из которых содержит повторяющуюся информацию и все нацелены на один и тот же поисковый запрос или тему.

Дублирование контента на вашем веб-сайте может не привести к его полному удалению из результатов поиска, но может привести к каннибализации ключевых слов. Это означает, что вместо повышения видимости определенных страниц это потенциально может снизить общее впечатление Google о качестве вашего сайта, поскольку эти дополнительные URL-адреса не несут существенной дополнительной ценности.

2. Параметры снижают эффективность сканирования

Переполнение вашего веб-сайта ненужными страницами, повторяющими одну и ту же информацию, может сбить с толку поисковых ботов Google (Googlebots), что усложнит им поиск ключевых SEO-страниц и потенциально перегрузит ваш сервер.

Google прекрасно резюмирует этот момент.

Упрощение структуры URL-адресов с использованием слишком большого количества параметров может привести к осложнениям для веб-сканеров, поскольку они могут создавать чрезмерное количество ссылок, указывающих на один и тот же или очень похожий контент на вашем веб-сайте, что ненужно и потенциально проблематично.

В моей работе в качестве интернет-маркетолога важно понимать, что робот Googlebot, веб-сканер Google, может непреднамеренно использовать чрезмерную пропускную способность или, что еще хуже, не суметь тщательно проиндексировать все содержимое вашего сайта. Это может быть связано с различными факторами, такими как плохая структура сайта, тяжелые медиафайлы или сложный JavaScript. Крайне важно оптимизировать наши веб-сайты для этих ботов, чтобы они могли эффективно сканировать и индексировать наш контент.

3. Сигналы ранжирования страницы по параметрам

Как специалист по цифровому маркетингу, я часто сталкиваюсь с ситуациями, когда контент одной страницы представлен в нескольких различных формах, что приводит к тому, что ссылки и социальные сети появляются в разных версиях.

Поступая так, вы ослабляете силу факторов ранжирования. Другими словами, когда сканер поисковой системы не знает, какую веб-страницу следует выбрать для определенного поискового запроса, это может привести к неопределенности в определении того, какая страница должна быть проиндексирована.

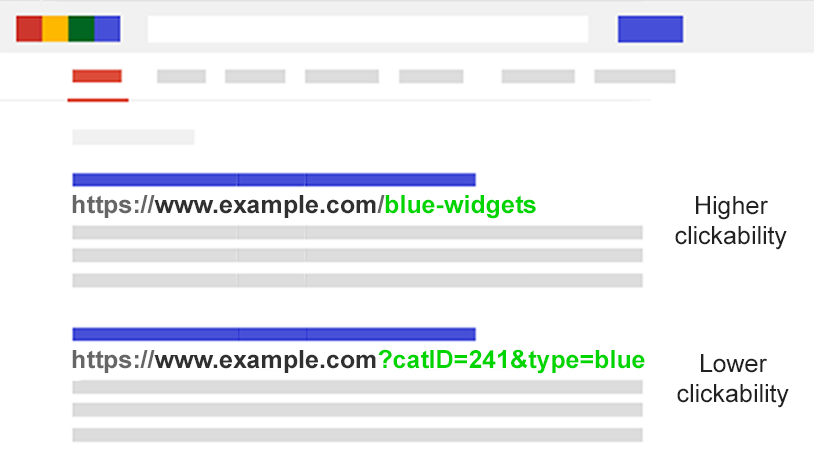

4. Параметры делают URL-адреса менее кликабельными

Совершенно очевидно: URL-адреса с параметрами могут быть неприятны для глаз. Их нелегко понять, и отсутствие ясности может сделать их менее надежными. Следовательно, они могут получить меньше кликов.

Это потенциально может повлиять на скорость страницы. Более того, рейтинг кликов (CTR) играет важную роль в рейтинге поисковых систем, но также с меньшей вероятностью на него будут нажимать чат-боты с искусственным интеллектом, платформы социальных сетей, ветки электронной почты, онлайн-форумы или любое другое место, где указан полный URL-адрес. видно.

Каждый твит, например, публикация, электронное письмо, связанный ресурс или упоминание, может существенно повлиять на повышение видимости страницы вашего веб-сайта, даже если эффект будет незначительным только на одной странице.

Плохая читаемость URL-адресов может способствовать снижению вовлеченности бренда.

Оцените масштабы проблемы с параметрами

Крайне важно знать все настройки, используемые на вашем сайте, но вполне вероятно, что ваша команда разработчиков не ведет их текущий учет.

Как мы можем выявить все факторы, требующие внимания? И поймете, как поисковые системы сканируют, ранжируют и сохраняют такие веб-страницы? Определить их ценность для пользователей?

Выполните следующие пять шагов:

- Запустите сканер. С помощью такого инструмента, как Screaming Frog, вы можете выполнить поиск по запросу «?» в URL-адресе.

- Просмотрите файлы журналов: проверьте, сканирует ли робот Googlebot URL-адреса на основе параметров.

- Посмотрите в отчете об индексировании страницы Google Search Console: в образцах индекса и соответствующих неиндексируемых исключениях найдите «?» в URL-адресе.

- Поиск с помощью site: inurl: расширенные операторы. Узнайте, как Google индексирует найденные вами параметры, вставив ключ в запрос с комбинацией ключей site:example.com inurl:key.

- Посмотрите в отчете Google Analytics по всем страницам: найдите «?» чтобы увидеть, как каждый из найденных вами параметров используется пользователями. Обязательно проверьте, что параметры URL-запроса не были исключены в настройках представления.

Вооружившись этими данными, вы теперь можете решить, как лучше всего обрабатывать каждый из параметров вашего веб-сайта.

SEO-решения для управления параметрами URL-адресов

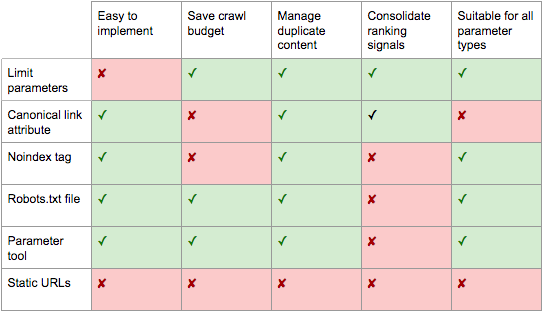

В вашем арсенале SEO есть шесть инструментов для работы с параметрами URL-адресов на стратегическом уровне.

Ограничить URL-адреса на основе параметров

Простой обзор того, как и почему генерируются параметры, может обеспечить быстрый выигрыш в SEO.

Вы часто будете находить способы уменьшить количество параметров, используемых в URL-адресах, тем самым уменьшая их вредное влияние на SEO. Вот четыре распространенные проблемы, которые вы, возможно, захотите решить в первую очередь, когда начнете оценку.

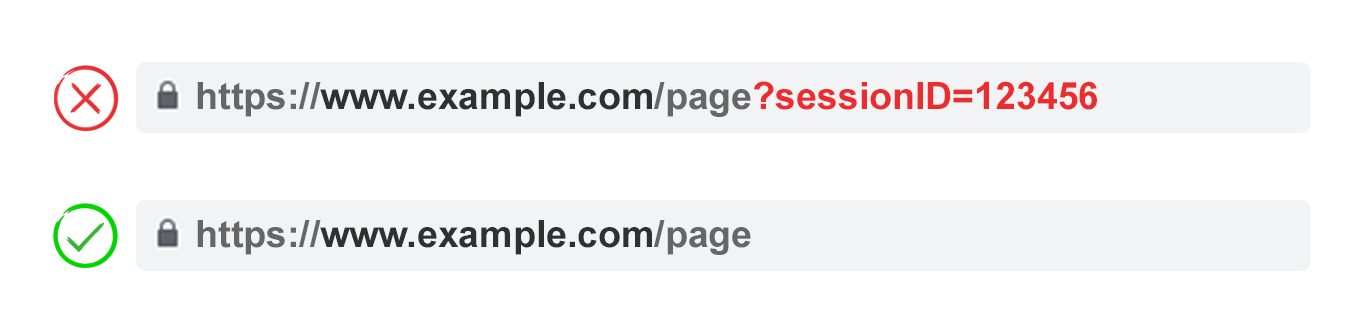

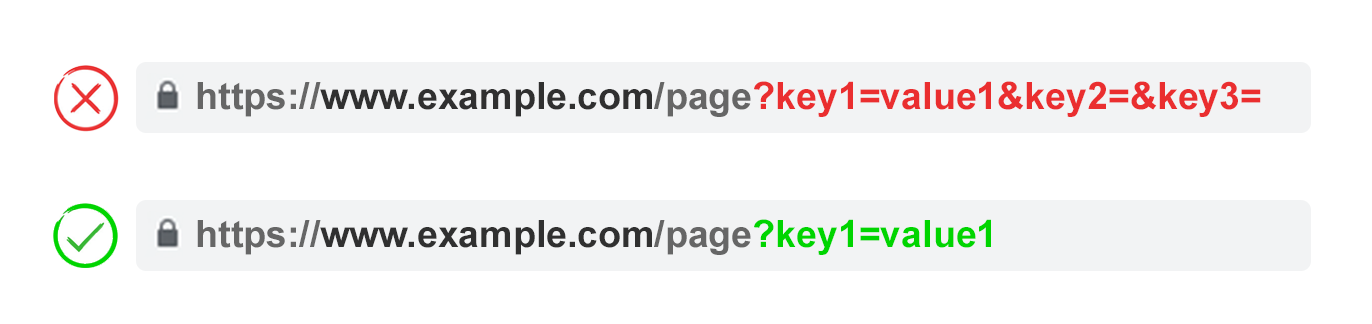

1. Устраните ненужные параметры

Не могли бы вы попросить своего разработчика предоставить подробную информацию обо всех настройках и их ролях на каждом нашем веб-сайте? Вполне вероятно, что некоторые настройки больше не являются необходимыми или полезными для наших целей.

Например, пользователей лучше идентифицировать по файлам cookie, чем по идентификаторам сеансов. Тем не менее, параметр sessionID все еще может существовать на вашем веб-сайте, поскольку он использовался исторически.

Или вы можете обнаружить, что пользователи редко применяют фильтры в вашей фасетной навигации.

Любые параметры, вызванные техническим долгом, должны быть немедленно устранены.

2. Не допускайте пустых значений

Параметры URL-адреса следует включать в URL-адрес только тогда, когда они служат определенной цели, и важно не добавлять ключи параметров, если их значения пусты или равны нулю.

В приведенном выше примере ключ2 и ключ3 не добавляют значения ни в прямом, ни в переносном смысле.

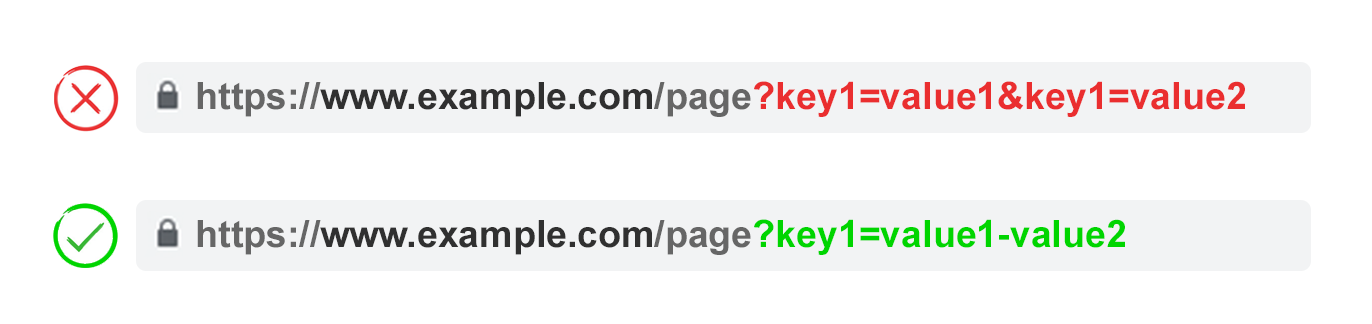

3. Используйте ключи только один раз

Избегайте применения нескольких параметров с одинаковым именем и разными значениями.

Для опций с множественным выбором лучше объединить значения после одного ключа.

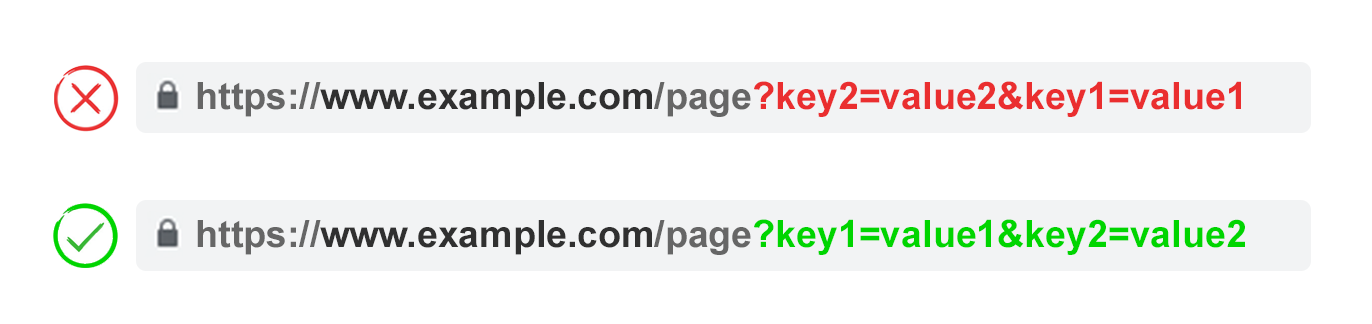

4. Параметры URL заказа

Если изменить порядок одного и того же параметра URL, страницы интерпретируются поисковыми системами как равные.

С точки зрения дублированного контента расположение параметров не имеет значения. Однако каждая уникальная комбинация потребляет краулинговый бюджет и рассеивает сигналы ранжирования.

Обеспечьте согласованность во всех сценариях использования, поручив своему программисту создать сценарий, который упорядочивает параметры единообразно, независимо от того, как пользователь выбирает их.

С моей точки зрения, лучше всего начать процесс, используя некоторые настройки перевода, перейти к распознаванию контента, затем заняться разделением страниц, затем добавить параметры фильтрации и сортировки и, наконец, следить за его ходом — либо путем поиска, либо путем отслеживания.

Плюсы:

- Обеспечивает более эффективное сканирование.

- Уменьшает проблемы с дублированием контента.

- Объединяет сигналы ранжирования на меньшем количестве страниц.

- Подходит для всех типов параметров.

Минусы:

- Умеренное время технической реализации.

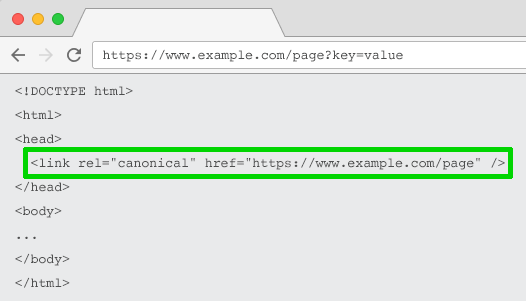

Атрибут ссылки Rel=”Канонический”

Используя атрибут ссылки «rel=canonical», вы сигнализируете о том, что веб-страница имеет одинаковый или очень похожий контент с другой. Это помогает поисковым системам объединить сигналы ранжирования в URL-адрес, который вы обозначили как канонический.

Чтобы оптимизировать SEO, вы можете установить каноническую связь между вашими динамическими (на основе параметров) URL-адресами и предпочтительным URL-адресом, оптимизированным для SEO. Эта настройка полезна для таких задач, как отслеживание, идентификация или реорганизация параметров.

Однако эта стратегия не идеальна, когда контент на страницах параметров значительно отличается от канонического. Это может быть связано с нумерацией страниц, результатами поиска, переводом или различными параметрами фильтрации.

Плюсы:

- Сравнительно простая техническая реализация.

- Скорее всего, для защиты от проблем с дублированием контента.

- Объединяет сигналы ранжирования с каноническим URL-адресом.

Минусы:

- Бесполезное сканирование страниц параметров.

- Подходит не для всех типов параметров.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

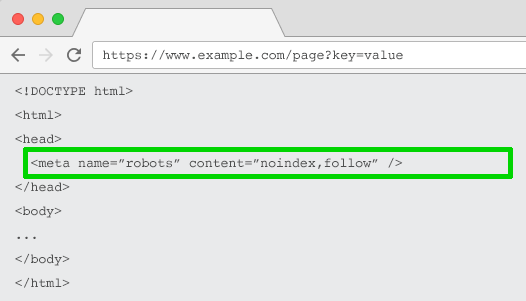

Мета-роботы Noindex-тег

Чтобы поисковые системы не отображали бесполезные страницы на основе параметров, вставьте инструкцию «noindex». Эта команда гарантирует, что страницы не появятся в результатах поиска и не будут проиндексированы поисковыми системами.

Веб-адреса (URL-адреса), помеченные как «noindex», часто реже сканируются поисковыми системами, такими как Google. В течение длительного времени это может привести к тому, что Google решит не переходить по ссылкам на этих страницах.

Плюсы:

- Сравнительно простая техническая реализация.

- Скорее всего, для защиты от проблем с дублированием контента.

- Подходит для всех типов параметров, индексация которых не требуется.

- Удаляет существующие URL-адреса на основе параметров из индекса.

Минусы:

- Это не помешает поисковым системам сканировать URL-адреса, но будет стимулировать их делать это реже.

- Не консолидирует сигналы ранжирования.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

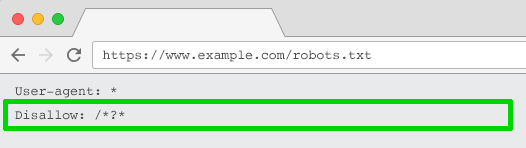

Robots.txt Запретить

Проще говоря, файл robots.txt служит руководством для поисковых систем при посещении вашего сайта. Он указывает, какие части вашего сайта следует избегать сканирования. Если раздел в этом файле помечен как запрещенный, поисковая система полностью его обойдет.

Вы можете использовать этот файл, чтобы заблокировать доступ сканера к каждому URL-адресу на основе параметров (с Disallow: /*?*) или только к определенным строкам запроса, которые вы не хотите индексировать.

Плюсы:

- Простая техническая реализация.

- Позволяет более эффективно сканировать.

- Избегает проблем с дублированием контента.

- Подходит для всех типов параметров, сканирование которых не требуется.

Минусы:

- Не консолидирует сигналы ранжирования.

- Не удаляет существующие URL-адреса из индекса.

Переход от динамических к статическим URL-адресам

Распространено мнение, что лучше свести к минимуму или даже исключить использование параметров URL-адресов для более упрощенного подхода.

По сути, подпапки более эффективны, чем параметры, когда речь идет о том, чтобы помочь Google понять макет веб-сайта, а хорошо структурированные URL-адреса, ориентированные на ключевые слова, неизменно играют ключевую роль в SEO на странице.

Для этого вы можете использовать перезапись URL-адресов на стороне сервера для преобразования параметров в URL-адреса подпапок.

Например, URL-адрес:

www.example.com/view-product?id=482794

Стало бы:

www.example.com/widgets/purple

Этот метод эффективно работает с описательными ключевыми словами, например теми, которые используются для категоризации элементов, продуктов или для фильтрации характеристик, соответствующих поисковым системам. Это также эффективно при работе с переведенным контентом.

Однако когда дело доходит до аспектов фасетной навигации, которые не связаны напрямую с ключевыми словами, например, конкретной цены, это может создать сложности. Включение таких фильтров в фиксированный URL-адрес, индексируемый поисковыми системами, практически не приносит никакой пользы для SEO (поисковая оптимизация).

Как эксперт по SEO, я часто сталкиваюсь с проблемой оптимизации параметров поиска: каждый пользовательский запрос потенциально может создавать статическую страницу, конкурирующую с исходной (канонической) страницей за более высокий рейтинг. В некоторых случаях это может даже привести к тому, что сканеры получат страницы с некачественным контентом, когда пользователи ищут элементы, не предлагаемые нами.

Несколько необычно, хотя и не совсем беспрецедентно (особенно для WordPress), что это приводит к такой структуре URL:

www.example.com/widgets/purple/page2

Очень странно для переупорядочения, которое дает URL-адрес, например

www.example.com/widgets/purple/lowest-price

В большинстве случаев стационарный (статический) параметр UTM не будет распознаваться Google Analytics как эффективный метод отслеживания.

Внесем ясность: изменение динамических параметров на фиксированные URL-адреса для таких функций, как нумерация страниц, результаты поиска по сайту и сортировка, не решает проблемы, связанные с дублированием контента, распределением ресурсов поисковыми системами (бюджет сканирования) или распределением ценности внутренних ссылок (внутренняя ссылка). капитал).

Использование всех возможных комбинаций фильтров фасетной навигации в качестве индивидуально доступных URL-адресов может привести к проблемам с тонким контентом, особенно если у вас есть несколько фильтров выбора. Это связано с тем, что один и тот же или похожий контент может отображаться на разных URL-адресах, что потенциально снижает их ценность и качество.

Некоторые эксперты по SEO считают, что вы можете обеспечить такое же высококачественное взаимодействие с пользователем, не меняя URL-адрес. Один из способов добиться этого — использовать запросы POST вместо запросов GET при изменении содержимого страницы. Этот метод обеспечивает единообразный пользовательский опыт, предотвращая при этом потенциальные проблемы с SEO.

Удаление таких параметров из URL-адреса не позволит пользователям добавлять в закладки или делиться ссылками на определенные страницы, что не идеально для сохранения или обмена контентом. Кроме того, это затрудняет отслеживание параметров и эффективное управление нумерацией страниц.

По сути, оптимизация многочисленных веб-сайтов с целью исключения всех параметров невозможна для обеспечения превосходного пользовательского опыта или соблюдения хороших практик SEO.

Другими словами, для таких элементов, как нумерация страниц, изменение порядка или отслеживание, которые вы не хотите отображать в результатах поиска, лучше всего включить их в строку запроса URL-адреса. С другой стороны, если вы хотите, чтобы определенные аспекты индексировались и отображались в результатах поиска, используйте вместо этого статические URL-пути.

Плюсы:

- Смещает фокус сканера с основанных на параметрах на статические URL-адреса, которые имеют более высокую вероятность ранжирования.

Минусы:

- Значительные затраты времени на перезапись URL-адресов и 301-редирект.

- Не предотвращает проблемы с дублированием контента.

- Не консолидирует сигналы ранжирования.

- Подходит не для всех типов параметров.

- Может привести к проблемам с тонким контентом.

- Не всегда предоставляет URL-адрес, на который можно ссылаться или добавлять в закладки.

Лучшие практики обработки параметров URL-адресов для SEO

Итак, какую из этих шести тактик SEO вам следует реализовать?

Ответ не может быть всем.

С точки зрения цифрового маркетинга, я бы избегал одновременной реализации нескольких стратегий SEO, поскольку они имеют тенденцию добавлять ненужную сложность и даже могут конфликтовать, что приводит к контрпродуктивным результатам.

Проще говоря, когда вы используете команду «robots.txt disallow», Google не получит доступ ни к каким тегам «meta noindex» на вашей веб-странице. Также не рекомендуется сочетать тег «meta noindex» с атрибутом ссылки «rel=canonical».

В подкасте Search Off The Record представители Google, в том числе Джон Мюллер, Гэри Илиес и Лиззи Сассман, оказались в тупике относительно лучшего метода решения проблем, которые создают параметры при сканировании веб-страниц.

Они даже предлагают вернуть инструмент обработки параметров в консоль поиска Google. Гугл, если ты это читаешь, пожалуйста, верни это обратно!

Очевидно, что единого идеального решения не существует. Иногда приоритет эффективности сканирования имеет приоритет над унификацией авторитетных сигналов.

В конечном счете, то, что подходит для вашего веб-сайта, будет зависеть от ваших приоритетов.

Лично я придерживаюсь следующего плана атаки для оптимизированной для SEO обработки параметров:

- Изучите намерения пользователей, чтобы понять, какие параметры должны быть статическими URL-адресами, удобными для поисковых систем.

- Реализуйте эффективную обработку нумерации страниц с помощью параметра ?page=.

- Для всех остальных URL-адресов на основе параметров заблокируйте сканирование с помощью запрета в файле robots.txt и добавьте тег noindex в качестве резервного.

- Дважды проверьте, что в XML-карте сайта не представлены URL-адреса на основе параметров.

Независимо от выбранного вами метода управления параметрами всегда отмечайте влияние вашего подхода на ключевые показатели эффективности (KPI).

Смотрите также

- Анализ динамики цен на криптовалюту WLD: прогнозы WLD

- Google запрещает добавлять страны или штаты к предприятиям в зоне обслуживания.

- Прогноз нефти

- Анализ динамики цен на криптовалюту FLR: прогнозы FLR

- Властная хватка Биткоина: Альткоины обречены или просто отдыхают? 🚀🤔

- Анализ динамики цен на криптовалюту SKY: прогнозы SKY

- Режим Google AI показывает разные источники для одного запроса

- Как подобрать идеальный бюджет на SEO и PPC

- Поиск Bing теперь показывает купоны в меню «Обзор»

- Монета Pi вызывает хаос при запуске, лишь мимолетная вспышка славы!

2024-09-23 00:09