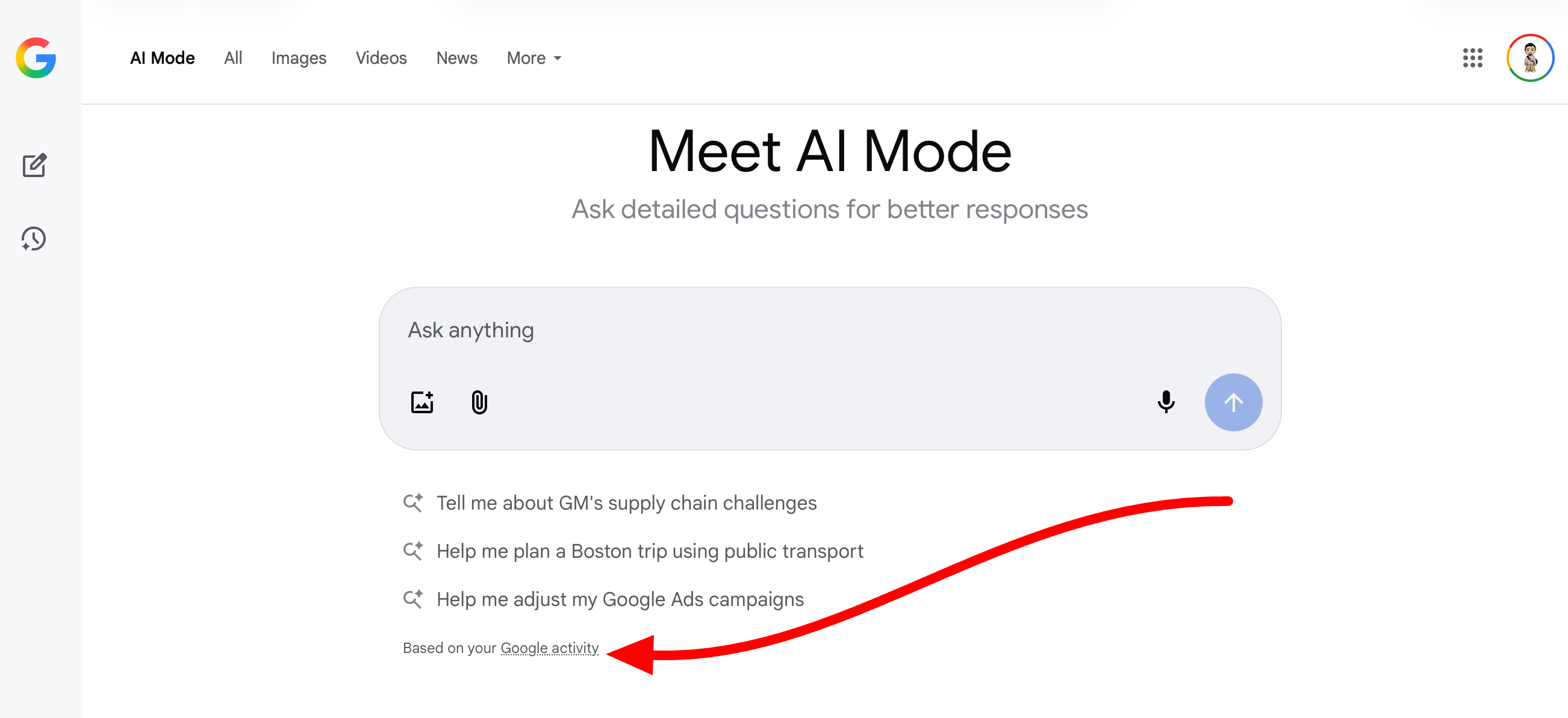

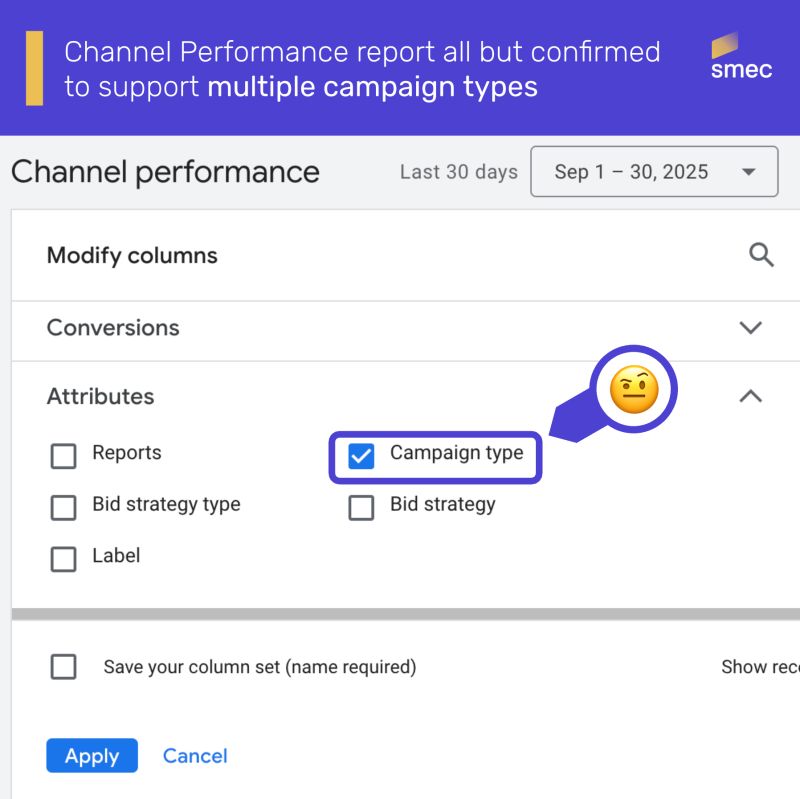

Некоторые пользователи Google Ads заметили появление новой опции ‘Тип кампании’ в отчёте об эффективности каналов. Google официально не объявлял об этом изменении, поэтому, похоже, оно постепенно внедряется для рекламодателей.

Недавно я наткнулся на кое-что интересное – Майк Райан указал на это в LinkedIn. Что действительно привлекло мое внимание, так это не крупное изменение, а новое дополнение в разделе Attributes – конкретно, поле ‘Campaign Type‘. Это показалось немного необычным и определенно заслуживающим внимания.

Вот скриншот с добавленными им эмодзи:

Майк сказал:

В течение нескольких недель в подсказке для этого отчета присутствует странная формулировка: ‘Данные об эффективности канала доступны только для кампаний Performance Max на данный момент.’

Использование фразы ‘at this time’ подразумевает, что система может в конечном итоге обрабатывать дополнительные типы кампаний. Теперь, когда ‘Campaign Type’ используется для категоризации данных, кажется весьма вероятным, что Channel Report вскоре будет включать данные из большего количества ваших кампаний – вероятно, сначала Demand Gen кампаний, но, возможно, и всех из них.

Майк думает, что это значит следующее в будущем:

- Данные партнера поиска будут добавлены в отчет о производительности канала

- Подтвержден доступ к API, он уже в пути

- Сегментация сети для PMax в отчете об группе ресурсов

Более тонкая фильтрация и сегментация – это хорошо!

Просто к сведению: эта публикация была подготовлена заранее и запланирована. Я сейчас отсутствую, праздную Симхат Тора.

Смотрите также

- Акции LIFE. Фармсинтез: прогноз акций.

- Анализ динамики цен на криптовалюту ONDO: прогнозы ONDO

- Серебро прогноз

- Золото прогноз

- Акции POSI. Positive Technologies: прогноз акций.

- Акции привилегированные MGTSP. МГТС: прогноз акций привилегированных.

- Какой самый низкий курс евро к доллару?

- Анализ динамики цен на криптовалюту VET: прогнозы VET

- Прогноз нефти

- Meta продвигает интеграцию GA4 и может похвастаться повышением конверсии на 22 %

2025-10-15 16:14