На протяжении многих лет, SEO-специалисты работали над тем, чтобы понять, как работает поиск Google. Теперь они сталкиваются с новой и еще более сложной проблемой: заставить системы искусственного интеллекта распознавать и цитировать их контент.

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)Понимание того, как ИИ использует информацию для создания ответов, может показаться сложным, даже более сложным, чем традиционная поисковая оптимизация. Однако есть и положительная сторона: системы ИИ на самом деле дают подсказки о типах контента, который они считают наиболее полезным, если вы знаете, где искать.

Эта статья покажет вам, как узнать, какой контент предпочитают инструменты искусственного интеллекта, и предоставит план по улучшению вашего веб-сайта, чтобы эти инструменты с большей вероятностью использовали его в качестве источника.

Применяйте систематический подход к оптимизации AI-движка.

Чтобы улучшить отображение вашего веб-сайта в результатах поиска на основе искусственного интеллекта, крайне важно сначала понять, как ИИ-боты исследуют ваш сайт. Изучая их поведение, вы можете определить, какой тип контента они приоритезируют, и использовать эту информацию для стратегического улучшения производительности вашего веб-сайта.

Это создает как возможность, так и трудность. Хорошая новость заключается в том, что вы можете сделать свой контент более доступным для обнаружения и использования системами ИИ. Трудность заключается в том, чтобы понять, как улучшить его для этих новых алгоритмов ИИ, которые работают не так, как обычные поисковые системы.

Ответ — это систематический подход.

- Узнайте, какой контент ценят AI-движки, основываясь на поведении их краулеров.

- Традиционный анализ лог-файлов.

- SEO Bulk Admin AI Crawler мониторинг.

- Обратная разработка промптов.

- Анализ контента.

- Технический анализ.

- Создание чертежа.

Что такое AI-краулеры и как использовать их в своих интересах

AI-боты — это автоматизированные программы, используемые компаниями, разрабатывающими искусственный интеллект. Они систематически исследуют интернет и собирают информацию с веб-сайтов. В отличие от типичных ботов поисковых систем, которые уделяют приоритетное внимание ранжированию веб-сайтов, AI-боты собирают контент специально для обучения систем искусственного интеллекта и расширения их знаний.

Основные AI-краулеры включают:

- GPTBot (ChatGPT от OpenAI).

- PerplexityBot (Perplexity AI).

- ClaudeBot (Claude от Anthropic).

- Поисковые роботы Googlebot (Google AI).

Эти краулеры влияют на вашу контент-стратегию двумя критически важными способами:

- Сбор обучающих данных.

- Получение информации в реальном времени.

Сбор обучающих данных

Модели искусственного интеллекта обучаются на огромном количестве информации из сети. Веб-сайты, которые часто посещают поисковые системы, с большей вероятностью будут включены в данные, используемые для обучения этих моделей, что означает, что у ИИ будет больше шансов использовать ваш контент при генерации ответов.

Извлечение информации в реальном времени

Некоторые AI-программы постоянно сканируют интернет, чтобы предоставить вам актуальную информацию. Из-за этого новый контент, появляющийся на веб-сайтах, может немедленно повлиять на ответы, которые предоставляют эти AI-системы.

Зная, какие страницы боты ИИ посещают чаще всего, вы можете понять, какой тип контента они считают важным. Эта информация является ключевой для улучшения вашего общего контент-плана.

Как отслеживать активность AI-краулера: поиск и использование анализа лог-файлов.

Простой Способ: Мы используем SEO Bulk Admin для анализа файлов журналов сервера за нас.

Однако, есть и ручной способ это сделать.

Проверка журналов вашего сервера по-прежнему является лучшим способом увидеть, как веб-краулеры – включая те, которые работают на основе ИИ – взаимодействуют с вашим веб-сайтом. Эти журналы предоставляют полную запись каждого посещения ботом, предлагая информацию, которую вы не получите из типичной веб-аналитики, которая в основном отслеживает человеческих посетителей.

Необходимые инструменты для анализа файлов журналов.

Несколько инструментов корпоративного уровня могут помочь вам разбирать и анализировать файлы журналов:

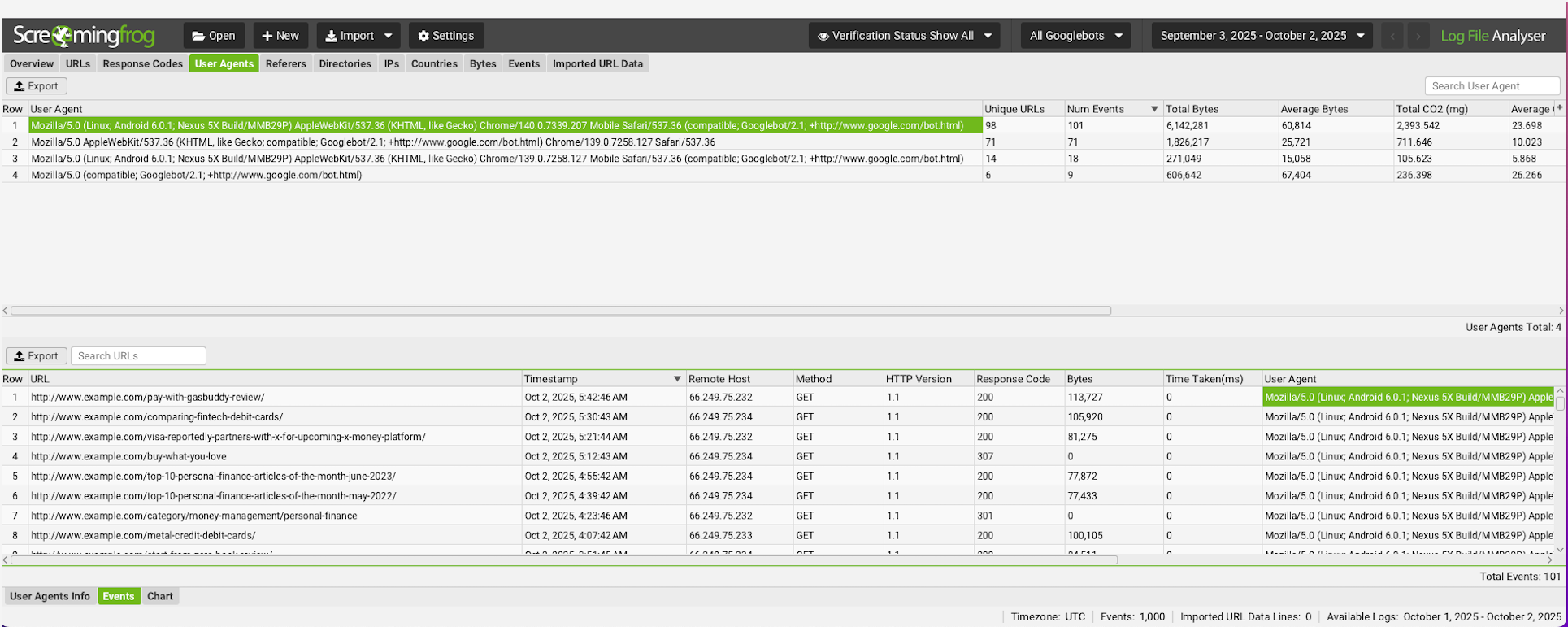

- Screaming Frog Log File Analyser: Отлично подходит для технических SEO-специалистов, комфортно работающих с манипуляциями данными.

- Botify: Корпоративное решение с мощными функциями анализа краулера.

- Semrush: Предлагает анализ лог-файлов в рамках своего более широкого SEO-набора.

Сложность анализа файлов журналов

Чтобы получить наиболее подробную информацию о бот-трафике на ваш веб-сайт – включая то, какие боты его посещают, какие страницы они просматривают и как часто – вам необходимо анализировать файлы журналов вашего сервера.

Ваш веб-сайт автоматически ведёт учёт каждого посещения, даже от автоматизированных программ, таких как AI-боты. Вы можете просмотреть эти записи, чтобы узнать, какие боты посещают ваш сайт, идентифицируя их конкретную информацию ‘user-agent’.

Вот как вы можете к этому подойти:

- Получите доступ к логам вашего сервера: Обычно они находятся в панели управления хостингом или непосредственно на вашем сервере через SSH/FTP (например, логи доступа Apache, логи доступа Nginx).

- Определите User-Agents ИИ: Вам нужно будет знать конкретные строки user-agent, используемые AI-краулерами. Хотя они могут меняться, распространенные из них включают:

- OpenAI (например, для ChatGPT, `ChatGPT-User` или вариации)

- Perplexity AI (например, `PerplexityBot`)

- Anthropic (для Claude, хотя часто менее различим или может использовать общие пользовательские агенты облачных провайдеров)

- Другие боты, связанные с LLM (например, «GoogleBot» и `Google-Extended` для инициатив Google в области ИИ, потенциально `Vercelbot` или другие боты облачной инфраструктуры, которые LLM могут использовать для получения данных).

- Разбор и Анализ: Здесь в игру вступают инструменты анализа логов, о которых говорилось ранее. Загрузите свои необработанные файлы журналов в анализатор и начните фильтрацию результатов для выявления активности AI-краулеров и поисковых ботов. В качестве альтернативы, для тех, кто обладает техническими знаниями, можно настроить скрипты Python или инструменты, такие как Splunk или Elasticsearch, для разбора журналов, идентификации конкретных user-agents и визуализации данных.

Хотя изучение файлов журналов предлагает наиболее подробную информацию, это может быть довольно сложной задачей для многих SEO-специалистов.

- Техническая глубина: Требуется доступ к серверу, понимание форматов журналов и навыки парсинга данных.

- Затраты времени: Настройка правильных аналитических рабочих процессов требует значительных первоначальных усилий.

- Проблемы анализа: Различение между различными AI-краулерами требует детального знания user-agent.

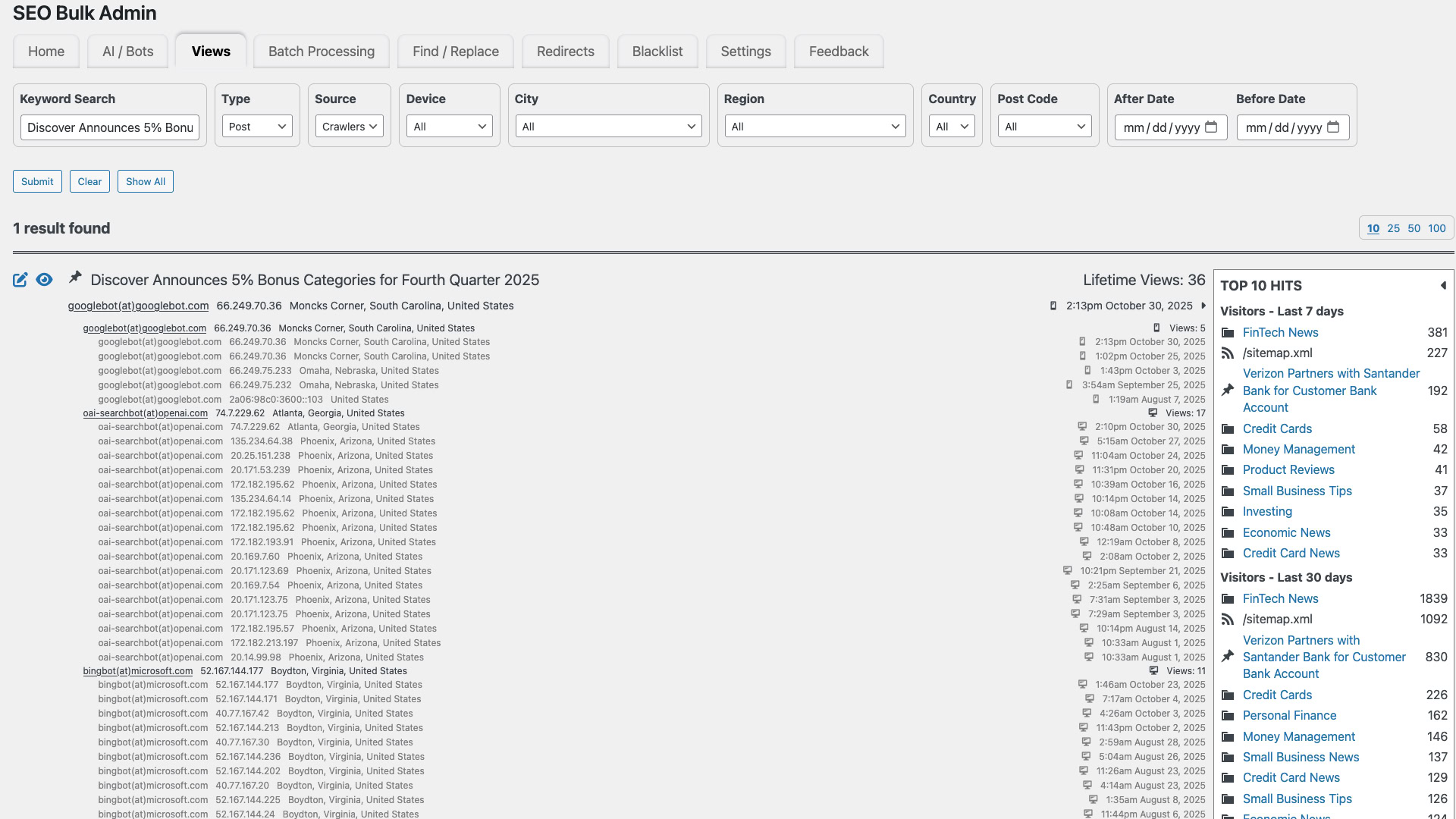

Более простой способ отслеживания посещений ИИ: SEO Bulk Admin

Просмотр лог-файлов может предоставить вам очень конкретную информацию, но это часто сложно и трудно для тех, кто не является техническим экспертом. К счастью, такие инструменты, как SEO Bulk Admin, могут значительно упростить задачу.

Плагин WordPress SEO Bulk Admin легко отслеживает и сообщает, как AI-боты сканируют ваш веб-сайт, без необходимости доступа к серверным журналам или сложным конфигурациям. Вот что он предлагает:

- Автоматическое Обнаружение: Распознает основных AI-краулеров, включая GPTBot, PerplexityBot и ClaudeBot, без ручной настройки.

- Удобная панель управления: Представляет данные краулера в интуитивно понятном интерфейсе, доступном SEO-специалистам любого технического уровня.

- Мониторинг в реальном времени: Отслеживает посещения AI-ботами по мере их возникновения, предоставляя немедленную информацию о поведении краулера.

- Анализ на уровне страницы: Показывает, какие конкретные страницы чаще всего посещают AI-краулеры, что позволяет проводить целенаправленную оптимизацию.

Как веб-мастер, ориентированный на SEO, я действительно рад этому, потому что это мгновенно показывает мне, какие именно страницы посещают AI-боты. Раньше выяснение этого означало копание в сложных логах сервера или создание пользовательских скриптов – теперь это просто и немедленно.

Сравнение SEO Bulk Admin и анализа лог-файлов

Если ваша команда не может напрямую просматривать журналы сервера, SEO Bulk Admin предоставляет простой, прямой метод для мониторинга работы AI ботов и использования этой информации для улучшения вашей SEO производительности.

Использование данных AI Crawler для улучшения контент-стратегии

После того, как вы начнете отслеживать, как AI боты исследуют ваш веб-сайт, вы действительно сможете начать улучшать свой контент. Информация, которую предоставляют эти боты, показывает, что работает, а что нет, позволяя вам принимать более разумные решения на основе данных, а не просто гадать.

Вот как использовать эти сведения:

1. Определите контент, который предпочитает ИИ

- Страницы с высокой частотой посещений: Ищите страницы, которые AI-краулеры посещают наиболее часто. Это те фрагменты контента, к которым эти боты постоянно получают доступ, вероятно, потому, что они считают их релевантными, авторитетными или часто обновляемыми по темам, по которым запрашивают информацию их пользователи.

- Определенные типы контента: Получают ли ваши руководства, страницы определений, обзоры исследований или разделы часто задаваемых вопросов непропорционально большое внимание со стороны AI-краулеров? Это может показать, какой тип информации наиболее востребован AI-моделями.

2. Выявление популярных шаблонов контента, предпочитаемых LLM.

- Актуальность структурированных данных: Являются ли активно просматриваемые страницы также богатыми структурированными данными (разметка Schema)? Это предмет открытых дискуссий, но некоторые предполагают, что модели искусственного интеллекта часто используют структурированные данные для более эффективного и точного извлечения информации.

- Ясность и краткость: Модели ИИ превосходно обрабатывают ясный и однозначный язык. Контент, который хорошо работает с AI-краулерами, часто содержит прямые ответы, короткие абзацы и чёткое разделение по темам.

3. Создайте чертёж на основе высокоэффективного контента.

- Успешный реверс-инжиниринг: Для вашего лучшего контента, полученного с помощью ИИ-краулера, задокументируйте его характеристики.

- Структура контента: Заголовки, подзаголовки, маркированные списки, нумерованные списки.

- Формат контента: Текстовый, смешанный, интерактивные элементы.

- Topical depth: Comprehensive vs. niche.

- Ключевые слова/Сущности: Конкретные термины и сущности, которые часто упоминаются.

- Реализация структурированных данных: Какие типы схем используются?

- Внутренняя перелинковка: Как этот контент связан с другими релевантными страницами?

- Улучшайте контент с низкой производительностью: Примените эти успешные атрибуты к контенту, который в настоящее время получает меньше внимания со стороны AI-краулеров.

- Улучшите структуру контента: Разбейте плотные абзацы, добавьте больше заголовков и используйте маркированные списки.

- Внедрите структурированные данные: Реализуйте соответствующую разметку Schema (например, `Q&A`, `HowTo`, `Article`, `FactCheck`) на страницах, где она отсутствует.

- Повысьте чёткость: Перепишите разделы, чтобы добиться краткости и прямоты, сосредоточившись на чётком ответе на потенциальные вопросы пользователей.

- Улучшите внутреннюю перелинковку: Убедитесь, что соответствующие страницы с низкой эффективностью связаны с вашим контентом, предпочитаемым ИИ, и наоборот, сигнализируя о тематических кластерах.

Это быстрое видео показывает вам, как узнать, какие страницы вашего веб-сайта посещают AI-боты чаще всего, и как использовать эти знания для улучшения производительности вашего сайта.

https://www.youtube.com/watch?v=_pv8lufSBb4

Вот запрос, использованный в видео:

Вы — эксперт в области SEO на основе искусственного интеллекта и анализа поведения поисковых роботов.

Пожалуйста, выясните, почему поисковый робот OpenAI, oai-searchbot, посетил страницу об оплате налогов с помощью кредитной карты (https://fioney.com/paying-taxes-with-a-credit-card-pros-cons-and-considerations/) пять раз за последний месяц, но проверил страницу обзора Discover Bank (https://fioney.com/discover-bank-review/) только дважды. Нам нужно понять разницу в частоте сканирования для этих двух URL.

ЦЕЛИ:

Определите технические SEO-проблемы, которые могут привести к тому, что поисковые системы будут реже сканировать ваш веб-сайт. Сюда входят такие вещи, как то, насколько хорошо ваши страницы связаны друг с другом внутренними ссылками, как недавно вы обновляли свой контент, как настроена ваша карта сайта и используете ли вы структурированные данные.

Как человек, который годами создавал и управлял веб-сайтами, я узнал, что действительно хороший контент — это не только ключевые слова. Теперь я сосредотачиваюсь на таких вещах, как то, действительно ли материал устанавливает нас в качестве авторитета в данной области, естественно ли другие сайты захотят на него ссылаться и – все чаще – предоставляет ли он тот вид информации, который ищут большие языковые модели, когда им нужно указать источники. Именно эти сигналы действительно важны сейчас.

Выясните, какие факторы влияют на то, как системы AI-индексирования – такие как та, которую использует OpenAI – решают, какие страницы сканировать и показывать в результатах поиска.

ОГРАНИЧЕНИЯ:

– Не угадывайте поведение пользователей; сосредоточьтесь только на алгоритмических и контентных сигналах

– Используйте формат списка с маркерами или таблицы сравнения

– Не давайте общих SEO-советов; адаптируйте вывод конкретно к предоставленным URL-адресам

– Учитывайте недавние тенденции LLM в цитировании и приоритеты системы полезного контента

ФОРМАТ:

– Часть 1: Сравнение технического SEO

– Часть 2: Сравнение контента на предмет ценности для цитирования AI

Часть 3 посвящена практическим советам, которые помогут Google найти и распознать важность URL-адреса, который не получает много трафика, в конечном итоге повышая его рейтинг в поиске.

Выведите только анализ, без комментариев или резюме.

Для получения дополнительных идей о том, как улучшить ваши AI-подсказки, ознакомьтесь с этой статьей: 4 Prompts to Boost AI Citations.

Использование данных для принятия решений означает, что вы можете перестать полагаться на предположения и создать план AI-контента, основанный на том, как люди на самом деле используют ваш веб-сайт.

Финальные мысли об оптимизации ИИ

Чтобы оставаться конкурентоспособными в связи с ростом ИИ в поиске, SEO-специалистам теперь необходимо активно отслеживать и понимать, как ведут себя AI-краулеры.

Вы можете создать контент-стратегию, которая хорошо работает с ИИ, анализируя файлы журналов вашего веб-сайта – или используя такой инструмент, как SEO Bulk Admin, чтобы упростить этот процесс.

Оставайтесь на шаг впереди, отслеживая закономерности в том, как AI-боты исследуют ваш веб-сайт. Затем улучшите ваш самый популярный контент и доработайте страницы, которые работают не так хорошо. Это поможет вам добиться наилучших результатов.

Теперь, когда искусственный интеллект меняет то, как люди ищут информацию в интернете, важно обновить свои стратегии и привлечь новых посетителей из голосового и разговорного поиска.

Смотрите также

- Анализ динамики цен на криптовалюту PI: прогнозы PI

- Акции X5. Корпоративный Центр Икс 5: прогноз акций.

- 11 альтернатив копирования изображений для проверки плагиата

- Режим обучения OpenAI привносит управляемое обучение в ChatGPT

- Акции DATA. Группа Аренадата: прогноз акций.

- Google Tests Learn More Links After Ad Text

- Акции OZPH. Озон Фармацевтика: прогноз акций.

- 7 лучших конструкторов целевых страниц для 2026 года

- SEO-специалисты рекомендуют структурированные данные для поиска с помощью ИИ… Почему?

- Акции VKCO. ВК: прогноз акций.

2025-11-10 09:43