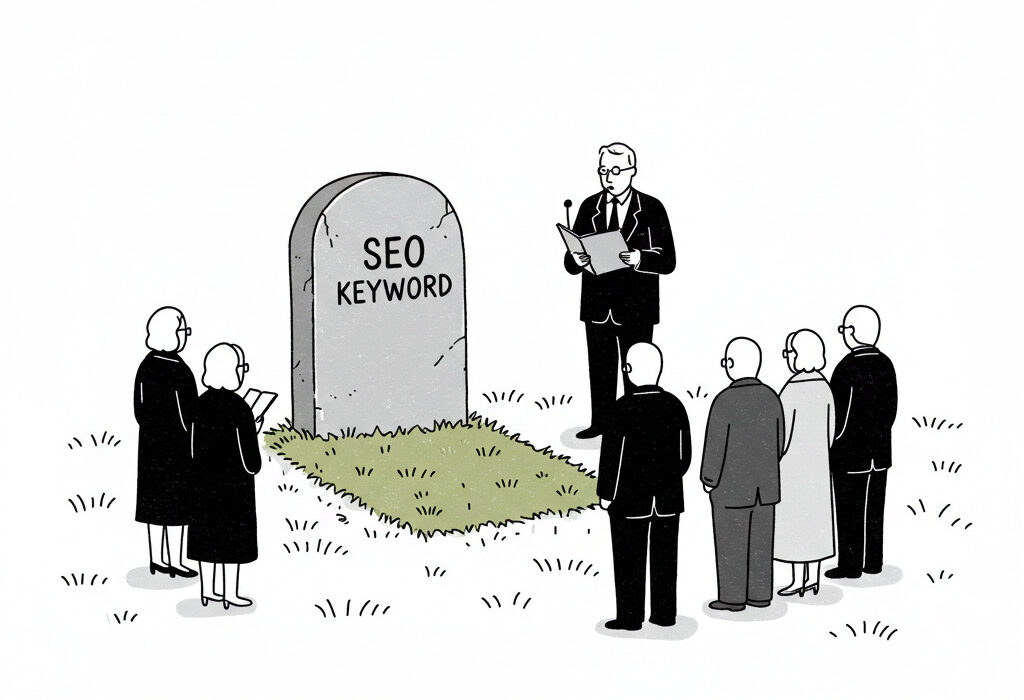

Это моя официальная хвалебная речь ключевому слову SEO, которое умерло много лет назад, но никто этого не заметил.

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)В своей работе в качестве специалиста по цифровому маркетингу я заметил, что некоторые маркетинговые команды иногда принимают не самые оптимальные решения, которые могут подорвать доверие к SEO как надежному каналу. Например, недавний вопль о кончине SEO после падения трафика HubSpot является ярким примером этой тенденции.

Google применяет JavaScript для сканирования

Начиная с 20 января Google ввел обязательное использование JavaScript в своей поисковой системе, что привело к увеличению стоимости отслеживания рейтинга.

Это последний шаг в давней битве между SEO-специалистами и Google.

Инструменты отслеживания рангов, такие как Semrush, Ahrefs и SEOmonitor, функционируют в полуофициальном качестве. Хотя Google признает их существование, он явно не одобряет и не запрещает их использование.

Учитывая, что JavaScript имеет важное значение, очевидно, что для улучшения отслеживания рейтинга требуется больше оперативной памяти (ОЗУ), что, в свою очередь, увеличивает стоимость каждой точки данных.

В результате расходы, связанные с поисковой оптимизацией (SEO), растут. Однако значимость отслеживания рейтинга снизилась задолго до того, как Google начал использовать JavaScript для индексации веб-страниц.

Сосредоточение внимания на отдельных ключевых словах уже давно не имеет смысла

Сложно прогнозировать влияние и оценивать достижения, ориентируясь исключительно на позиции ключевых слов, учитывая разнообразие факторов на страницах результатов поисковой системы (SERP) и непоследовательность собранных данных.

https://www.searchenginejournal.com/wp-json/sscats/v2/tk/Middle_Post_Text

- В 2013 году Google прекратил делиться ключевыми реферерами. Единственным способом понять, что искали пользователи, чтобы попасть на ваш сайт, была и остается Google Search Console.

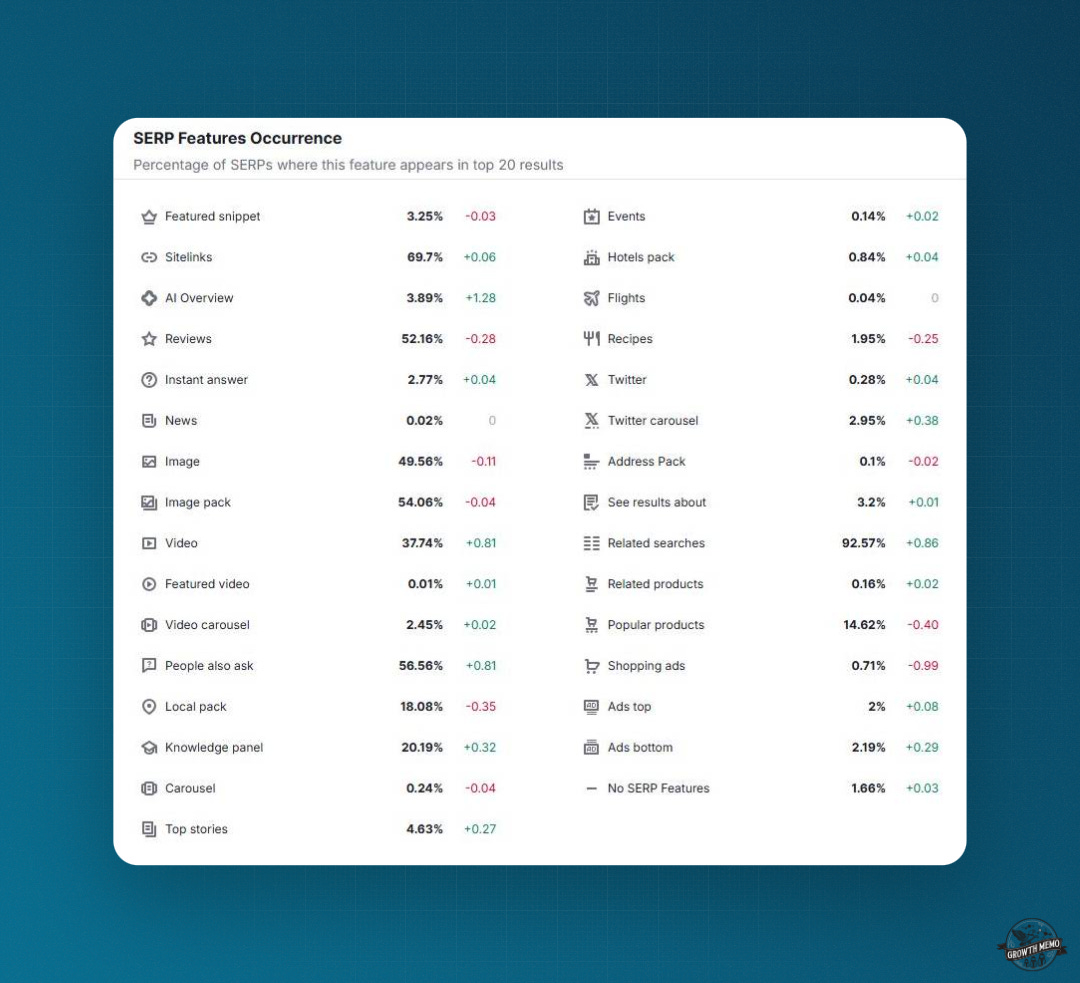

- В 2014 году Google начал показывать избранные фрагменты, прямые ответы в верхней части результатов поиска, что создало больше ситуаций «победитель получает все». Последующие функции SERP, такие как «Также спрашивали» или видеокарусели, последовали и поднялись в рейтинге. Сегодня более 30 известных функций SERP конкурируют за внимание с классическими результатами поиска. Очень сложно предсказать, сколько кликов вы можете получить, потому что существует так много комбинаций функций SERP.1

- С прошлого года Google показывает рекламу в органических результатах поиска и сломал традиционное разделение между органическими и платными результатами.

- И, конечно, в прошлом году Google запустил AI Overviews. Ответы AI теперь доступны в более чем 100 странах и дают подробные ответы. Переход к результатам поиска теперь в некоторых случаях излишен.

- Данные, которыми Google делится по этим тенденциям, варьируются от несуществующих до пустых. Обзоры ИИ или функции SERP не включены в данные Search Console. Не говоря уже о том, что Google отфильтровывает 50% данных запросов по «причинам конфиденциальности»: Ahrefs изучил 150 000 веб-сайтов и обнаружил, что около 50% ключевых слов и кликов скрыты.2

Одна веб-страница может потенциально появляться в результатах поиска по нескольким связанным фразам или вопросам, при условии, что эти фразы имеют одну и ту же основную цель, и страница предлагает соответствующие ответы на все подразумеваемые запросы. Это явление наблюдается уже много лет.

Вместо этого все больше поисковых запросов больше не генерируют трафик на сайт, поскольку пользователи остаются на страницах результатов поисковой системы (SERP) благодаря таким функциям, как избранные фрагменты, где ответы предоставляются напрямую, что устраняет необходимость в щелчке мыши.

Sparktoro обнаружил, что +37% поисковых запросов заканчиваются без клика, а +21% приводят к другому поиску.3

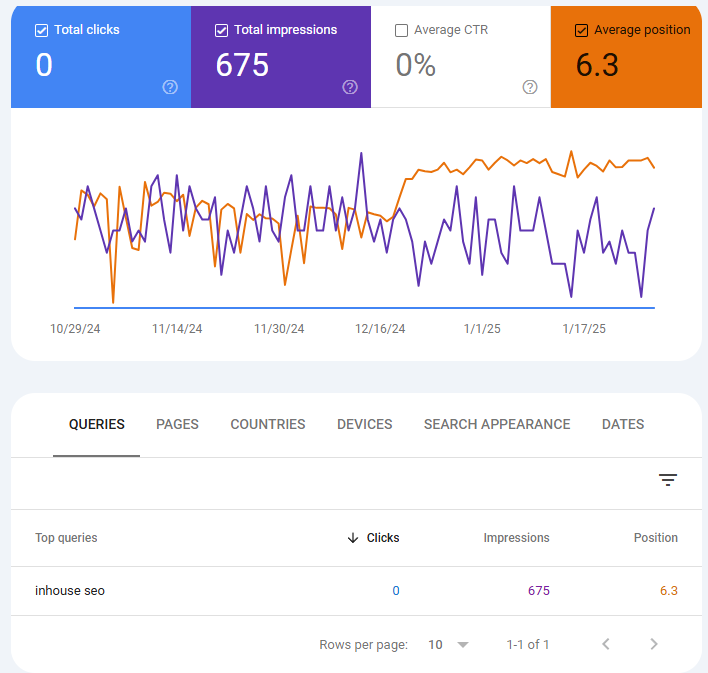

Несколько месяцев назад я пересмотрел свой внутренний SEO-руководство и поднялся на первое место в результатах поиска. Однако оказалось, что меня обманули. Несмотря на то, что я был на первом месте, я не получил вообще ни одного клика по этому ключевому слову.

Более 200 человек ищут [внутреннее SEO], но ни один из них не нажимает на результат поиска.

Кстати, Google Analytics показывает всего 10 кликов из органического поиска за последние три месяца.

Кажется, есть несоответствие: 10 полученных мной кликов не отображаются в Google Search Console, возможно, из соображений конфиденциальности. Однако, похоже, что большинство пользователей вместо этого нажимают на раздел «Люди также спрашивают», который следует за моим результатом поиска.

Общая картина такова, что ценность ключевых слов и рейтингов упала.

Наш ответ может быть двояким:

- Во-первых, хотя всеобъемлющей целью по-прежнему должно быть ранжирование наверху, нам нужно нацелиться на элемент, который, скорее всего, привлечет все внимание в SERP, например, видеокарусели или ответы ИИ. В некоторых случаях это означает расширение «SEO» на другие платформы, такие как YouTube.

- Во-вторых, нам необходимо рассмотреть совокупные данные.

Совокупный трафик > Ключевые слова

В настоящее время наш подход к поисковой оптимизации (SEO) вращается вокруг устаревшего метода. В этом методе мы фокусируемся на предопределенном наборе ключевых слов как на показателях успеха и устанавливаем цели на их основе.

За годы работы в качестве опытного веб-мастера я часто размышляю над логикой ранжирования веб-страниц по многочисленным ключевым словам. Это интригует, но иногда и озадачивает, не так ли? Аналогично, когда дело доходит до поисковых запросов, переход от списка результатов к ответам LLM (Latent Long-tail Match) может иногда показаться немного нетрадиционным. Все это часть увлекательного мира SEO и поисковых алгоритмов, где мы стремимся понять танец между намерением пользователя, ключевыми словами и наиболее релевантным контентом.

В будущем в поиске будет иметь значение не конкретное ключевое слово, а намерение пользователя. Модели изучения языка (LLM) отлично справляются с расшифровкой этих намерений.

Как эксперт по SEO, я хотел бы подчеркнуть изменение в нашем подходе: вместо того, чтобы нацеливаться исключительно на определенные ключевые слова, давайте сосредоточимся на создании органического трафика на уровне страниц и доменов. Эта стратегия обеспечивает более целостный и эффективный процесс оптимизации.

Вот несколько ловушек, на которые следует обратить внимание:

- Нам по-прежнему нужны ключевые слова для моделирования брендового и небрендового трафика по страницам (это все еще работает, поскольку у вас должно быть достаточно ключевых слов).

- Остерегайтесь сезонности.

- Разделите органический трафик на новые и существующие страницы.

Для мониторинга производительности веб-сайта или определенной страницы изучение соответствующих ключевых слов остается полезным. Однако тенденция органического (неоплачиваемого) трафика обычно является более сильным индикатором его успеха или неудачи.

Одной из основных проблем, с которой я сталкиваюсь в отношении ключевых слов, является то, что их поисковый объем часто содержит существенные ошибки и не может точно отражать текущую ситуацию или тенденции.

«Внутреннее SEO» — это термин, объем поиска по которому в основных инструментах отслеживания составляет 90–200, но, похоже, он не генерирует никаких реальных переходов по ссылкам.

Один из простых методов определения того, какие страницы следует создать, не полагаясь на исследование ключевых слов, — это непосредственное взаимодействие с клиентами и наблюдение за проблемами и темами, которые их интересуют или о которых они часто спрашивают.

Проанализируйте такие платформы, как Reddit и YouTube, на предмет вовлеченности и определите, какие темы работают.

Как специалист по цифровому маркетингу, я часто обнаруживаю, что использую данные платного поиска для руководства своими стратегиями SEO. Это связано с тем, что способ, которым Google отображает объявления Performance Max в результатах поиска, которые напоминают намерения пользователя, предлагает более точное отражение популярных тем и поведения пользователей. Другими словами, анализ данных платного поиска помогает мне лучше понять, что на самом деле ищут пользователи, что позволяет мне соответствующим образом оптимизировать свои усилия по SEO.

Чтобы спрогнозировать модели трафика, изучите веб-сайты или веб-страницы, которые в настоящее время появляются по интересующим нас темам, но не обязательно на основе конкретных ключевых слов.

Данные о поведении при просмотре веб-страниц, или данные о кликстриме, более надежны, поскольку они не предсказывают трафик на основе рейтингов ключевых слов. Вместо этого они дают представление о фактических моделях навигации пользователя в сети.

Один из методов перефразирования: Когда дело доходит до оценки исторических поисков ключевых слов, чтобы определить, расширяется или сокращается тема, полезно использовать значительные объемы этих конкретных терминов. Однако я рекомендую сосредоточиться исключительно на более крупных наборах ключевых слов.

Одним из преимуществ использования метода агрегированного трафика является его адаптивность к большим языковым моделям (LLM), поскольку эти модели не предоставляют запросы, а вместо этого позволяют отслеживать реферальный трафик как на уровне домена, так и на уровне страницы.

ChatGPT даже добавляет параметр URL к исходящим кликам, что упрощает отслеживание.

Защита LLM: Активирована

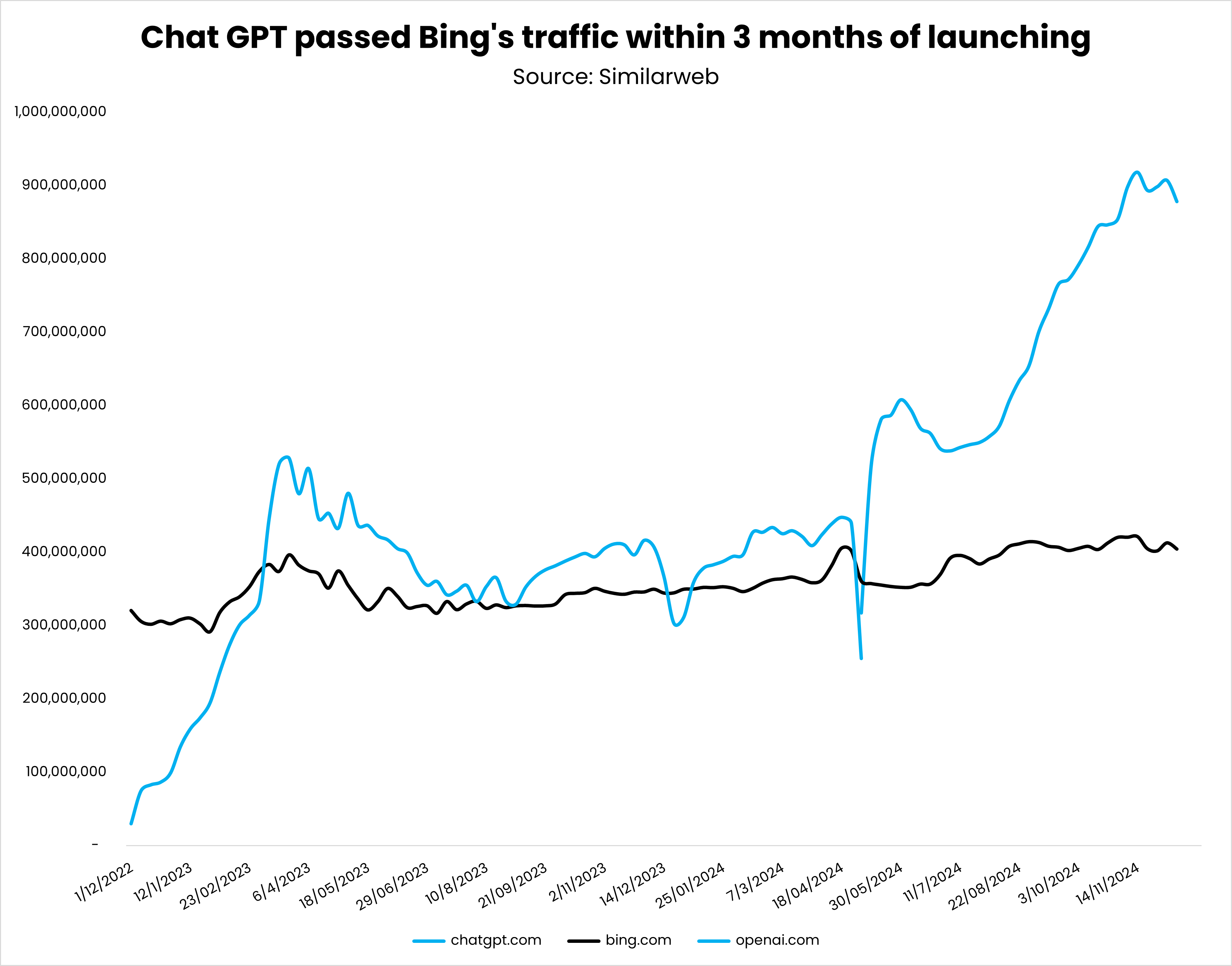

Google применяет сканирование JavaScript в первую очередь не для того, чтобы создать неудобства для SEO-специалистов, а скорее для противодействия потенциальной конкуренции со стороны поисковых систем на основе искусственного интеллекта.

Прогресс ChatGPT и метрики Perplexity делает заметные шаги. На данный момент ChatGPT удалось превзойти Bing и Gemini от Google по трафику. Между тем, Perplexity, похоже, следует их примеру.

Другими словами, поскольку сканеры LLM не имеют возможности запускать JavaScript, они теперь не могут сканировать результаты поиска Google, чтобы основывать свои ответы на этой информации.

Убедитесь, что ваш контент доступен без JavaScript, так как это позволит поисковым системам легко его сканировать. Если контент основан на JavaScript, он может не отображаться в результатах поиска, предоставляемых моделями изучения языка (LLM).

Некоторые крупные языковые модели (LLM) могут испытывать временное снижение производительности из-за принудительного использования JavaScript компанией Google, но в настоящее время они по-прежнему могут получать данные со страниц результатов поиска (SERP) с помощью альтернативных методов.

Следовательно, существует вероятность, что разработчики моделей изучения языка смогут создать свои собственные модели или поисковые базы данных для оценки ответов, тем самым снизив зависимость от поисковых систем.

Проще говоря, выполнение хорошей поисковой оптимизации (SEO) само по себе больше не гарантирует видимость в системах управления обучением (LLM). Вместо этого нам, возможно, придется анализировать и воспроизводить факторы, которые влияют на результаты поиска LLM, подобно тому, как мы в прошлом провели обратную разработку системы ранжирования Google.

В контексте SEO успех больше не заключается исключительно в манипуляции ключевыми словами. Вместо этого важно адаптировать стратегии в соответствии с развивающимся намерением или направлением «игры», а не сосредотачиваться чрезмерно на традиционных «картах» или ключевых словах.

Будущее поиска — не ключевые слова, а намерения.

Пусть это будет моей официальной хвалебной речью.

Смотрите также

- Акции IRKT. Яковлев: прогноз акций.

- YouTube запускает платные курсы для большего количества каналов

- Анализ динамики цен на криптовалюту LSETH: прогнозы LSETH

- Google удаляет хлебные крошки из фрагментов результатов мобильного поиска

- Обновления тенденций 2024 года: что действительно работает в SEO и контент-маркетинге через @sejournal, @lorenbaker

- Акции GCHE. Группа Черкизово: прогноз акций.

- Акции AGRO. РусАгро: прогноз акций.

- Google заявляет, что невозможно заблокировать контент из ленты Discover

- Google подтверждает, что файл robots.txt не может предотвратить несанкционированный доступ

- Ответы на вопросы по SEO на YouTube

2025-02-04 17:40