Недавно Google усовершенствовал свою поисковую функциональность на базе ИИ, представив новые возможности поиска изображений, доступные теперь большему числу пользователей по всей территории США.

Купил акции на все деньги, а они упали? А Илон Маск снова написал твит? Знакомо. У нас тут клуб тех, кто пытается понять этот цирк и не сойти с ума.

Купить на падении (нет)Теперь вы можете публиковать изображения и задавать вопросы о их содержании. Этот инструмент сочетает возможности визуального распознавания Google Lens с навыками решения проблем Geminis.

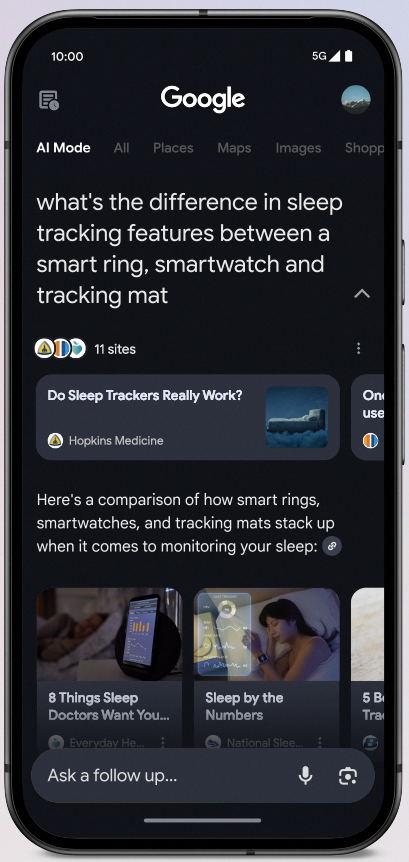

Что такое режим AI в поиске Google?

Последнее дополнение Google к поисковым лабораториям, режим AI, позволяет задавать сложные вопросы и предоставляет результаты созданные ИИ с соответствующими веб ссылками и дополнительными предложениями для запросов.

Компания Google сообщает, что запросы в режиме ИИ обычно вдвое длиннее обычных поисковых запросов.

Люди используют это для:

- Открытые вопросы

- Сравнение продуктов

- Нахождение инструкций по использованию

- Планирование путешествий

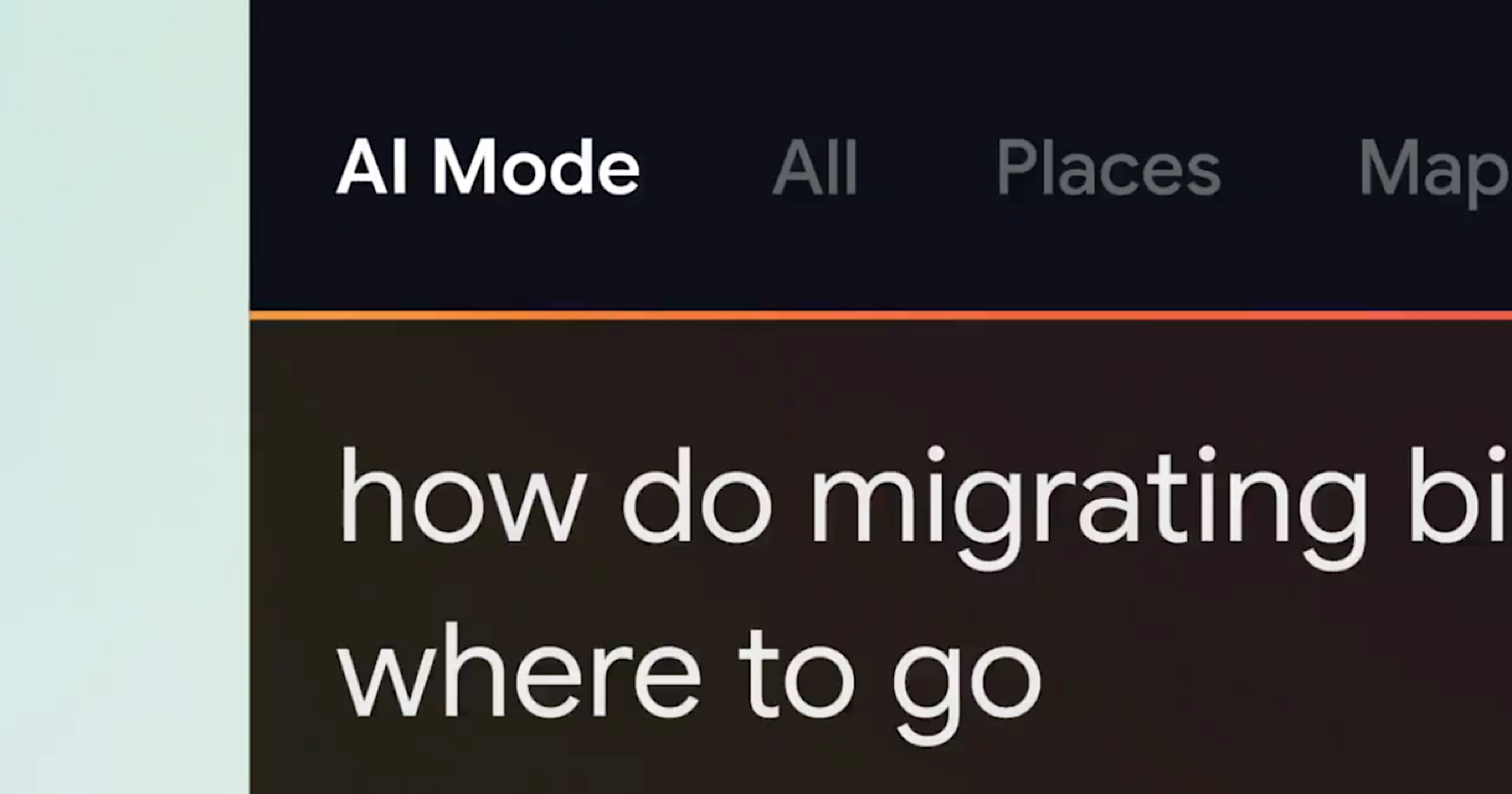

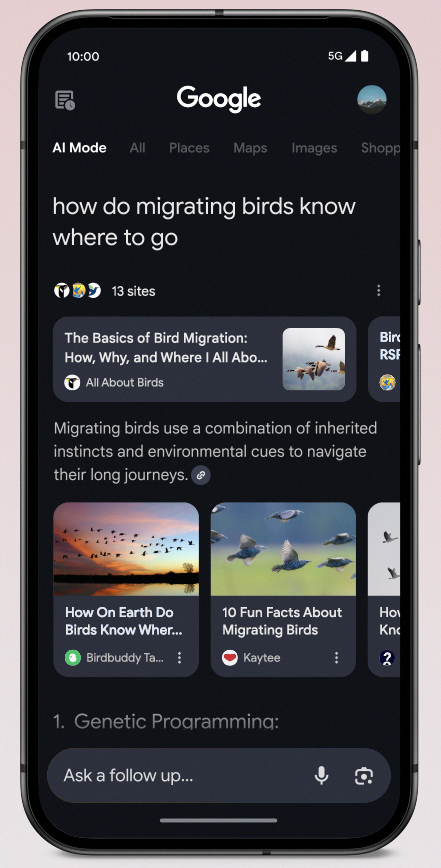

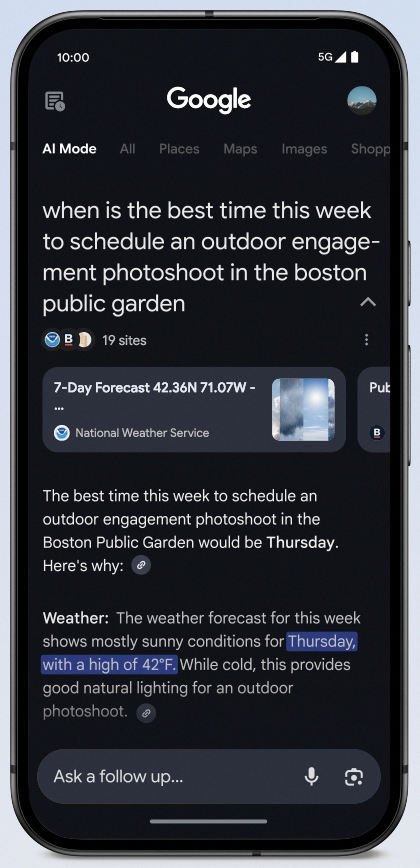

Примеры

Вот примеры того, как режим AI обрабатывает некоторые из самых популярных типов запросов.

Открытые вопросы:

Планирование поездок

Сравнение продуктов:

Мультимодальный поиск доступен в режиме AI

В режиме AI теперь доступны возможности мультиволнового поиска (multimodal), что позволяет пользователям:

- Делайте фотографии или загружайте изображения

- Спроси об этих картинках.

- Получите подробные ответы, которые понимают всю картину.

- Нажмите на веб-ссылки, чтобы узнать больше о объектах на изображении

Например, когда вы публикуете фотографию книжной полки, режим ИИ анализирует видные книги и рекомендует другие произведения в аналогичном жанре или тематической области, предоставляя ссылки на их покупку.

Система способна распознавать отдельные элементы и их связи вплоть до таких тонких деталей как текстуры и оттенки.

Как работает мультимодальный поиск в режиме ИИ

Новая система Google работает в нескольких шагах:

- Джемини рассматривает изображение в целом и то, как объекты связаны друг с другом.

- Google Lens распознает конкретные объекты на фотографии

- Система выполняет несколько поисков как по всему изображению, так и по отдельным предметам.

- Это собирает больше информации, чем обычный поиск.

- Наконец, это создает детальный и релевантный ответ

Что это значит?

Это расширение режима AI показывает инвестиции Google в искусственный интеллект и поисковую оптимизацию помимо традиционных ключевых слов.

Для специалистов по SEO и маркетингу это означает:

- Визуальный контент становится всё более важным, так как Google лучше разбирается в изображениях.

- Видимость экокоммерции может зависеть от того, как товары отображаются в этих новых результатах поиска.

- Запросы длиннее становятся обычным делом, при этом поиск в режиме ИИ вдвое дольше обычного.

- Вопросы людей становятся все сложнее, особенно когда речь идет о сравнении продуктов или изучении тем.

Доступность и доступ

Режим AI все еще является частью программы Google Search Labs. Чтобы использовать его, вам необходимо:

- Находиться в США и быть не менее 18 лет

- Последнее приложение Google или браузер Chrome

- Включите историю поиска

У вас есть несколько способов активировать режим AI: 1. Введите google.com/aimode непосредственно в ваш веб-браузер и нажмите клавишу Enter. 2. Перейдите на главную страницу google.com, затем коснитесь кнопки ‘AI Mode‘, расположенной под поисковой строкой. 3. Также можно получить доступ к режиму AI через приложение Google.

Смотрите также

- Акции BSPB. Банк Санкт-Петербург: прогноз акций.

- Чек-лист WordPress SEO: Подготовьтесь к (запуску) сайта

- Акции взлетают на фоне крипто-соглашения: История дикого рынка предсказаний.

- Акции OZPH. Озон Фармацевтика: прогноз акций.

- 5 ключевых тенденций корпоративного SEO и искусственного интеллекта на 2025 год

- Бинг размещает рекламу в сниппетах функций с названием «Вы также можете понравиться»

- Агентный ИИ в SEO: ИИ-агенты и будущее контент-стратегии (Часть 3)

- 70% биткоина, 30% шока: формула кошелька миллиардера разоблачает финансовый парк юрского периода

- Акции UWGN. ОВК: прогноз акций.

- 4,10 миллиарда токенов SHIB уничтожено: Великая сага о сжигании криптовалюты!

2025-04-07 19:09